Estos 8 algoritmos públicos sobre los que apenas se sabe nada ya toman decisiones que afectan a tu día a día

- Eticas, una de las consultoras especializadas en auditoría algorítmica más potentes de España, enumera en un informe 8 algoritmos que ya usan la Administración Pública.

- La mayoría está en manos de cuerpos policiales, pero el patrón común es que hay poca información y poco auditado sobre cómo funcionan estos procesos automatizados.

- Comienza el día bien informado con la selección de noticias de Business Insider España: suscríbete gratis aquí.

Un algoritmo es mucho más que una inocente secuencia matemática. En función de quién y cómo lo desarrolle, este algoritmo puede proyectar sesgos de su creador. De esta manera, procesos automatizados pueden estar generando enormes riesgos a amplias capas de la población, haciendo a colectivos más vulnerables cuando no menoscabando sus derechos más fundamentales.

Si el algoritmo de una entidad financiera determina la solvencia de una persona que pide la hipoteca, este determinará como parámetros cuáles son sus ingresos, sus gastos y su capacidad de ahorro. Pero se han encontrado casos de algoritmos en este ámbito que contemplaban otros parámetros como el género, con lo que las mujeres, al estar menos bancarizadas, eran perfiles de mayor riesgo.

De esta forma, por culpa de un proceso automático, muchas mujeres estaban viéndose discriminadas a la hora de pedir una hipoteca o incluso a la hora de encontrar trabajo en portales de búsqueda de empleo.

Regular los algoritmos es uno de los mayores desafíos contemporáneos. Se habla de ello desde hace años, aunque el debate en realidad es incipiente. A nivel europeo, la Comisión ya presentó en abril del año pasado un borrador de Reglamento de Inteligencia Artificial. El Gobierno propuso a España como escenario de un sandbox regulatorio que arrancará presumiblemente después de verano.

También el Gobierno, a través de la nueva ley rider, introdujo la necesidad de que representantes de los trabajadores (sindicatos y comités de empresa) pudieran acceder a la información crítica de todos aquellos algoritmos que les puedan afectar en el ámbito laboral, aunque los sindicatos piden más herramientas para poder incluso negociarlos.

Pero estos algoritmos, que según varias voces de expertos deben ser transparentes, explicables y auditables, también están presentes en las instituciones públicas. Eticas, la consultora especializada en auditorías algorítmicas que fundó Gemma Galdon, una de las mayores especialistas en España de este ámbito, lo recuerda este miércoles.

Eticas puso en marcha el año pasado el OASI, Observatorio de Algoritmos de Impacto Social. Aunque según la ley estos algoritmos públicos deben estar auditados, Eticas recuerda cómo el Gobierno todavía litiga con la fundación Civio después de que se negase a liberar el código de BOSCO, el algoritmo que regula el bono social para el pago de la factura de la luz.

En un informe, la consultora de Galdon destaca cuáles son algunos de los algoritmos públicos que más riesgos tienen para los ciudadanos. La mayoría de ellos están en poder de las Fuerzas y Cuerpos de Seguridad del Estado.

8 tipos de algoritmos públicos que ya te afectan en tu día a día

Un ejemplo de ellos es el sistema VioGén, que sirve para detectar "el riesgo de reincidencia de agresores en caso de violencia de género". "De este algoritmo se conoce cómo se diseñó y cómo funciona", reconoce Eticas. "Sin embargo, el código sigue sin revelarse, ni qué peso tienen las diferentes preguntas del protocolo para que el algoritmo genere una puntuación de riesgo".

Otro es uno de los más mediaticos: RisCanvi es un sistema empleado en el sistema penitenciario de Cataluña desde hace ya cerca de 13 años, y calcula la probabilidad con la que un preso que está en libertad vuelva a reincidiri.

Tensor es un proyecto europeo cuyo propósito era crear una plataforma para que las policías de todo el continente puedan detectar, lo antes posible, actividades de terroristas en la red, como radicalización o células de reclutamiento. Pero precisamente por su naturaleza, hay muy poca información libre sobre el mismo: ni siquiera si se sigue utilizando, por quién ni con qué objetivos.

Si llamas a la policía y esta te ignora, es probable que un algoritmo llamado VeriPol haya puntuado tu tono de voz y tu forma de expresarte para calcular si tu denuncia es falsa. Es un sistema de procesamiento del lenguaje y aprendizaje automático que conlleva riesgos de discriminación, ya que aquellas personas que no dominen el español podrían sufrir falsos positivos.

Además, VeriPol también se emplea para identificar lenguaje de odio u otro tipo de amenazas en redes sociales, destaca Eticas.

Los algoritmos encargados de filtrar los currículums no están haciendo bien su trabajo

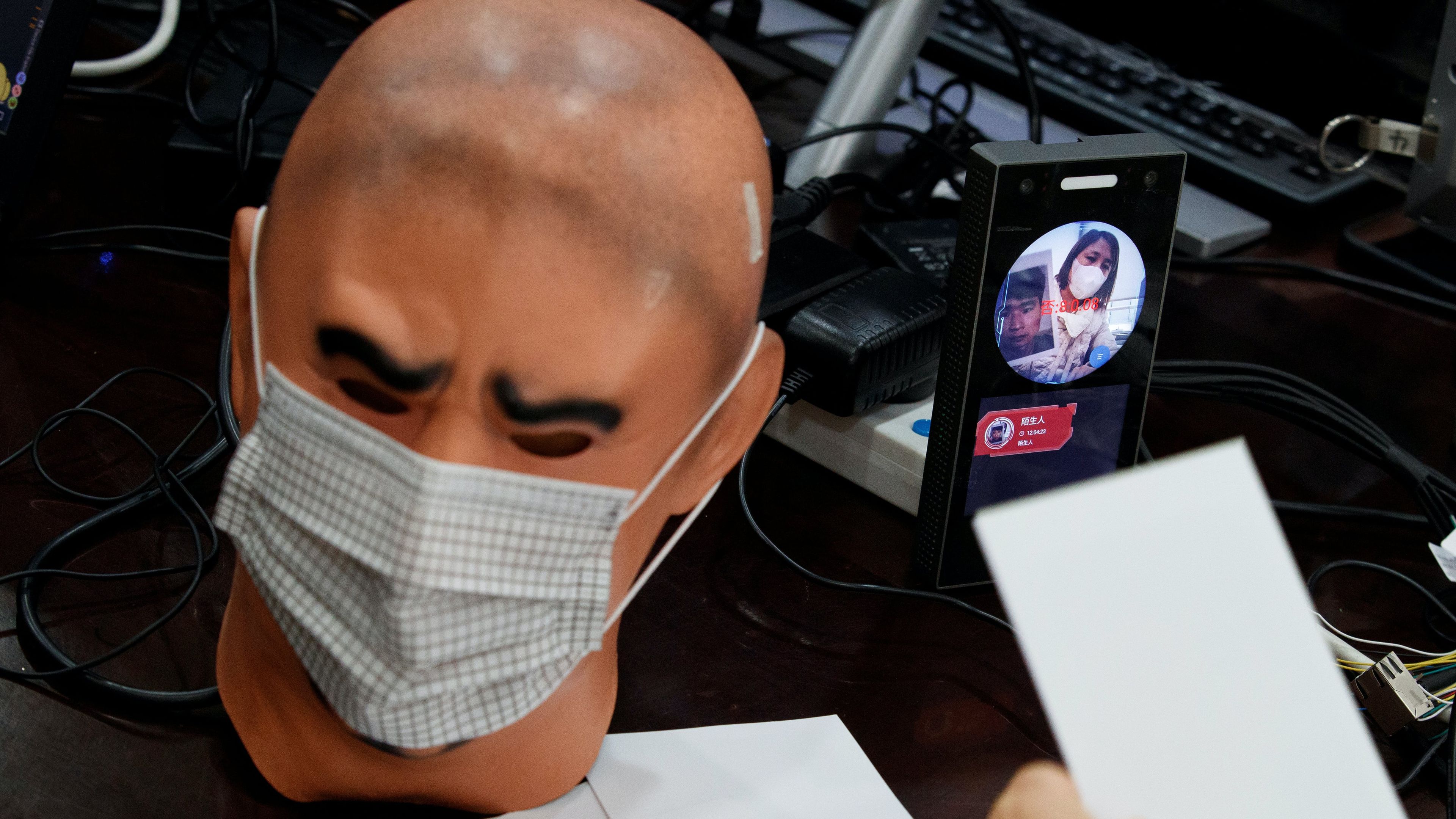

Otros modelos que las policías ya pueden emplear son los sistemas de reconocimiento facial. Precisamente España trabaja desde hace años en la creación de una frontera inteligente en el único paso terrestre que hay entre la UE y África: en Ceuta y en Melilla. La posibilidad de instalar modelos de reconocimiento facial ya han llevado a exigir garantías por parte de partidos y colectivos sociales.

Otros algoritmos están en manos de las administraciones que se encargan de proveer de servicios sociales. ISSA es el chatbot de la Seguridad Social. Su código tampoco es público, denuncia Eticas, con lo que puede estar ofreciendo "las mismas respuestas a diferentes usuarios dependiendo de cómo se expresen", con lo que la posibilidad de discriminación a no hispanohablantes es alta.

BOSCO es el modelo que regula el bono social para el pago de la factura de la luz: revisa las solicitudes e incluso decide el resultado. Pero como se señalaba antes, una fundación, Civio, litiga con el Gobierno ya que el mismo rechaza liberar el código.

También hay algoritmos asociados al Servicio Estatal Público de Empleo, como SEND@, que hace una búsqueda entre perfiles semejantes que buscan empleo y ofrece recomendaciones formativas a quienes tienen una mejor trayectoria. "Históricamente algunos grupos de personas han sido discriminados a la hora de buscar un empleo como las mujeres y las minorías sociales".

Por eso, Eticas entiende que el algoritmo "corre el riesgo de reforzar ese tipo de discriminación, y además puede no tener en cuenta las diferencias y la diversidad entre los demandantes de empleo". "Además el SEPE utiliza una plataforma automatizada para determinar las prestaciones por desempleo y distribuir las oportunidades de empleo y formación laboral entre los desempleados".

Galdon, la fundadora de Eticas, destaca tras hacer este recopilatorio de algoritmos en instituciones públicas que en su compañía quieren que los ciudadanos "sean conscientes de la presencia de algoritmos y de lo influyentes que son en nuestro día a día".

"Por este motivo, queremos sistemas algorítmicos justos, éticos para la sociedad y transparentes con la información que manejan y el uso que hacen de ella, sobre todo desde los servicios e instituciones públicas", recalca.

Otros artículos interesantes:

Descubre más sobre Alberto R. Aguiar, autor/a de este artículo.

Conoce cómo trabajamos en Business Insider.