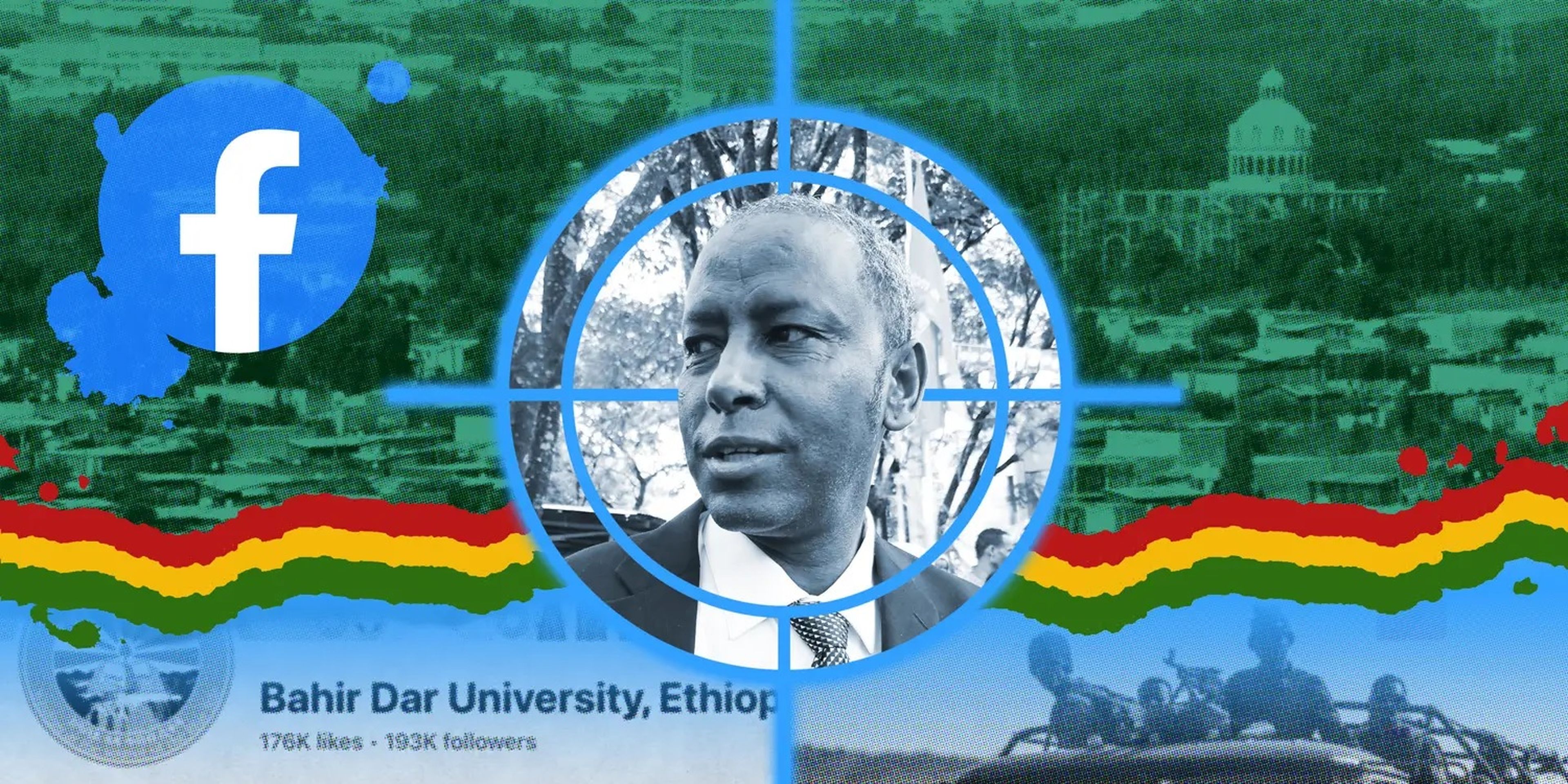

Un profesor fue asesinado después de que un post de Facebook lo tachara de traidor: ¿fue Facebook cómplice de su muerte?

Will Varner/Insider; photo courtesy of Amare family; Goddard Photography/Getty Images; Ben Curtis/AP

- Semanas antes del asesinato en 2021 de Meareg Amare en Etiopía, su hijo y un colaborador de Facebook afirman haber advertido a la red social sobre publicaciones de odio que amenazaban su vida.

- Tras su asesinato, 6 etíopes que pertenecen a un programa de revisión de contenido de Facebook declaran a Business Insider que la plataforma ignoró sistemáticamente sus peticiones de retirar contenidos que incitaran al odio.

La primera publicación en Facebook sobre el profesor Meareg Amare apareció 5 semanas antes de su asesinato.

El profesor, de 60 años, era conocido por ser un pilar de su comunidad en Bahir Dar, capital de la región etíope de Amhara. Era autor de 4 libros de Química para estudiantes de secundaria y bachillerato, y a veces aparecía en la televisión local, donde animaba a los jóvenes a dedicarse a las ciencias.

El 9 de octubre de 2021, apareció un post sobre Amare en una página de Facebook sobre personal de la Universidad Bahir Dar. El usuario había publicado la foto del profesor junto a un pie de foto que decía: "Se llama profesor Meareg Amare Abrha. Es tigrayano. Os contaremos cómo se escondió en la Universidad Bahir Dar y cometió abusos".

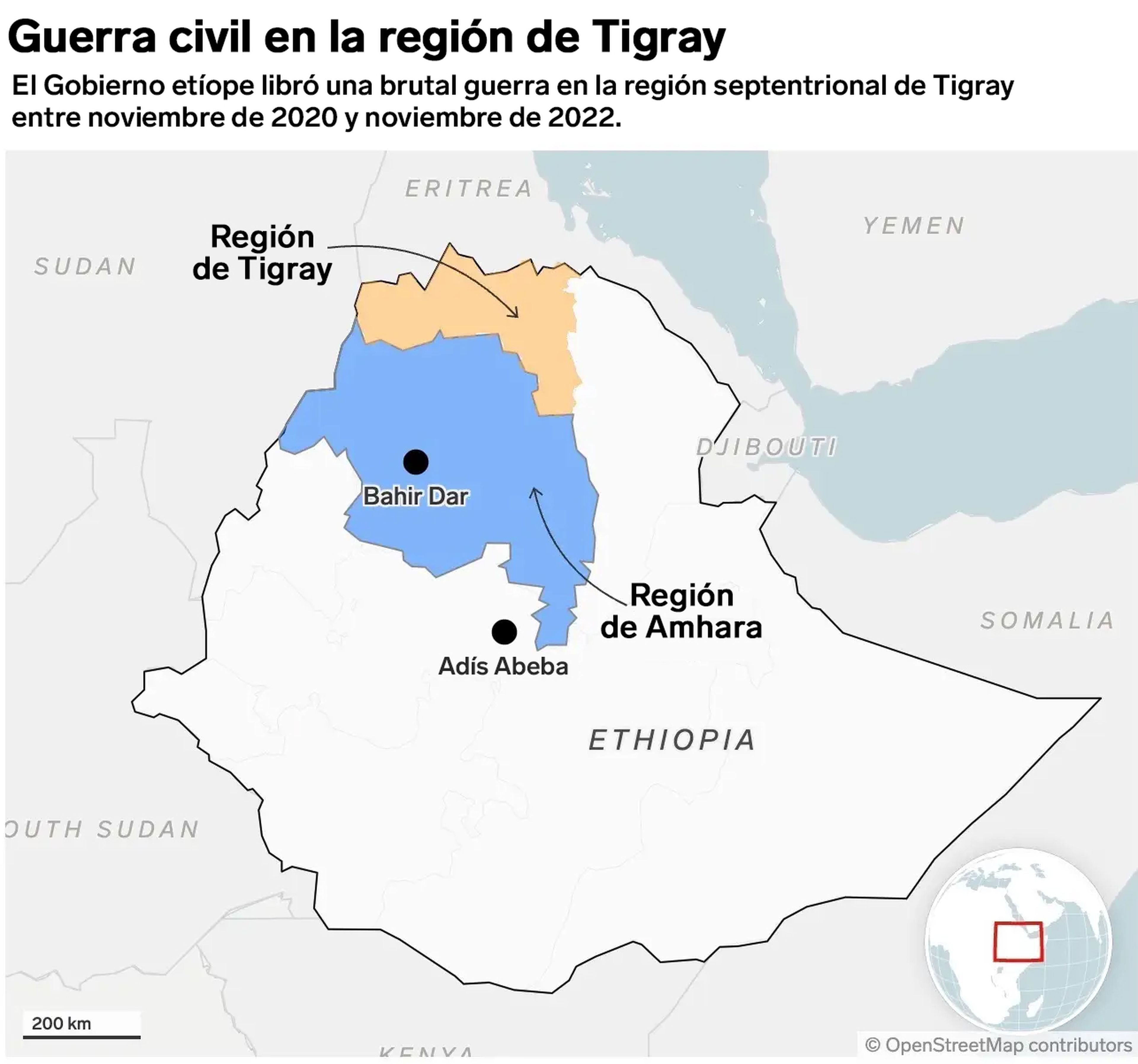

En los meses anteriores a la publicación, las fuerzas federales de Etiopía (un país de 120 millones de habitantes con 5 lenguas oficiales) habían estado sumidas en la confusión debido a la guerra civil que asolaba Tigray, la región más septentrional de Etiopía y fronteriza con Eritrea. Aunque el apagón de internet en Tigray hizo casi imposible saber exactamente lo que estaba ocurriendo allí, las asociaciones de derechos humanos documentaron matanzas, desplazamientos y destrucción por parte de las fuerzas federales etíopes, las fuerzas regionales de Amhara y otros grupos aliados. Human Rights Watch denunció la limpieza étnica llevada a cabo por las fuerzas de Amhara, con ayuda de las fuerzas federales etíopes, contra los tigrayanos en las zonas occidentales de la región. El conflicto se había extendido a Amhara, y se acusó a militantes tigrayanos de ejecutar a civiles amhara.

En toda Etiopía se perseguía a tigrayanos de alto perfil, como el profesor Amare.

Mapa: Chay Thawaranont/Business Insider

El 10 de octubre (un día después de que apareciera el primer post), un amigo del colegio del hijo del profesor Amare, Abrham Amare, le llamó para advertirle de que había aparecido en Facebook otra publicación mucho más larga. Sin ninguna prueba, implicaba a Amare en las masacres de civiles amhara y lo acusaba de malversar fondos de la universidad en nombre de los rebeldes tigrayanos. Mencionaba el barrio donde vivía la familia.

Las publicaciones obtuvieron cientos de "me gusta" y, entre decenas de comentarios, los usuarios instaron a la gente a "organizarse y hacer una limpia", lo que Abrham y otros entendieron como amenazas veladas. El 14 de octubre, Abrham Amare hizo una denuncia a través del canal de denuncias públicas de Facebook. No recibió respuesta.

Sin que Abrham lo supiera, las publicaciones dirigidas a su padre también habían llamado la atención de uno de los socios de confianza de Facebook. El programa Trusted Partners (socios de confianza), está formado por colaboradores de la plataforma dedicados a advertir sobre contenido que incite al odio o a la violencia en la red social.

Para frenar la incitación al odio y la desinformación, Facebook tuvo en cuenta las denuncias de grupos de la sociedad civil y personas con conocimientos lingüísticos y locales. A estos "socios de confianza" designados se les pedía que señalaran post y cuentas a través de un canal de información especial y, en ocasiones, se reunían periódicamente con representantes de Meta para asesorarles sobre la moderación de contenidos.

En el caso de Amare, el socio de confianza declaró a Business Insider que señaló las publicaciones a través del canal especial y de nuevo en 2 reuniones de Zoom a mediados y finales de octubre. "Había gente enfadada pidiendo que se hiciera daño a este individuo. Intuía lo que iba a pasar", explica esta persona, que ha preferido permanecer en el anonimato por motivos de seguridad.

Como las amenazas contra el profesor eran vagas, Facebook solo accedió a supervisar la situación, según explica esta fuente. "Una de las cosas que dijo Facebook fue: 'No somos árbitros de la verdad'". Recuerdo que me pregunté si no sería mejor que Facebook retirara las publicaciones en lugar de que permanecieran en la plataforma pudiendo perjudicar a la gente", afirma el socio.

Business Insider no ha podido corroborar de forma independiente el relato de esta persona, que se publica aquí por primera vez. La agenda de Facebook para la segunda reunión de Zoom, obtenida por este medio confirma que se habló del asesinato de otro profesor tigrayano, pero no menciona específicamente a Amare. El portavoz de Meta no ha negado las afirmaciones del socio de confianza.

El relato es similar a lo que otros socios de confianza en Etiopía han contado a Business Insider: Facebook permitía de manera sistemática que este tipo de contenidos de odio permanecieran en su plataforma y tardaba en responder a las advertencias urgentes. Mientras tanto, Amare insistía en que podía permanecer en Bahir Dar.

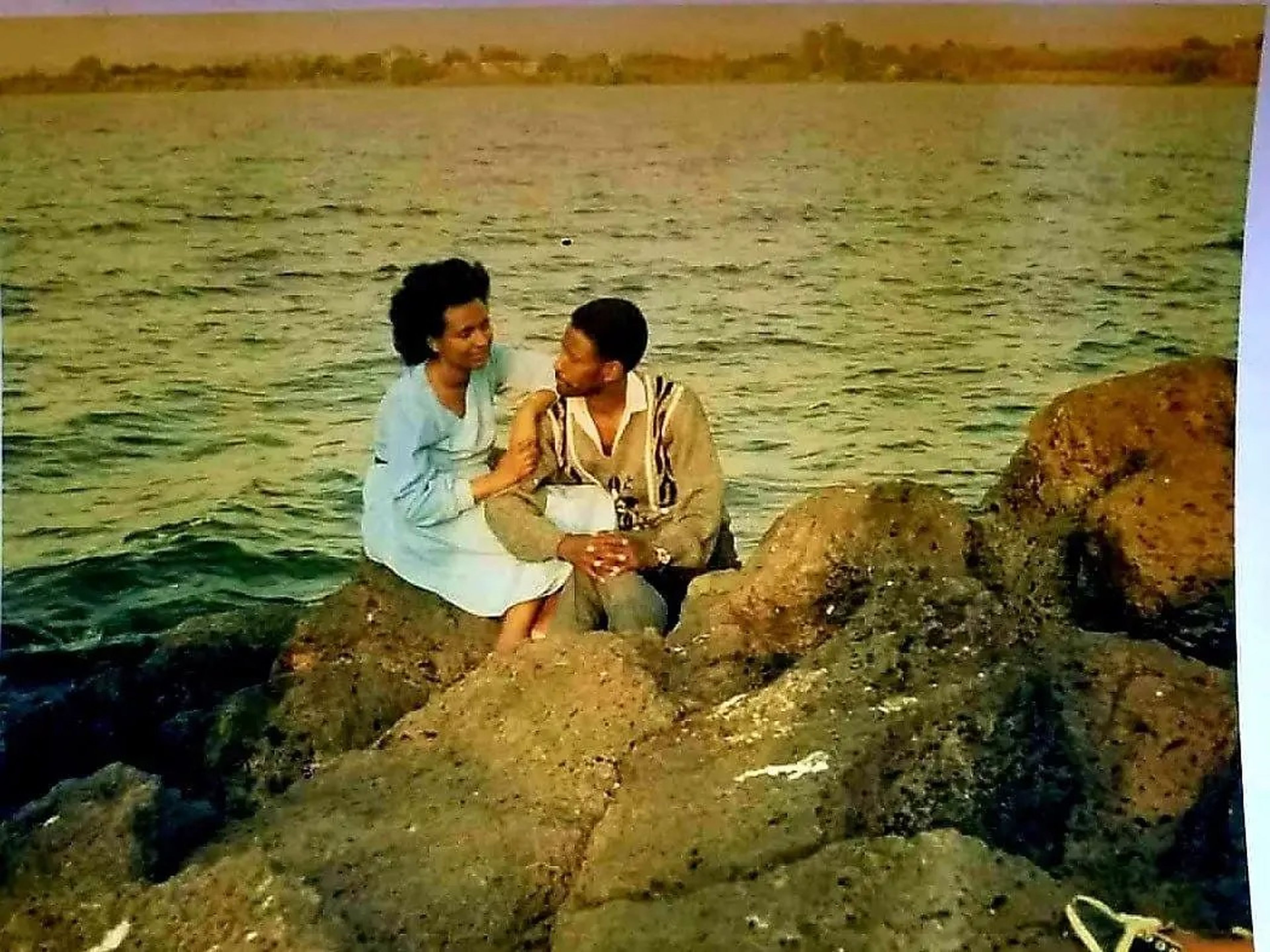

Cortesía de la familia Amare

"Tengo un posición social que construí antes de que tú nacieras. Soy una persona inocente. No tengo nada que ocultar", recuerda Abrham Amare que le dijo su padre. Estaba convencido de que la comunidad en la que había pasado 4 décadas como educador no se volvería contra él.

Aunque la policía de Bahir Dar le aseguró que las autoridades no buscaban su detención, la gente que conocía bien al profesor Amare empezó a sospechar. Un vecino al que conocía desde hacía muchos años se enfrentó a él por las acusaciones. El acoso se hizo incesante. 5 días antes de su asesinato, Amare dimitió de su puesto de profesor. El 3 de noviembre de 2021, el profesor Amare fue asesinado en la puerta de su casa.

Un grupo de hombres vestidos con uniformes de las Fuerzas Especiales de Amhara se le acercó, según consta en una demanda de 1.600 millones de dólares que Abrham Amare interpuso contra Meta a finales del año pasado. Uno de los hombres le disparó 2 veces, una en el hombro derecho y otra en la pierna.

Mientras el profesor sangraba en el suelo, el grupo de hombres lo rodeó y "coreó las mismas calumnias de la incitante publicación de Facebook", e impidió que nadie intentara llevarlo a un hospital cercano, según la demanda.

"Durante 7 horas, permaneció allí agonizando lentamente con un sufrimiento inimaginable", dice también la denuncia.

8 días después, Facebook respondió por fin a la denuncia de Abrham Amare. Meta declinó hablar del caso, alegando que no puede hacer declaraciones litigios pendientes. Pero según la demanda de Abrham Amare, Facebook le informó de que el post sobre su padre infringía sus normas comunitarias y había sido retirado.

De hecho, el post que había destruido el buen nombre de Meareg Amare y, según su hijo, había conducido a su asesinato, seguía publicado casi un año después, cuando Abrham Amare preparaba su demanda contra Meta.

Socios de confianza afirman que se ignoraron las advertencias

Business Insider ha hablado con 6 socios de confianza de Etiopía, algunos de los cuales ya no se dedican a ello, que afirman que Facebook ignoraba sistemáticamente sus peticiones de retirar contenidos que consideraban de odio o susceptibles de incitar a la violencia. En algunos casos, la empresa tardó 4 meses en responder.

Un grupo, la Red contra el Discurso de Odio, puso fin a su relación con Facebook el mes pasado y permitió a Business Insider revisar algunas de sus comunicaciones con la plataforma. En un momento dado, la organización se puso en contacto con la red social para decir que el 60% de las publicaciones y cuentas individuales que habían denunciado un mes antes seguían activas a pesar de haber sido marcadas.

Las publicaciones que parecían celebrar el uso de niños soldados seguían publicadas meses después de haber sido señaladas, y el agotador trabajo de revisar el contenido traumático había causado a los socios de confianza con los que hablamos Trastorno de Estrés Postraumático (TEPT) y depresión. Uno de los miembros de la red explica que se había deshecho de todos los cuchillos de su cocina después de ver tanto contenido violento. Un terapeuta al que acudió como parte de un programa de asistencia a los empleados dijo que su respuesta sugería que podría estar sufriendo trastorno de estrés postraumático.

Meta no proporciona recursos de salud mental a sus socios de confianza, como hace con sus equipos internos de moderación de contenidos, pero algunos grupos que aceptan financiación de Meta sí ofrecen servicios de apoyo psicológico.

"Nuestro objetivo es revisar el contenido que nos comunican los socios de confianza lo más rápidamente posible. La cantidad de tiempo que nos lleva revisar el contenido puede depender de una serie de factores, incluyendo la complejidad, el volumen y el formato en el que se comparte. También proporcionamos formación y recursos a nuestros socios, como plantillas de informes a medida y una plataforma de aprendizaje online, para ayudarles a compartir contenidos de la manera más eficaz posible", explicó Facebook en un comunicado a Business Insider.

Las quejas de los 6 socios de confianza se hacían eco de las alegaciones formuladas en la demanda de Abrham Amare, que acusaba a Meta de "flagrantes violaciones de derechos humanos y sufrimiento causados por sus decisiones empresariales", y exigía cambios en las prácticas de moderación de contenidos de Facebook. "En un país en el que ha habido una guerra civil sin precedentes y una violencia étnica generalizada, tardar varios meses en revisar y retirar el discurso de odio consecuente es permitir que cause violencia hasta que se solucione", declara a Business Insider un miembro de la Red contra el Discurso de Odio.

Ben Curtis/AP

No es la primera vez que Meta se enfrenta a acusaciones de este tipo. La matanza de musulmanes rohingya en Myanmar en 2017 puso de manifiesto cómo los fallos en la moderación de contenidos podían ser aprovechados para atizar el odio. Grupos de derechos humanos documentaron cómo se permitió que floreciera "una tormenta de odio" en Facebook en los meses previos a esas masacres. Al año siguiente, Mark Zuckerberg declaró que la empresa había contratado a revisores de contenido para vigilar la incitación al odio en birmano.

Meta también se ha enfrentado a acusaciones de que su algoritmo permite que se propague rápidamente la desinformación y ha ayudado a impulsar a líderes autoritarios al poder en India y Filipinas. La red mundial de socios de confianza de Meta incluye ahora a más de 400 ONG en puntos conflictivos en los que, de otro modo, no estaría presente. La empresa suele hacer referencia a su dependencia de expertos locales cuando se la acusa de avivar el fuego de otro conflicto étnico o de difundir desinformación. Pero el sistema de moderación de contenido es confuso.

Un portavoz de Meta explica que el programa de socios de confianza se lanzó en 2012, pero se negó a proporcionar detalles sobre cuántas personas colaboraban en ese momento o la naturaleza de sus responsabilidades. Desde al menos 2017, la compañía ha contado con verificadores para controlar la desinformación en su plataforma. Y en 2019, anunció una nueva iniciativa para colaborar con expertos en la materia como periodistas y asociaciones de derechos para luchar contra la desinformación en Facebook y otras plataformas de la empresa.

"Nuestro Programa de Socios de Confianza es líder en la industria y forma parte de los esfuerzos más amplios de seguridad de Meta y del compromiso con la sociedad civil", dijo el portavoz de Meta. En Etiopía y otros países, Meta concede subvenciones a organizaciones asociadas que operan independientemente del gigante de las redes sociales.

Los 6 socios de confianza etíopes entrevistados para esta historia pertenecen a esas asociaciones, incluido el grupo de medios Internews, una organización sin ánimo de lucro de medios globales que comenzó a trabajar con Meta en Etiopía en 2019, así como la Red contra el Discurso de Odio, que afirma haberse negado a aceptar fondos de Facebook. Los miembros de un tercer grupo pidieron que no se nombrara para no poner en peligro las subvenciones que Facebook concedió a algunos de sus proyectos.

Algunos de los socios de confianza han declinado ser nombrados porque se han enfrentado a amenazas de muerte y temen por su propia seguridad. En varios casos, no han querido dar a conocer sus nombres porque habían firmado acuerdos de confidencialidad con Facebook. Un portavoz de Meta aclara que esos contratos de confidencialidad están relacionados con otros trabajos con Facebook, y no con el programa Trusted Partners.

Mientras que la Red contra el Discurso de Odio ha cortado lazos con Facebook, otras organizaciones del programa de socios de confianza dicen que temen que hablar sobre las deficiencias del sistema porque eso podría poner en peligro la financiación que reciben de Meta. "Las organizaciones locales de la sociedad civil son muy débiles, aceptan el dinero porque lo necesitan para trabajar en proyectos. Pero no abren la boca cuando hay que criticar a Facebook. Se callan. Igual que estoy haciendo yo ahora al elegir el anonimato", explica a Business Insider un socio etíope de confianza.

El portavoz de Meta ha negado la afirmación de que "silencie" a los socios y afirma que agradece sus comentarios.

Una tirita como solución

Etiopía, segundo país africano por población, ocupa uno de los últimos puestos en los índices mundiales de libertad de expresión, con una libertad de prensa y una alfabetización limitadas. El Gobierno, dirigido por el primer ministro Abiy Ahmed, ha bloqueado en ocasiones el acceso a internet, especialmente en regiones en conflicto. Plataformas como Facebook son a menudo el único lugar donde los etíopes pueden informarse y compartir sus opiniones.

En Etiopía hay 7 millones de cuentas de Facebook, y el contenido que se comparte allí se difunde a menudo a través de Telegram y WhatsApp, también propiedad de Meta. Pero incluso sin acceso directo a una publicación o a una red social, la desinformación que se origina en Internet puede propagarse de boca en boca, según un socio de confianza. Los internautas etíopes expertos pueden eludir los sitios bloqueados con el uso de una VPN.

El portavoz de Meta ha explicado a Business Insider que el programa Trusted Partners forma parte de un equipo más amplio de Confianza y Seguridad de Meta y está gestionado conjuntamente por los equipos de Política de Contenidos y Operaciones Globales de la empresa. El equipo de Política de Contenidos se encarga de definir la estrategia, la formación y la divulgación del programa, mientras que el de Operaciones es responsable de actuar en función de los informes de los Socios de Confianza.

Según el portavoz, los socios también colaboran estrechamente con los equipos regionales de Políticas Públicas, que se encargan de gestionar las relaciones con los socios locales. El equipo de Política de Contenidos dirige la definición de la estrategia del programa, elabora materiales de formación y coordina las actividades de divulgación con las organizaciones de socios de confianza.

Según la demanda de Abrham Amare, los contenidos publicados en 3 lenguas en Etiopía (amárico, tigriña y oromo) se moderan principalmente desde Nairobi (Kenia). A los moderadores se les asignan "objetivos imposibles en cuanto al volumen de contenidos que deben revisar al día" y toman decisiones sobre las publicaciones en "cuestión de segundos", según la demanda. Desde mayo del año pasado, Meta se ha enfrentado a múltiples demandas relacionadas con sus moderadores de contenidos de África Oriental en Facebook e Instagram, que afirman haber sufrido traumas psicológicos como consecuencia de su trabajo.

Según Berhan Taye, exresponsable de políticas para África de Access Now, que ha puesto en contacto a organizaciones de la sociedad civil de Etiopía con Facebook, la cuestión más importante es por qué una empresa multimillonaria confía en una red de organizaciones sociales con escasos recursos para ayudar a moderar la incitación al odio en zonas en crisis, donde sus plataformas podrían estar contribuyendo a la propagación de la violencia.

"Es como poner una tirita cuando hace falta cirugía. Se trata de una organización multimillonaria que debería hacer este trabajo por sí misma", afirma Taye, que señala que los socios de confianza suelen proporcionar a Meta los conocimientos lingüísticos y locales por una fracción de lo que costaría contratar directamente a esos expertos.

Advertencias hechas en vano

La Red contra el Discurso de Odio, un grupo de derechos digitales totalmente voluntario, comenzó a trabajar con Facebook en enero de 2021.

Durante esa relación de 2 años, la compañía no respondió a los mensajes, dejó material que había sido marcado en la plataforma durante meses y se desorganizó planteando preocupaciones de seguridad para sus socios, según varios de los miembros de la red y una revisión de sus comunicaciones con Facebook. La red se sentó por primera vez con Meta en diciembre de 2020, en una reunión organizada por Taye, y acordó trabajar con la plataforma.

Por su propia seguridad, la red insistió en una regla básica. En esa reunión inicial, en la que participó el director de políticas de la empresa, los miembros solicitaron que se les permitiera mantener correspondencia con Meta a través de un correo electrónico de grupo y omitir la identidad del miembro individual. Según los miembros que asistieron, Meta accedió.

Varias semanas después, tras varios intercambios en los que se señalaban contenidos a Facebook, la red recibió una respuesta de ese mismo responsable que les pilló por sorpresa: al parecer, el responsable no recordaba quiénes eran, ni el acuerdo sobre cómo podían enviar información a Facebook de forma segura.

"Como puedes imaginar, tener acceso directo al personal de Facebook para informar de contenidos posiblemente infractores no es una opción para todos los usuarios. Necesitaré saber quiénes componen la Red y algo más de contexto sobre tu Red, para poder seguir revisando el contenido que compartes aquí", escribió el responsable en un correo electrónico.

En su respuesta, la red explicaba que la mayoría de sus miembros habían estado presentes y "habían sido identificados" en la reunión, y que el grupo había "explicado por qué queríamos permanecer en el anonimato." Y continuaba: "Hemos recibido amenazas concretas de ataque de usuarios etíopes de las redes sociales". Otro socio de confianza que trabajaba para otro grupo se hizo eco de la preocupación de que Meta parecía desorganizada, sobre todo teniendo en cuenta que las comunicaciones solían enviarse a un correo electrónico genérico para los socios de confianza en Facebook, en lugar de a un único responsable.

"Hay una falta de claridad en cuanto a los puntos focales sobre con quién hablar acerca de diferentes cosas y quién debe mantenerse al tanto", cuenta la persona a Business Insider. Un portavoz de Meta confirmó que hay varios equipos en la empresa que participan en el programa de socios de confianza.

Los despidos de Meta a finales del año pasado también afectaron a la relación de este grupo, ya que varios empleados con los que mantenían correspondencia de forma rutinaria fueron despedidos, según la fuente. Meta no ha querido comentar nada de estas quejas que los miembros de la red plantearon, pero afirma que su objetivo es responder rápido cuando se señalan publicaciones.

Pero la cuestión central que llevó a la Red contra el Discurso de Odio a poner fin a su relación con Meta fue la persistente sensación de que su trabajo era en vano. A finales del año pasado, mientras las fuerzas etíopes y tigrayanas se acercaban a una tregua, el otro gran conflicto del país, en la región de Oromia, se recrudecía.

En octubre, la red denunció más de 367 mensajes y cuentas individuales que promovían las actividades violentas del Ejército de Liberación Oromo. El grupo ha estado implicado en asesinatos de amharas, según asociaciones de derechos humanos. En noviembre de 2021, Meta publicó una política actualizada que prometía eliminar los contenidos que apoyaran o elogiaran estas actividades violentas. Al no recibir respuesta inmediata, la red envió sus solicitudes de retirada al responsable de política pública de su reunión inicial. A pesar de varios intentos de seguimiento y de las promesas de Meta de que las solicitudes se intensificarían, el grupo no recibió respuesta hasta el 12 de enero de 2023.

"La escalada de octubre se llevó a cabo en su totalidad", decía la respuesta de Facebook, sin dar detalles sobre qué se había retirado, si es que se había retirado algo. Según varios miembros de la red, y confirmado por Business Insider, la mayoría de las publicaciones seguían activas. A 5 de abril, alrededor del 70% de los enlaces que la Red contra el Discurso de Odio denunció seguían activos.

Al menos 7 de los mensajes señalados, que han sido revisados por Business Insider, contenían vídeos en los que aparecían niños de corta edad con fusiles AK-47 y pistolas. Muchos de estos vídeos aparecieron por primera vez en la plataforma en enero del año pasado y seguían colgados a finales de febrero. El correo electrónico de octubre también incluía cientos de cuentas que promovían la actividad violenta del Ejército de Liberación Oromo. En una serie de imágenes, acompañadas de una carita sonriente y emoticonos risueños, aparecían soldados posando con cautivos y fotos de hombres desnudos muertos en el suelo. El perfil seguía activo el 26 de enero, pero ya ha sido eliminado.

Según los miembros de la red, este tipo de mensajes puede ser una herramienta eficaz de reclutamiento. Otras cuentas de las que la red informó en octubre siguen activas. Entre ellas hay un usuario, cuya foto de portada muestra un AK-47 con una bandera de Ejército de Liberación Oromo, que publica habitualmente fotos y vídeos, incluidas escenas de combate y niños posando con armas.

Business Insider ha señalado a Meta otras 17 publicaciones de perfiles denunciados por la Red contra el Discurso de Odio. En respuesta, Meta retiró 2 mensajes y añadió una advertencia sobre el contenido de un tercero. Pero más de una docena de enlaces (incluyendo lo que parece ser una foto de una fosa común, un combatiente muerto y miembros de este ejército en combate activo) seguían publicadas al salir este artículo, más de 48 horas después de ser señaladas.

El portavoz de Meta afirma que la plataforma había retirado 2 publicaciones marcadas por la Red contra el Discurso de Odio, e incluido una advertencia sobre el contenido de una tercera. Meta no ha hecho comentarios sobre si los mensajes que seguían publicados habían infringido sus políticas.

Al final, los esfuerzos de la asociación resultaron inútiles y los miembros de la red decidieron buscar otras vías para luchar contra la incitación al odio. La Red contra el Discurso del Odio puso fin a su relación con Meta el 21 de marzo de 2023.

Depresión y TEPT

Para los socios de confianza de Etiopía que se habían comprometido a trabajar con Facebook en un momento de crisis aguda en su país, los largos tiempos de respuesta y las negativas que a menudo recibían eran desmoralizadores. Un socio cuenta que había perdido las ganas de jugar con sus hijos después del colegio o de quedar con los amigos para tomar una cerveza. Hace unos meses, un psiquiatra le dijo que mostraba signos de depresión.

"El impacto psicológico es enorme. No puedo relajarme porque no puedo ignorar la cantidad de vídeos horribles y discursos de odio que he visto. Después de un tiempo, me siento atrapado allí. Como si no pudiera hablar con gente normal", afirma la persona. Aun así, no veía la opción de tomarse un descanso. Tras el asesinato del profesor Amare, el socio de confianza que decía haber marcado las publicaciones se sintió acosado por la culpa y se preguntó si tenía algún sentido trabajar con Facebook.

Cortesía de la familia Amare.

"Cuando vi que estaba muerto, me enfadé mucho. La retrospectiva siempre es lo peor. Pero independientemente de mis deficiencias, creo que la plataforma tenía más responsabilidad", afirma esta persona.

Múltiples socios de confianza en Etiopía afirman que la incitación al odio sigue proliferando en la plataforma.

Inversión en crecimiento pero no en protección

A menudo, en episodios organizados de asesinatos en masa, los llamamientos a la violencia vienen en un lenguaje codificado que sería difícil de detectar para un algoritmo de moderación sin un intérprete humano. En el genocidio de Ruanda de 1994, por ejemplo, tales eufemismos incluían "cortar la hierba alta".

En Etiopía, frases como "organízate y limpia" o "pasa a la acción" aparecían en los posts y se entendían como llamamientos a la violencia, según la demanda de Abrham Amare y los socios de confianza que han hablado con Business Insider. Estos señalan que Meta discrepaba con frecuencia de sus apreciaciones sobre lo que constituía una violación grave y perseguible de las políticas de la compañía.

Meta emplea una amplia gama de mecanismos para mitigar la incitación al odio y el contenido gráfico en la plataforma, desde el bloqueo para limitar su alcance hasta la eliminación total del contenido. La plataforma rara vez informa a sus socios de confianza del tipo de medidas que ha tomado en relación con las publicaciones que denuncian.

A raíz de la filtración masiva de archivos de Facebook, Frances Haugen, la denunciante que testificó ante el Congreso en octubre de 2021, citó Etiopía como un lugar donde las prioridades del algoritmo alimentan la desinformación. "Está separando familias. Y en lugares como Etiopía está literalmente avivando la violencia étnica", afirma.

Meta ha negado la afirmación de que su algoritmo alimente la difusión de contenidos de odio. "Nuestros anunciantes no quieren verlo, y nosotros tampoco. No hay ningún incentivo para que hagamos otra cosa que eliminarlo", escribió la empresa en su blog.

Jabin Botsford-Pool/Getty Images

Pero moderar la incitación al odio y la desinformación es también uno de los problemas más caros de Meta, como revelan los archivos de Facebook, y África Oriental no es un mercado especialmente rentable. Sólo el 10% de los ingresos de Facebook proceden del Resto del Mundo, el término contable utilizado para los países fuera de Norteamérica y Europa Occidental, que incluye Etiopía y docenas de otros países del Sur global. En términos tecnológicos, Etiopía es un país con una media baja de ingresos por usuario.

"En el fondo, no les estamos haciendo ganar mucho dinero. Pero saben que somos los próximos 1.000 millones de usuarios", afirma Taye, de Access Now. Si bien Facebook está invirtiendo y trayendo más usuarios en el sur global, Taye afirma que no está invirtiendo lo suficiente en las herramientas necesarias para proteger a esas personas.

"La UE puede convocar a Mark Zuckerberg a Bruselas. El Reino Unido puede convocarlo al Parlamento. Estados Unidos puede hacerlo en el Congreso. Pero nosotros no tenemos poder", afirma.

El portavoz de Meta niega que no se tome en serio la incitación al odio contra Etiopía.

Rafiq Copeland, asesor principal de Internews, uno de los socios de confianza de Meta más antiguos a nivel mundial, ha contado a Business Insider que las principales quejas de los socios de confianza en Etiopía han surgido en otros países del Resto del Mundo. "Son experiencias y frustraciones comunes", afirma Copeland.

Pero sigue siendo esencial contar con un sistema para detectar la incitación al odio, y Copeland afirma que Meta debería rediseñar el sistema de Socios de Confianza con las sugerencias de sus colaboradores en todo el mundo.

"Por los beneficios que aporta en materia de seguridad, el programa de Socios de Confianza es lo mejor que Meta va a conseguir nunca", señala. "Proporciona un canal para que la sociedad civil plantee cuestiones y comparta información que tiene potencial para salvar vidas.

"Pero también hemos tenido muchas frustraciones con el programa", sentencia.

Cortesía de la familia Amare.

La historia de un padre

El profesor Amare fue enterrado sin ataúd en una tumba sin nombre por 2 funcionarios. No había ningún familia presente. Hizo falta la ayuda de una ONG local para que su familia identificara dónde había sido enterrado.

"No se nos permitió llorar en voz alta. Todo el ambiente estaba en contra de los tigrayanos", cuenta Abrham.

A día de hoy, se desconoce la identidad del asesino.

Para Abrham, una de las cosas más duras ha sido enfrentarse a la destrucción del buen nombre de su padre. Mientras la familia se refugiaba en Adís Abeba, la capital, hasta que pudieron salir del país, Abrham empezó a preparar un memorial en internet, la esquela que creía que se le había negado a su padre.

El joven sabía algunas cosas: cristiano devoto y hombre de ciencia, su padre había sufragado durante años las tasas escolares y comprado material para los niños desfavorecidos de Bahir Dar. Le gustaba la música tradicional tigrayana, y en los largos viajes en coche cantaba al ritmo de Yemane Ghebremichael y Tsehaytu Beraki, músicos eritreos que le encantaban.

El profesor Amare había escrito 47 artículos académicos, 9 de ellos publicados a título póstumo por compañeros y coautores solidarios. En los próximos años tenía previsto viajar a conferencias científicas en Europa, Asia y Estados Unidos para hablar de esos trabajos. Irónicamente, Facebook había sido una fuente de noticias felices para la familia: a principios de 2021, cuando el profesor recibió un ascenso importante, fue demasiado humilde para dar la noticia él mismo, y se enteraron por la cuenta oficial de Facebook de la universidad.

Abrham se puso en contacto con amigos y compañeros de su padre para saber más sobre la vida del profesor. "Era un buen hombre", dice Abrahm a Business Insider. "Pero a veces ser amable, ser civilizado, cuesta mucho", añade.

Incluso en Adís Abeba, parece que todo el mundo conocía las publicaciones de Facebook, y mucha gente lo veía ahora como un traidor. "Recibí mucho rechazo", señala Abrham, sobre algunas de las personas a las que llamó para hablar de su padre. En agosto, Abrham abandonó Etiopía y publicó en internet el memorial de su padre. No lo publicará en Facebook.

El interés de los medios de comunicación por la demanda le ha dado más oportunidades de hablar del hombre que fue su padre, aunque algunos detalles sigan siendo profundamente dolorosos. "Me da la oportunidad de recordar los buenos tiempos", comentaba en una entrevista.

La primera vista de su caso contra Meta está prevista para el 19 de abril en Nairobi (Kenia). "Esto tiene que parar en algún momento. No quiero que otras familias sufran lo mismo que nosotros. Quiero evitar que este tipo de cosas vuelvan a ocurrir", afirma Abrham.

Para él, el caso, y la atención mediática que ha suscitado, es otro ejercicio de reivindicación del legado de su padre para que se le recuerde como lo hacen quienes le querían.

Otros artículos interesantes:

Conoce cómo trabajamos en Business Insider.