Barcelona acoge un encuentro global de expertos a la búsqueda de estándares para auditar algoritmos: "El desafío es pasar de los principios a la práctica"

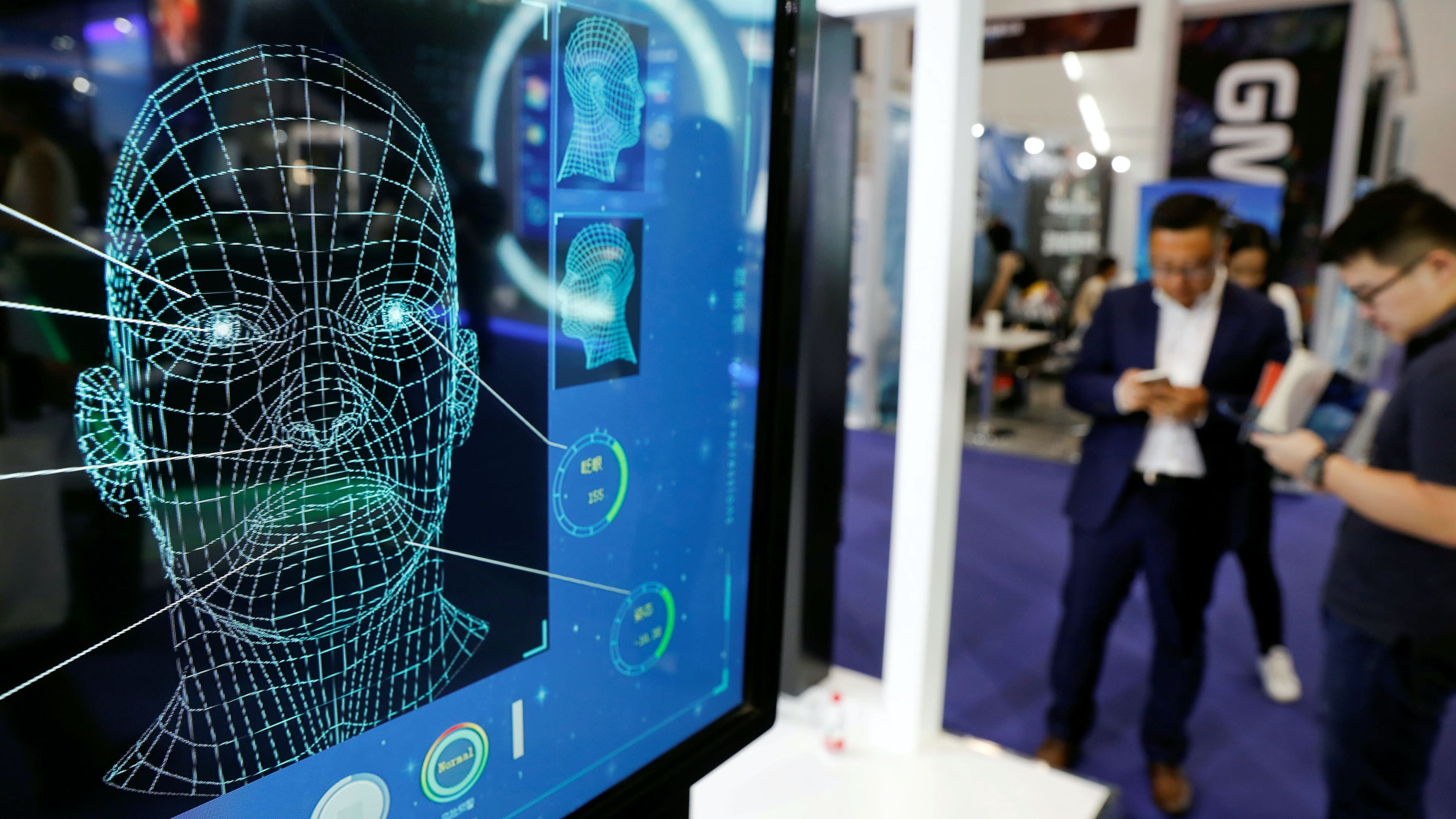

REUTERS/Damir Sagolj

- Una conferencia global organizada por Eticas reúne en Barcelona a expertos en auditorías algorítmicas y transparencia y ética en inteligencia artificial.

- Además de un evento público, los expertos han mantenido reuniones a puerta cerrada y mantendrán un encuentro en Bruselas con legisladores.

Barcelona ha sido el escenario de una de las primeras conferencias internacionales a la búsqueda de estándares para auditar algoritmos. La Ciudad Condal ha recibido este martes a un plantel de expertos en gobernanza en inteligencia artificial para examinar de qué manera estas auditorías se podrían estandarizar en todo el planeta.

El foro lo ha organizado Eticas, la empresa especializada en ética tecnológica fundada por Gemma Galdon. En realidad, no se ha limitado a ser un evento público: los especialistas han mantenido encuentros durante toda la jornada y continuarán este miércoles con una viaje a Bruselas donde se reunirán con parlamentarios y legisladores.

La noticia llega justo cuando el futuro y esperado Reglamento de la Inteligencia Artificial cuyo propuesta presentó la Comisión Europea en abril del año pasado podría recibir luz verde por parte del Consejo de la Unión Europea, que ya ultima los detalles de su versión definitiva —a expensas de conocer también los cambios propuestos por el Parlamento Europeo—.

El Comité de Representantes Permanentes de la Unión Europea (Coreper) mantendrá el próximo 18 de noviembre una reunión en la que se podría adoptar, de esta manera, el texto definitivo con el que el Consejo de la Unión Europea comenzará las negociaciones para que se apruebe de forma definitiva esta nueva norma que puede ser clave para el mercado en Europa y en el mundo.

A esta conferencia internacional sobre auditorías algorítmicas acudieron expertos de todos los rincones del planeta. En la apertura de la sesión con público, la propia Galdon detalló que el propósito de ese evento era "compartir" lo que hasta ese momento habían aprendido, "para ir después a los legisladores" y decir "esto es lo que pensamos que hará más segura a la inteligencia artificial".

"Pasar de los principios a los hechos"

"El interés por la ética en la IA ya está aquí, ahora el desafío es cómo pasar de los principios a lo práctico, cómo traducir esos principios en mecanismos concretos", adujo Galdon, que enfatizó en cómo la auditoría algorítmica puede ayudar a que "la tecnología que toma decisiones sobre nuestras vidas" tome esas decisiones de una manera "más justa, aceptable y transparente".

"Cuando los políticos decidieron que los coches debían ser seguros, se introdujeron los cinturones de seguridad. Los políticos ya han consensuado que los algoritmos deben ser seguros: ahora hay que pensar en cómo serán esos cinturones de seguridad", apuntó Galdon, que sugirió que esas auditorías algorítmicas podrían ser esos nuevos "cinturones de seguridad" para estas tecnologías.

Una de las ausencias más sonoras del plantel de expertos que acudió este martes a Barcelona fue el de la doctora Rumman Chowdhury, una de las responsables del departamento de Ética de Twitter que acaba de ser prácticamente desmantelado por su nuevo propietario, Elon Musk. Galdon excusó a su compañera Crowdhury, aunque sí avanzó que podría estar en la reunión en Bruselas de hoy.

Todos los ponentes que acudieron al encuentro contaban con experiencia en el sector de la IA. Jacob Metcalf, por ejemplo, tiene su propia firma de auditoría, Ethical Resolve, y es investigador para Data&Society, una entidad no gubernalmental. Metcalf destacó en su intervención cómo los primeros pasos en EEUU en regulación algorítmica tienen que ver con el mercado laboral.

Gemma Galdon recordó que la algoritmia en el mercado laboral es "uno de los temas" pero "no el tema" que se aborda fundamentalmente en Europa con los paquetes legislativos en camino. Si bien en España la ministra de Trabajo, Yolanda Díaz, ha dado pasos para regular estos modelos automáticos en relaciones laborales, los desafíos éticos de la IA van mucho más allá.

Metcalf, por su parte, destacó que en EEUU esa preocupación por los algoritmos laborales respondía a que la trayectoria educativa y profesional en EEUU son dos de los vectores que más determinan la discriminación que pueden sufrir las personas.

"Junto a la discriminación por raza, género o clase, el acceso a la prosperidad económica siempre se ha limitado gracias a estos vectores demográficos. Los algoritmos prácticamente replican de forma inherente el estado actual del mundo, con lo que se convierten en herramientas conservadoras cuando no reaccionarias que hacen un esfuerzo consciente para bloquear cualquier esperanza".

Divij Joshi, otro de los panelistas, es investigador de la University College London, está estudiando por ejemplo qué mecanismos pueden adoptar las administraciones públicas para garantizar la rendición de cuentas de modelos algorítmicos desplegados en ellas. Sus análisis de hecho están siendo tutorizados por otro investigador que también estuvo presente, Michael Veale.

"Creo que hay un esfuerzo bienintencionado" en el sector público, avanzó, pero también hay "muchos tipos de problemas" que impiden que esos algoritmos públicos acaben sometiéndose a controles más estrictos: aquellos relacionados con la estructura de lo público e incluso con los limitados puntos de partida en los que en ocasiones se puede analizar un modelo de IA.

"¿Puedes examinar el sesgo con la base de datos o te interesa más detectar el impacto social de todo el sistema?". Las preguntas siempre oscilantes, explicó Joshi, han provocado que en múltiples ocasiones sector público haya tenido problemas para encontrar una "herramienta de seguridad" adecuada con la que abordar la auditoría de muchas inteligencias artificiales públicas.

En términos como ese pivotó la conversación, con la intervención de otros especialistas como Shea Brown, CEO de otra firma de auditoría algorítmica llamada BABL AI; Jennifer Cobbe o Jat Singh, de la Universidad de Cambridge; Lofred Madzou, responsable de TruEra, una plataforma capaz de auditar modelos y "empoderar auditores" o Jenny Brenan, del Instituto Ada Lovelace.

Ramak Molavi, investigadora sénio en Transparencia de la IA en la fundación Mozilla, enfatizó por ejemplo en "lo mucho que se ha aprendido de los daños que puede ocasionar de la IA", pero incidió en que ahora es el turno "de pasar de las críticas a las soluciones". "Todavía hay una gran brecha entre el mundo académico y la realidad", lamentó.

"La transparencia algorítmica, por ejemplo, no puede ser un objetivo: debe ser una precondición para la agencia humana, para la privacidad de las personas y para el bienestar medioambiental y social". De los encuentros entre los expertos en Barcelona y ahora en Bruselas seguirán aprendiendo, mientras el Reglamento de la IA en Bruselas sigue superando trámites legislativos.

Otros artículos interesantes:

Descubre más sobre Alberto R. Aguiar, autor/a de este artículo.

Conoce cómo trabajamos en Business Insider.