Una inteligencia artificial de Google no usará términos como "mujer" y "hombre" al reconocer imágenes para evitar caer en errores

- Una herramienta de inteligencia artificial de Google que reconoce objetos en las fotos ya no incluirá etiquetas de género como "mujer" u "hombre".

- La API Cloud Vision de Google la utilizan desarrolladores para analizar lo que hay en una foto, porque identifica casi cualquier cosa, desde logotipos de marcas hasta caras o puntos de referencia.

- Google ha enviado este jueves un correo electrónico a sus clientes de la API en el que afirma que no usará etiquetas relacionadas con el género porque no se puede deducir el género de una persona solo por su apariencia.

- Un experto en estos sesgos de la IA ha explicado a Business Insider por qué el cambio es muy positivo.

- Descubre más historias en Business Insider España.

Una herramienta de inteligencia artificial de Google que reconoce objetos en las fotos ya no incluirá etiquetas de género como "mujer" u "hombre".

La API Cloud Vision de Google la utilizan desarrolladores para analizar lo que aparece en las fotos, porque identifica casi cualquier cosa, desde logotipos de marcas hasta caras o puntos de referencia.

La herramienta también puede detectar contenido explícito, y tiene una gran cantidad de usos, desde de particulares que utilizan esta búsqueda visual hasta investigadores que identifican especies animales.

En un correo electrónico dirigido a desarrolladores que la empresa ha enviado este jueves, al que ha tenido acceso Business Insider, Google ha explicado que ya no usará "etiquetas de género" dentro de sus etiquetas de imágenes.

En su lugar, este tipo de imágenes irán con etiquetas "sin género" como por ejemplo "persona".

Google ha apuntado el cambio viene de que no se puede deducir el género de una persona solo por su aspecto. También ha hecho referencia sus propias normas éticas sobre la IA, asegurando que establecer el género de quienes aparecen en las fotos puede llevar a caer en prejuicios injustos.

Así dice el correo electrónico: "Dado que el género de una persona no puede deducirse por su apariencia, hemos decidido eliminar estas etiquetas para alinearnos con los Principios de Inteligencia Artificial de Google, en concreto, con el Principio #2: Evitar crear o reforzar sesgos injustos".

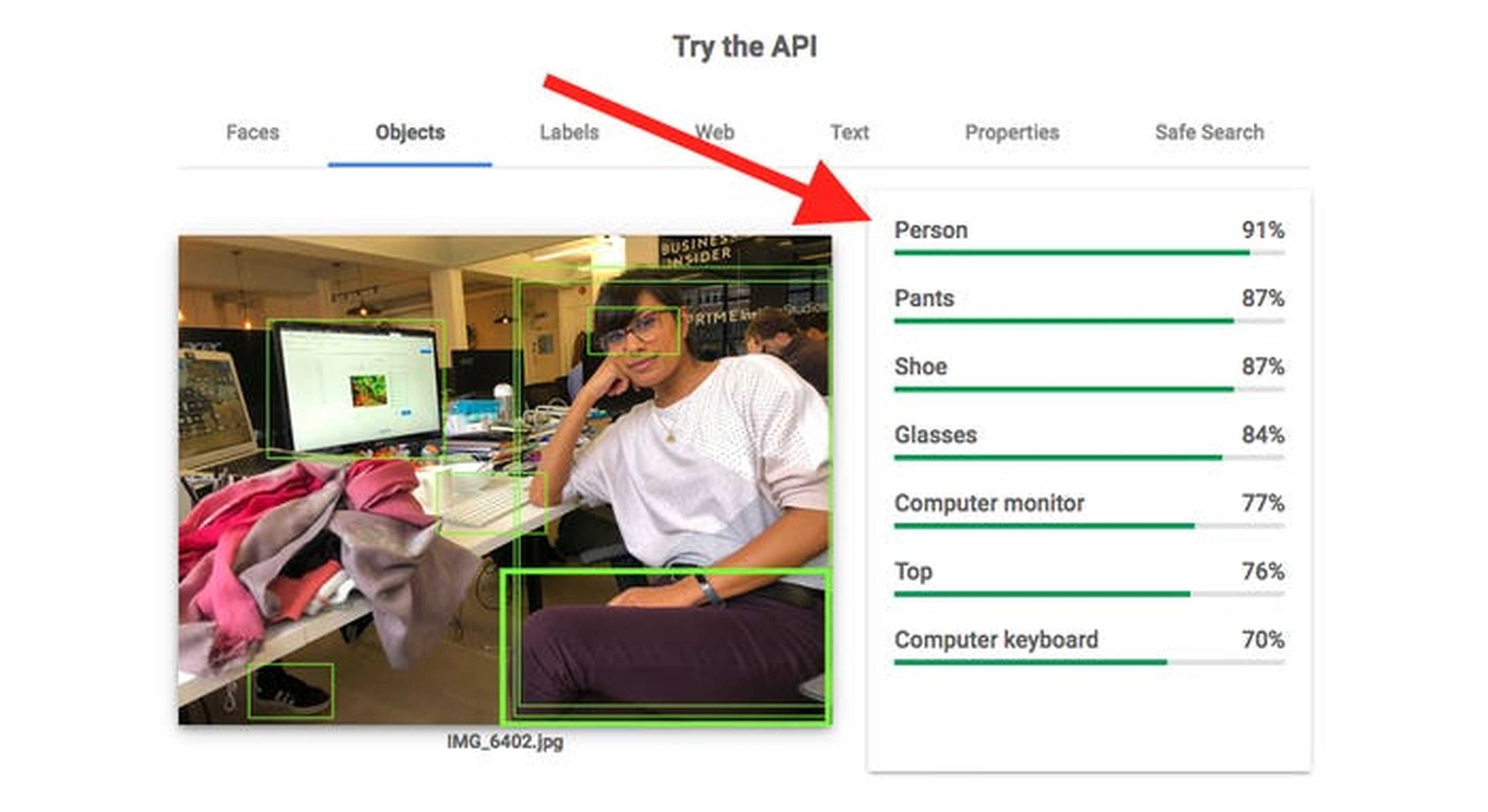

Business Insider ha probado la API, y esto es lo que aparece:

El sesgo en la inteligencia artificial es un tema muy discutido, y hay investigadores que se han mostrado preocupados por que la inteligencia artificial lleve a exacerbar o crear suposiciones injustas.

Un ejemplo son los algoritmos de reconocimiento facial que identifican erróneamente a las personas de color con más frecuencia que a los blancos.

Frederike Kaltheuner, un becario de que trabaja en el área de política tecnológica de Mozilla y que tiene experiencia en prejuicios de la inteligencia artificial, ha señalado a Business Insider que la actualización es "muy positiva".

"Cada vez que clasificas automáticamente a gente, ya sea su género o su orientación sexual, tienes que decidir qué categorías usas, y esto viene con muchas suposiciones.

"Clasificar a la gente como hombre o mujer asume que el género es binario. Cualquiera que no encaje será automáticamente mal clasificado y le habrás asignado un género equivocado. Así que se trata de algo más que un prejuicio: el género de una persona no puede ser deducido por su apariencia. Cualquier sistema de inteligencia artificial que trate de hacer eso inevitablemente dará un mal resultado a la gente."

Google señala en sus propios principios de IA que los algoritmos y los conjuntos de datos pueden reforzar el sesgo: "Buscaremos evitar efectos injustos en las personas, particularmente aquellos relacionados con características sensibles como la raza, la etnia, el género, la nacionalidad, los ingresos, la orientación sexual, la capacidad y las creencias políticas o religiosas".

Google también ha invitado a los desarrolladores afectados a comentar el cambio en sus foros. Solo un desarrollador lo había hecho cuando se escribía este artículo, y se quejaba de que el cambio se debía a la "corrección política".

"No creo que la corrección política tenga cabida en las API", apuntaba. "Si puedo identificar en el 99% de los casos si alguien es un hombre o una mujer, entonces también puede hacerlo el algoritmo. ¿No quieres hacerlo? Las empresas irán a otros servicios".

Business Insider ha contactado con Google para pedirle comentarios.

Otros artículos interesantes:

Conoce cómo trabajamos en Business Insider.