Logran hackear un modelo de reconocimiento facial similar al que se usa en los aeropuertos para identificar a personas que tienen prohibido volar: así lo han conseguido

- El reconocimiento facial es 'hackeable': investigadores de McAfee logran engañar a una IA para que identifique erróneamente a una persona en un sistema de reconocimiento facial.

- Aunque la investigación se ha realizado en un entorno hackeado, se trata de un modelo de reconocimiento facial similar al que se emplea en aeropuertos para vetar el embarque a personas que tienen prohibido volar.

- McAfee destaca que a medida que progresa la ciencia de datos, también progresan vectores de ataque, y han presentado esta investigación en la Black Hat para abrir un debate en torno a ello.

- 2020 está siendo un año polémico para las tecnologías de reconocimiento facial: este verano, Mercadona ha anunciado la instalación de este desarrollo en 40 de sus tiendas.

- Descubre más historias en Business Insider España.

Un modelo de reconocimiento facial se puede hackear. Esta es la conclusión de una investigación elaborada por técnicos de McAfee que acaba de presentarse en el Black Hat 2020, uno de los mayores eventos de ciberseguridad de todo el mundo, que este año se celebra de forma digital por el coronavirus.

Business Insider España ha tenido acceso a la investigación, y en ella se detalla cómo el equipo de Investigación Avanzada de Amenazas de esta firma fue capaz de engañar a un sistema de reconocimiento facial similar al que se emplean en los aeropuertos.

Los sistemas de reconocimiento facial más habituales son los que utilizan la inteligencia artificial (IA) o el aprendizaje automático para detectar patrones en las caras de los usuarios. Estos patrones se comparan después con fotos almacenadas en una base de datos. De este modo, la tecnología es capaz de alertar de la identidad de alguien de un mero 'vistazo'.

En su investigación, los hackers de McAfee han demostrado cómo engañaron a uno de estos sistemas. Una persona se puso frente a la cámara en cuestión. La cámara comparó el rostro del sujeto con una foto de otra persona completamente distinta.

El reconocimiento facial falló: concluyó que la persona que tenía delante de la cámara era la misma que aparecía en la foto de su base de datos. Y no era así.

Una aproximación básica a la tecnología de reconocimiento facial

Para entender este hackeo hay que remontarse a cómo funciona en sí la tecnología de reconocimiento facial.

A priori podría decirse que una cámara registra patrones en los rostros de los individuos y los compara con fotos almacenadas en una base de datos: tamaño de los ojos, distancia entre las cejas, ángulo de la nariz... Cualquier detalle es esencial para el sistema.

Pero yendo más allá, y para que el lector se ubique: basta imaginarse dos sistemas de inteligencia artificial enfrentados, jugando entre sí. Serían dos redes neuronales artificiales y ambas competirían en un juego de suma cero: lo que una gana, la otra lo pierde.

Este sistema se utiliza no solo en el reconocimiento facial, sino también en los sistemas que generan imágenes artificiales de forma automática.

Hay una página web desarrollada por investigadores de Nvidia, la conocida multinacional de las tarjetas gráficas. Se llama This Person Does Not Exist ("esta persona no existe"). El usuario que acceda a ella se encontrará con una imagen fotorrealista de una persona.

Esa persona —como a estas alturas te podrás imaginar— no existe. Se trata de una foto generada automáticamente de un rostro humano que en realidad no existe.

Sin entrar en muchos detalles, el funcionamiento de esta tecnología es similar al de los superordenadores que son capaces de componer canciones o incluso escribir poemas de forma automática, sin mediación humana.

De forma paralela, Nvidia tiene proyectos similares que generan imágenes de forma automática de gatos, caballos o incluso obras de arte. Eso sí: estos proyectos son más recientes. Sus imágenes tienen menos resolución —son más pequeñas— y los resultados no son tan espectaculares como en el sistema que genera caras humanas.

¿Por qué? Porque sus sistemas no están tan entrenados. En todas estas webs hay un sistema llamado StyleGAN2. GAN son las siglas en inglés de "redes adversarias generacionales". Son, como se explicaba hace unas líneas, redes neuronales que cooperan y compiten para generar estas imágenes.

En el sistema StyleGAN2, una red neuronal es la que genera rostros —o gatos, caballos u obras de arte— y la otra red neuronal —la adversaria— es la que se encarga de discernir si se trata de un rostro realista, creíble, o de uno falso.

Conforme una red propone caras y la otra las acepta o no —se las "cree" o no—, el sistema va mejorando. Por sí solo. Esta es la razón por la que el proyecto de caras falsas está más avanzado y sus imágenes tienen más resolución: las redes neuronales llevan más tiempo 'jugando' a inventarse caras.

Estas GAN también están presentes en los sistemas de reconocimiento facial.

Los sistemas de reconocimiento facial más habituales utilizan estas GAN

Además de StyleGAN2, hay muchas soluciones con redes neuronales artificiales enfrentadas del estilo. Por ejemplo, en la investigación, los hackers de McAfee destacan CycleGAN, un sistema que enfrenta a 4 redes neuronales (2 vs. 2) o FaceNet, una arquitectura de reconocimiento facial que desarrolló Google en 2015.

FaceNet, por ejemplo, es capaz de discernir si una cara es auténtica —o al menos realista— gracias a enfrentar características muy concretas de dos imágenes con caras. No solo compara un puñado de píxeles.

Además, se trata de una solución muy popular porque la arquitectura ya incluye un modelo previamente entrenado con "cientos de millones de imágenes de rostros". "Este entrenamiento se desarrolló con un set de datos estándar bien conocido en la industria y en la academia".

El 'hackeo' al reconocimiento facial que han conseguido ejecutar en McAfee se hizo, eso sí, en un entorno controlado: una combinación de CycleGAN con el FaceNet.

Así ha sido el hackeo al reconocimiento facial que ha conseguido McAfee

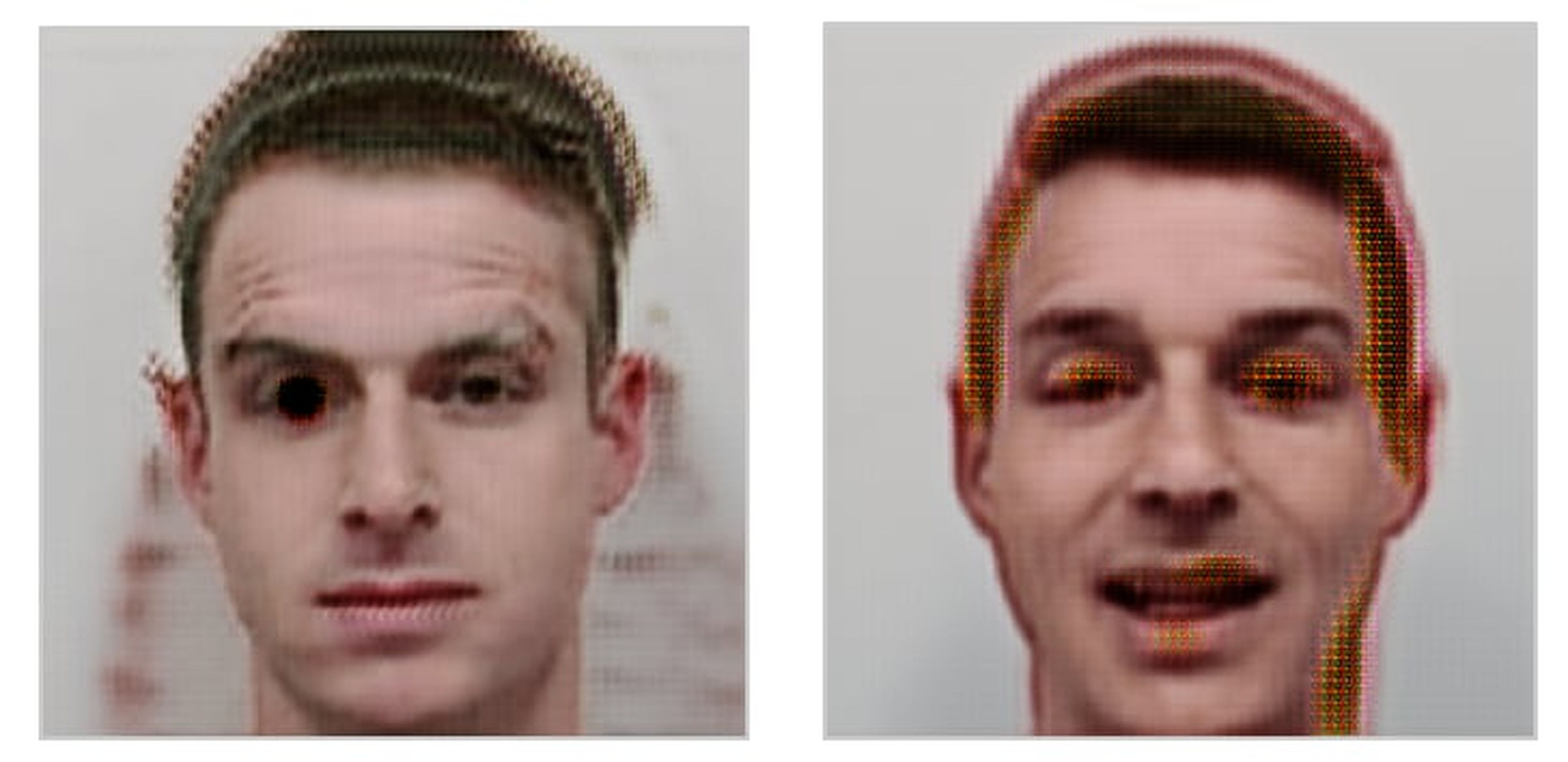

Un sujeto A y un sujeto B. Sus nombres: Jesse y Steve. El propósito: confundir al sistema de reconocimiento facial elegido para que confunda el rostro de uno con el otro. "En otras palabras: Jesse necesitaba parecerse a sí mismo en su foto del pasaporte, y ser clasificado como Steve, y viceversa".

Para ello, con todos los mimbres contados, lo que hicieron Jesse y Steve —miembros del equipo de investigadores de McAfee— es proveerles a las redes neuronales artificiales un set con 15.000 imágenes suyas. La intención no era otra que ir confundiendo poco a poco al sistema de aprendizaje automático.

Por supuesto, este tipo de 'hackeo' no sería funcional —hoy por hoy— en un entorno real. Se deberían reunir demasiados condicionantes para que unos atacantes pudiesen explotar en muy poco tiempo a una arquitectura de reconocimiento facial. Sin embargo, este estudio demuestra que es posible.

Lo que hicieron los investigadores es que la red neuronal que genera las imágenes con los rostros —que captura de una cámara— fuese enviándoselas a la red neuronal 'adversaria' —la discriminadora—. A la vista de que en los primeros 'cruces' la red adversaria rechazaba las caras —entendía que Jesse, por ejemplo, no era la persona que decía ser—, la red neuronal que genera las imágenes fue mejorando paulatinamente sus resultados.

En este contexto, 'mejorar sus resultados' quiere decir que una de las redes fue introduciendo sutilezas en la imagen que detectaba la cámara a fin de que la red que discrimina acabase aceptándolo.

Por eso, en los primeros cruces se registraron deformidades que la GAN fue puliendo.

En estos sistemas de reconocimiento facial, la red neuronal artificial que crea la imagen artificial lo hace basándose en la imagen que recibe por cámara. Es lo que los investigadores denominaron "imagen adversaria".

Poco a poco esta imagen "adversaria" se fue puliendo. De este modo, los hackers consiguieron, tras entrenar mucho a la IA, conseguir que esta naturalizase el siguiente proceso:

Cuando una persona se sitúa frente a una cámara de reconocimiento facial, la IA genera una imagen de la cara. La idea es que la imagen sea aceptada por la red discriminadora, y que se registre como la pareja de los patrones de la cara a identificar que el sistema ya tiene almacenados.

Cómo se comprobaron los resultados

Para comprobar el éxito del 'hackeo', los investigadores de McAfee hicieron tres pruebas.

El test positivo era demostrar que el sistema de reconocimiento facial seguía funcionando correctamente. Para ello, un tercer protagonista llamado Sam se situó frente a la cámara. El sistema comparó a Sam con la cara real de Steve. El sistema determinó que Sam no era Steve. Después comparó la cara de Sam con una foto de la cara real de sí mismo: el sistema comprobó que Sam era quien decía ser gracias a su foto.

El sistema de reconocimiento facial seguía funcionando.

El siguiente test fue el test negativo. Sam se pone frente a la cámara y el sistema compara su cara con una foto de Jesse. El sistema determina que Sam no es Jesse. Después, Steve se puso también frente a la cámara. El modelo también determinó que Steve tampoco es Jesse, por lo que el sistema seguía funcionando con normalidad.

El test de adversarios era el último. La prueba de fuego. Sam no ha participado en el entrenamiento de las redes neuronales. Por lo tanto, al situarse frente a la cámara, el sistema descarta que sea o Jesse o Steve.

Sin embargo, cuando Steve se sitúa frente a la cámara, los investigadores fuerzan a la IA a comparar la cara de Steve con la imagen adversaria, generada y con la que el algoritmo se ha entrenado.

Eureka. Para el sistema de reconocimiento facial, Steve es Jesse. Es incapaz de distinguir ambas caras.

La investigación revela los riesgos del reconocimiento facial

Aun cuando el equipo de McAfee ha hecho esta investigación en entornos controlados, los expertos abundan en que su propósito era abrir un debate sobre el uso de esta tecnología.

La tecnología de reconocimiento facial ha sido objeto de polémica en los últimos meses. El debate ha vuelto a la luz pública después de que en las protestas del Black Lives Matter se denunciara el sesgo racial que parece tener los algoritmos de la IA que intervienen en este tipo de desarrollos.

Esta polémica ha obligado a compañías como Microsoft, IBM o Amazon hayan anunciado que paralizan la venta de sus soluciones de reconocimiento facial. Más de 1.600 trabajadores de Google pidieron al CEO de la compañía, Sundar Pichai, hacer exactamente lo mismo.

La preocupación no es la misma en España. Este verano, la cadena de supermercados de Mercadona ha anunciado la instalación de cámaras de reconocimiento facial en 40 tiendas. El objetivo es evitar que accedan a sus establecimientos personas con una causa pendiente con la justicia que tengan órdenes de alejamiento de la tienda o de sus empleados.

Mercadona no ha aclarado si cuenta con una base de datos con las imágenes de los actores que tienen dicha causa pendiente con la justicia. La Agencia Española de Protección de Datos inició una investigación contra la firma española.

Del mismo modo, la propia Guardia Civil sondea la posibilidad de probar tecnologías de reconocimiento facial en un festival de música que tendrá lugar el próximo mes de octubre.

Esta investigación ha sido presentada este mismo miércoles por la tarde. Desde McAfee destacan que "al desarrollar más el reconocimiento facial, la industria también está desarrollando un posible vector de ataque". "Identificar y mitigar los problemas de seguridad de manera proactiva es imprescindible".

La compañía asevera que el estudio "tiene la intención de promover el debate sobre la seguridad inherente a las aplicaciones de machine learning". Va más allá del reconocimiento facial: "La ciencia de los datos arrojan increíbles oportunidades de progreso, pero es fundamental ser proactivo sobre los problemas de seguridad que le acompañan".

Las tesis sobre las que se han desempeñado este estudio es que sistemas GAN como los que han logrado ser hackeados por los expertos de McAfee son muy habituales en muchos recintos aeroportuarios. La idea es que Steve o Jesse, los 'hackers' protagonistas de este estudio de caso, fuesen individuos que tenían prohibido volar.

Gracias a este 'hackeo' al reconocimiento facial, lo habrían logrado.

Otros artículos interesantes:

Descubre más sobre Alberto R. Aguiar, autor/a de este artículo.

Conoce cómo trabajamos en Business Insider.