La promesa de Elon Musk y Deep Mind de no construir una IA asesina pasa por alto el verdadero problema según una académica de Oxford

- Los líderes tecnológicos, incluidos Elon Musk y los cofundadores de DeepMind, han firmado un compromiso la semana pasada para no desarrollar nunca "armas letales autónomas".

- La carta sostiene que, moralmente, la decisión de quitar la vida nunca debería delegarse en una máquina y que el armamento automático podría ser desastroso.

- Una docente de Oxford, la doctora Mariarosaria Taddeo, dice a Business Insider que, si bien las intenciones de la promesa eran buenas, pasa por alto la amenaza real que representa la inteligencia artificial en la guerra.

- Ella cree que el despliegue de inteligencia artificial en ciberseguridad ha pasado desapercibido, con consecuencias potencialmente dañinas.

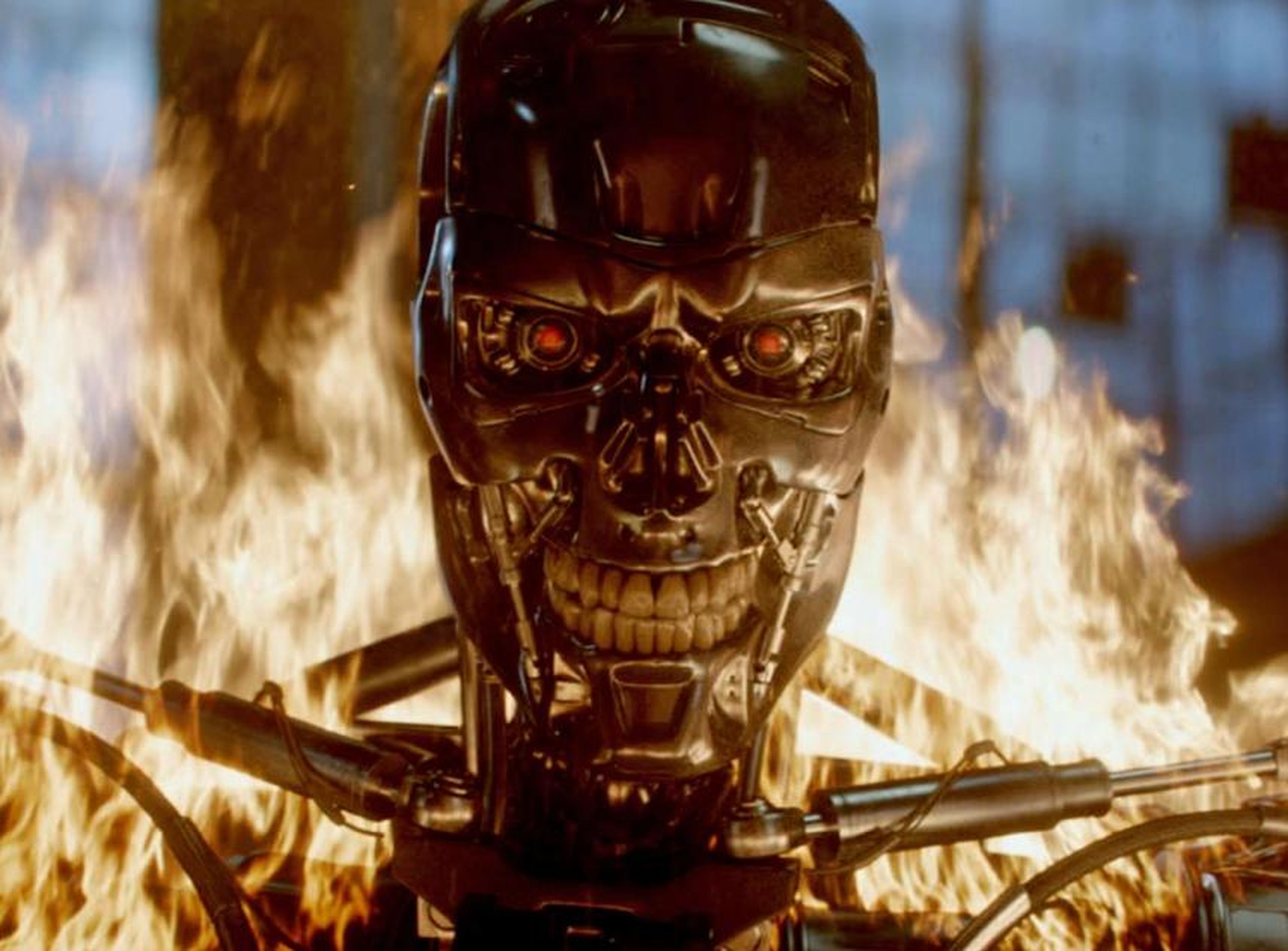

Prometer no hacer nunca robots asesinos es algo bueno.

Eso es lo que los líderes tecnológicos, incluidos Elon Musk y los cofundadores de la compañía de inteligencia artificial (IA) de Google, DeepMind, han hecho al firmar un compromiso en la Conferencia Conjunta Internacional sobre Inteligencia Artificial (IJCAI por sus siglas en inglés)

Afirman que nunca desarrollarían "armas letales autónomas", citando dos grandes razones. La primera es que sería moralmente erróneo, en su opinión, delegar la decisión de matar a un humano en una máquina.

Segundo, creen que las armas autónomas podrían ser "peligrosamente desestabilizadoras para cada país e individuo".

Leer más: La empresa española que quiere dar lecciones de ética a las máquinas de inteligencia artificial

Jurar que no habrá robots asesinos no es la cuestión

Business Insider ha hablad con la Dra. Mariarosaria Taddeo, del Instituto de Internet de Oxford, que expresa algunas preocupaciones sobre la promesa.

"Es encomiable, es una buena iniciativa", dice. "Pero creo que adoptan un enfoque demasiado simplista".

"No menciona usos más inminentes e impactantes de la IA en el contexto de conflictos internacionales", añade Taddeo.

"Mi preocupación es que al centrarnos solo en el caso extremo, los robots asesinos que se apoderan del mundo y este tipo de cosas, nos distraen. Desvían la atención y distraen el debate de los aspectos más matizados pero fundamentales de los que hay que encargarse."

¿La IA en el campo de batalla es menos aterradora que en los ordenadores?

El ejército de Estados Unidos hace una distinción entre IA en movimiento (es decir, IA que se aplica a un robot) y IA en reposo, que se encuentra en el software.

Los robots asesinos entrarían en la categoría de IA en movimiento, y algunos países ya implementan esta aplicación de hardware de IA. La Armada de Estados Unidos ha recibido un buque de guerra autónomo, e Israel tiene drones capaces de identificar y atacar objetivos de forma autónoma, aunque en este momento requieren de un ser humano dé el visto bueno.

Pero la IA en reposo es lo que Taddeo cree que necesita más escrutinio, es decir, el uso de la IA para la ciberdefensa nacional.

"Los ciberconflictos están escalando en frecuencia, impacto y sofisticación", asegura. "Los Estados dependen cada vez más de ellos, y la IA es una nueva capacidad que los estados están comenzando a utilizar en este contexto".

El virus WannaCry, que atacó al Servicio Nacional de Salud de Reino Unido en 2017, ha sido vinculado a Corea del Norte, y los gobiernos de Reino Unido y Estados Unidos culpan colectivamente a Rusia por el ataque ransomware NotPetya, que costó más de 1.200 millones de dólares.

Taddeo dice que lanzar sistemas de defensa de IA en este contexto podría aumentar seriamente la naturaleza de la ciberguerra.

"La IA en reposo básicamente puede defender los sistemas en los que está desplegada, pero también apuntar y responder de forma autónoma a un ataque que proviene de otra máquina", explica. "Si se toma esto en el contexto del conflicto interestatal, puede causar mucho daño. Con suerte, no dará lugar a la muerte de seres humanos, pero podría causar escaladas de conflictos, daños graves a infraestructura crítica nacional".

No se menciona a este tipo de IA en el compromiso de IJCAI, lo que Taddeo considera una omisión flagrante.

"La IA no se trata solo de robótica", dice. "AI también tiene que ver con lo cibernético, lo no físico. Y esto no lo hace menos problemático".

Leer más: EE.UU. prepara el ejército del futuro con enjambres de drones

Los sistemas de inteligencia artificial en guerra entre ellos podrían suponer un gran problema

Hoy, los sistemas de IA que se atacan entre sí no causan daño físico, pero Taddeo advierte que esto podría cambiar.

"Mientras más dependan nuestras sociedades de la inteligencia artificial, más probable es que los ataques que ocurran entre los sistemas de IA provoquen daño físico", afirma. "En marzo de este año, Estados Unidos anunció que Rusia había estado atacando infraestructura crítica nacional durante meses. Por lo tanto, supongamos que uno puede causar un apagón nacional o alterar un sistema de control de aire".

"Si comenzamos a tener sistemas de inteligencia artificial que pueden atacar de forma autónoma y defenderse autónomamente, es fácil que nos encontremos en una dinámica sobre la que no tenemos control", añade. En un artículo para Nature, Taddeo advierte sobre el riesgo de una "carrera de armas cibernéticas".

"Si bien los estados ya están desplegando esta IA agresiva, no hay regulación", afirma. "No hay normas sobre el comportamiento del estado en el ciberespacio. Y no sabemos por dónde empezar".

En 2004, las Naciones Unidas reunieron a un grupo de expertos para comprender y definir los principios sobre cómo deben comportarse los Estados en el ciberespacio, pero en 2017 no lograron ningún tipo de consenso.

Aún así, ella piensa que el acuerdo de no hacer robots asesinos es algo bueno. "No me malinterpreten, es un gesto agradable", dice. "Es un gesto que creo que no tendrá un impacto masivo en términos de políticas y regulaciones. Y están abordando un riesgo, y no hay nada de malo en eso. Pero el problema es más grande".

Otros artículos interesantes:

Conoce cómo trabajamos en Business Insider.