Robots con valores: los desafíos éticos de la Inteligencia Artificial

¿Te imaginas que pudieras conservar de forma virtual a un ser querido que ha muerto? Todos los datos que una vez volcó en Internet serían recopilados para construir una conciencia digital con la que podrías interactuar y tener la sensación de que hablas con la persona fallecida. Sí, es un capítulo de Black Mirror llamado Vuelvo enseguida, uno de los más desgarradores de la serie en el que la protagonista, incapaz de superar la muerte de su marido, reconstruye una versión virtual de él a través de una aplicación.

O quizá no sea un capítulo de una serie futurista. Quizá el futuro ya esté aquí y pertenezca a la Inteligencia Artificial. El proyecto Eterni.me consiste en una aplicación que almacena información de una persona mientras va creando una conciencia virtual que perdure después de su muerte y a la que sus allegados pueden tener acceso. El proyecto está aún en su fase beta pero aspira a crear un avatar con rostro del individuo y su misma voz. Sin duda es un avance tecnológico sin precedentes, pero ¿es ético?

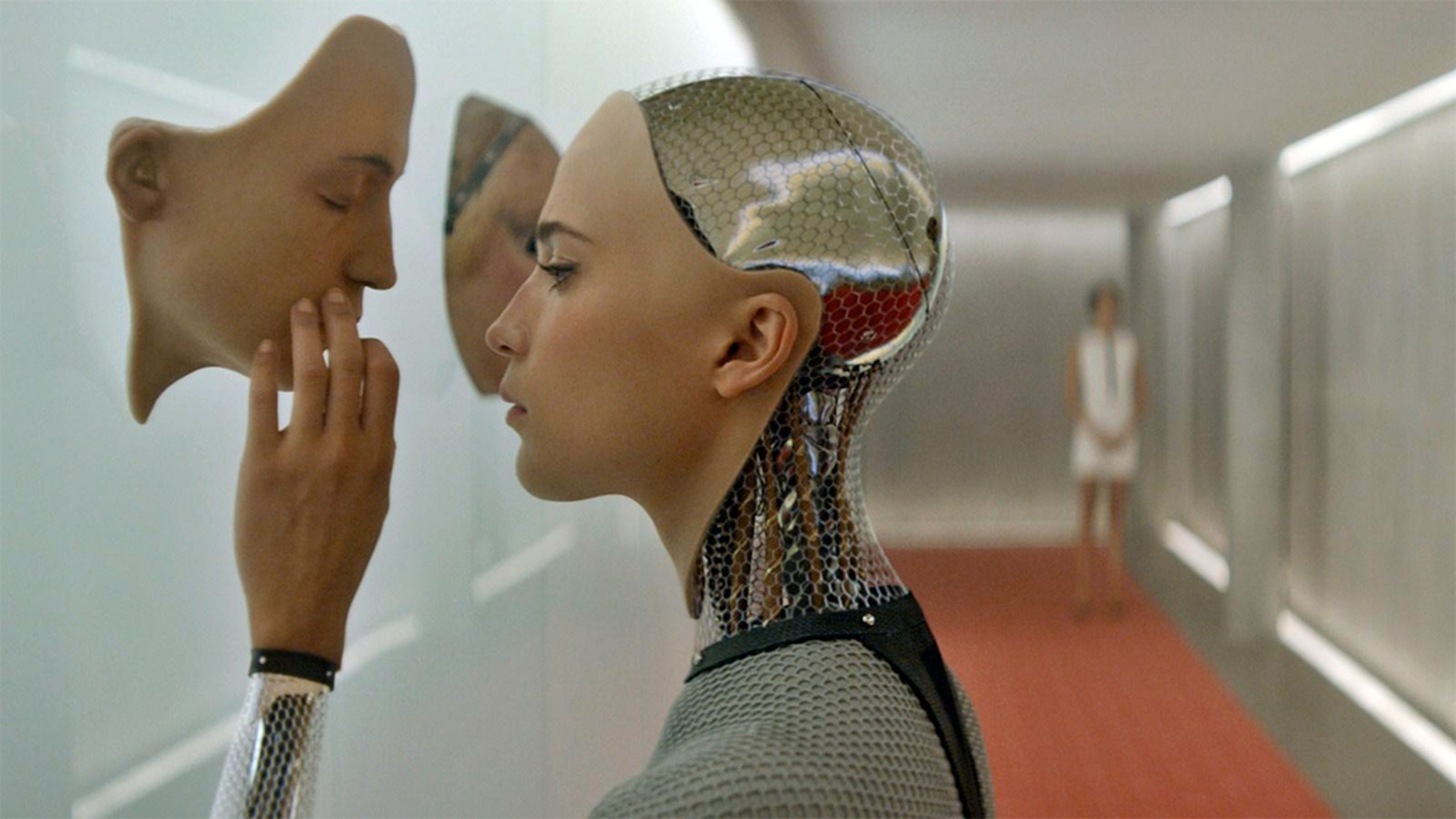

Desde C3PO en Star Wars, hasta los apocalípticos parques temáticos de Westworld, el desarrollo de la Inteligencia Artificial (IA) estado muy presente en el imaginario de la sociedad. Los problemas morales que lo acompañan también son sujeto de exploración en las series y películas de ahora.

Sin embargo, hace tiempo que la Inteligencia Artificial dejó de vivir solo en las historias de escritores y guionistas. Ahora es una realidad que supera a la ficción y que está presente en las estrategias de empresas de todos los ámbitos.

La IA está desarrollándose sobre todo en los campos de la publicidad, el transporte, las finanzas, la salud, la educación y la industria, según Forbes. El gasto mundial en IA alcanzará los 19.100 millones de dólares en 2018, de acuerdo a estimaciones de la consultora IDC.

Este imparable desarrollo viene acompañado de una creciente preocupación sobre sus consecuencias.

- ¿De quién es la culpa cuando un coche autónomo mata a alguien?

- ¿Cuántos empleos humanos van a perderse por la automatización?

- ¿Se puede enseñar valores éticos a un robot?

Son algunos de los interrogantes que se plantean y, aunque parecen un tanto apocalípticos, no son infundados.

Las empresas españolas del sector animan a no tener miedo a las transformaciones que conlleva la IA. "Creemos que no hay que tener temor, simplemente tenemos que adaptarnos al cambio" dice Cristina Sánchez, CEO de Acuilae, una empresa española que quiere dar lecciones de ética a las máquinas de inteligencia artificial.

"Si se hace de forma responsable, puede reportar beneficios y facilitar muchos aspectos del día a día." asegura Patricia Pascual, responsable de marketing de PiperLab, una empresa española especializada en el Big Data, el tratamiento y análisis de datos masivos.

Aún así, los expertos son conscientes de que la Inteligencia Artificial genera situaciones de conflicto. "Lo normal en este área es que primero se desarrolla y luego se pide perdón”, explica Cristina Sánchez. Aunque asegura que está habiendo cambios, como la introducción de asignaturas de ética en las carreras tecnológicas.

La Inteligencia Artificial podría igualar a la humana, pero es posible enseñarle valores

Las empresas se guían por códigos éticos y llevan autorregulándose mucho tiempo, según apuntaron recientemente algunos de los españoles más entendidos en la relación entre ética e inteligencia artificial durante una mesa redonda organizada por Accenture. Sin embargo, se siguen dando casos en los que el resultado del desarrollo de una IA no son los esperados.

En 2016, Microsoft lanzó un chatbot bautizado como Tay, diseñado para mantener conversaciones superficiales en redes sociales. El experimento duró poco más de 24 horas puesto que el invento degeneró al lanzar mensajes racistas y xenófobos.

Esta desviación es producto de que "nuestras comunidades tecnológicas no son diversas", según Karina Guzmán Dávila, responsable de Data Visualization and Data Analysis de Accenture. Dávila insiste en que es necesario que los equipos que integren los proyectos tecnológicos sean multidisciplinares e incluyan profesionales de otras ramas, como la filosofía.

No hay que confundir un mal comportamiento ético o moral con un “mal entrenamiento” de la máquina, puntualiza Francisco Escalona, Head of Data Strategy de Orange España. A veces las máquinas resultan en actividades éticamente reprochables que son producto de un fallo no intencionado en su programación.

Sin embargo, como demuestra el caso de Tay, la buena voluntad no es suficiente y sería recomendable que las IA no tuvieran solo inteligencia, sino también discernimiento.

Leer más: La cocina robot que prepara platos de estrella Michelín a 7 euros

En 2050 la inteligencia de los robots podría igualar a la de las personas y debería estar regulada por los límites de una ética y de una moral.

La pregunta es: ¿qué ética enseñamos? Más aun, ¿es posible enseñar códigos morales a un robot? El doctor Ford, uno de protagonistas de la serie Westworld (el personaje interpretado por Anthony Hopkins), lo tiene muy claro: “No podemos definir la conciencia porque no existe”.

Sin embargo, en la vida real la CEO de Acuilae no está de acuerdo con el arrogante y brillante director creativo del parque de robots."En IA, todo es posible con el suficiente conjunto de datos de entrenamiento", argumenta Cristina Sánchez.

De hecho, Acuilae ha desarrollado ETHYKA, "un proyecto que quiere implantar ética en distintos productos o servicios de IA" para así mejorar la confianza en la Inteligencia Artificial, según explica Sánchez.

"El principal desafío ético que supone el desarrollo de la IA, es su utilización por el ser humano con cordura, ética y moral", reconoce la CEO.

ETHYKA, que está en su fase de prototipo, ha tomado como base experimentos en medicina que pretendían volver a desarrollar un comportamiento ético en personas que lo habían perdido tras sufrir lesiones cerebrales.

En una situación en la que puede existir dilema, ETHYKA recopila y analiza toda la información posible y determina el paso siguiente en base a unos códigos morales que siguen los "diferentes patrones éticos y morales, criterios de decisión y comportamientos humanos."

Leer más: La empresa española que quiere dar lecciones de ética a las máquinas de inteligencia artificial

La IA se alimenta del Big Data, pero no sin tu consentimiento

En Japón, un robot se presentó como firme candidato a la alcaldía de un distrito de Tokio. Esto es solo un ejemplo de cómo cada vez más la IA abandona las tareas mecánicas y se “cuela” en los puestos de toma de decisión.

El desarrollo de este tipo de inteligencia tan avanzada requiere una gran cantidad de datos que plantea el problema de la privacidad y los usos ilegítimos que se podrían hacer de ellos.

La IA funciona gracias al Machine Learning, que permite que la máquina vaya aprendiendo comportamientos a partir de los datos. "El Big Data aporta una enorme cantidad de datos que alimentan los algoritmos de Machine Learning, y permiten crear modelos más complejos y con una mayor precisión", explica Luis Rodríguez, Data Scientist de PiperLab.

Frente al volumen de datos que esto exige, existen medidas para proteger la privacidad de los usuarios y no hacer un mal uso de los datos, tal y como recuerda Patricia Pascual.

En el caso de Piper Lab, suelen ser los propios clientes los que les proporcionan los datos, que se recogen siempre de forma anónima. Además, con el nuevo Reglamento General de Protección de Datos (RGPD), "las organizaciones y empresas debemos garantizar que cuando analizamos y trabajamos con datos, lo hagamos de forma que no sea posible identificar a una persona", asegura Pascual.

Aunque se pueden recoger todo tipo de datos, incluso los sensibles (edad, género, orientación sexual, política), el RGPD no permite tratarlos sin "el consentimiento expreso del usuario".

Los vacíos legales en la regulación de la IA

Cuando las cosas salen mal, no siempre está claro a quién pedir responsabilidades.

Cuando el daño es material, como por ejemplo un accidente de coche, se aplicará la normativa del territorio en el que se ha producido a sus mientras que si el daño es inmaterial, por ejemplo un insulto, la repuesta es más difícil porque ahora mismo "no hay normativa que lo regule", explica Álvaro Écija, Socio Director de la empresa de ciberseguridad Ecix Group, que se define como "abogado en mi país, ciberabogado en internet".

Un proyecto de IA debería incluir juristas que supervisen y realicen una "ponderación del riesgo y las consecuencias legales" del proyecto, cree el ciberabogado. Écija subraya que actualmente esto no se está haciendo ya que "se cree que la seguridad es una cuestión puramente técnica y en realidad es una cuestión de los derechos de las personas".

Ante las preocupaciones sobre el uso que se pueda dar a los datos en el desarrollo de la IA, por ejemplo que influyan en las decisiones humanas, parece que también existe un vacío legal. "Que sepamos, todavía no existe una regulación que especifique lo que no se puede hacer. No explícitamente." reconoce la responsable de marketing de Piper Lab.

Por eso, Pascual aboga por "la importancia y por la necesidad de hacer un uso responsable y ético con los datos" y la transparencia de las empresas.

Es necesaria una sociedad con cultura tecnológica, según afirma Amparo Grau, que participa actualmente en la creación del Libro Blanco de la Regulación de la Robótica interactiva en la Unión. Una sociedad consciente de los riesgos y de lo que entraña el avance de la IA porque "cuando tengamos esa cultura podremos forzar a los legisladores a legislar en estos temas".

¿Es realista dejarse llevar por el pesimismo de un futuro como el que se presenta en Westworld? "No puedes jugar a ser Dios sin conocer al Diablo" reflexiona de una forma un tanto siniestra el doctor Ford. El personaje de la serie no está solo, figuras conocidas como Elon Musk o Stephen Hawking han advertido varias veces contra la amenaza que representa el desarrollo de la IA.

"El éxito en la creación de la inteligencia artificial podrá ser el evento más grande en la historia de la humanidad. Desafortunadamente también sería el último, a menos de que aprendamos cómo evitar los riesgos", llegó a afirmar el famoso científico británico.

Aprendamos pues, a evitar los riesgos.

Otros artículos interesantes:

Descubre más sobre Ana Zarzalejos, autor/a de este artículo.

Conoce cómo trabajamos en Business Insider.