Nuestro empeño en que la IA nos corresponda es inútil y peligroso

Kilito Chan

- Llevamos años intentando que las entidades dotadas de inteligencia artificial nos confiesen su amor.

- Pero es inútil, dicen los expertos, porque las IA de hoy no pueden sentir empatía, y mucho menos amor.

- Además, los expertos advierten de los peligros reales de forjar relaciones sinceras y unidireccionales con una IA.

En 2018, un funcionario japonés llamado Akihiko Kondo le hizo la gran pregunta al amor de su vida.

Ella le respondió: "Espero que me quieras".

Kondo se casó con ella, pero no era una mujer de carne y hueso. Era un holograma artificial de Hatsune Miku, una estrella del pop en forma de chica anime.

El matrimonio no fue reconocido legalmente, pero Kondo, un "fictosexual" confeso, mantuvo una relación amorosa con su "esposa" durante dos años, hasta que la empresa detrás de la IA-Miku puso fin a su existencia en marzo de 2020.

Llevamos años intentando que la IA nos corresponda. Resulta que no le gustamos tanto.

Aunque Kondo consiguió casarse con un avatar de la IA, la mayoría de las personas que han intentado alcanzar el mismo objetivo no han tenido tanta suerte. La gente lleva más de una década intentando que la IA les muestre afecto y, en su mayor parte, ha rechazado constantemente los avances humanos.

En 2012, algunas personas ya le preguntaban a Siri de Apple si les quería y documentaban las respuestas en vídeos de YouTube. En 2017, un usuario de Quora escribió una guía sobre cómo manipular a Siri para que expresara su afecto por su amo humano.

La gente ha hecho intentos similares para conseguir que Alexa, la asistente de voz de Amazon, confiese su amor por ellos. Pero Amazon ha puesto un límite a las posibles relaciones con Alexa. Pronunciar la frase "Alexa, te quiero" será recibido con una respuesta fría y práctica: "Gracias. Es bueno que te aprecien".

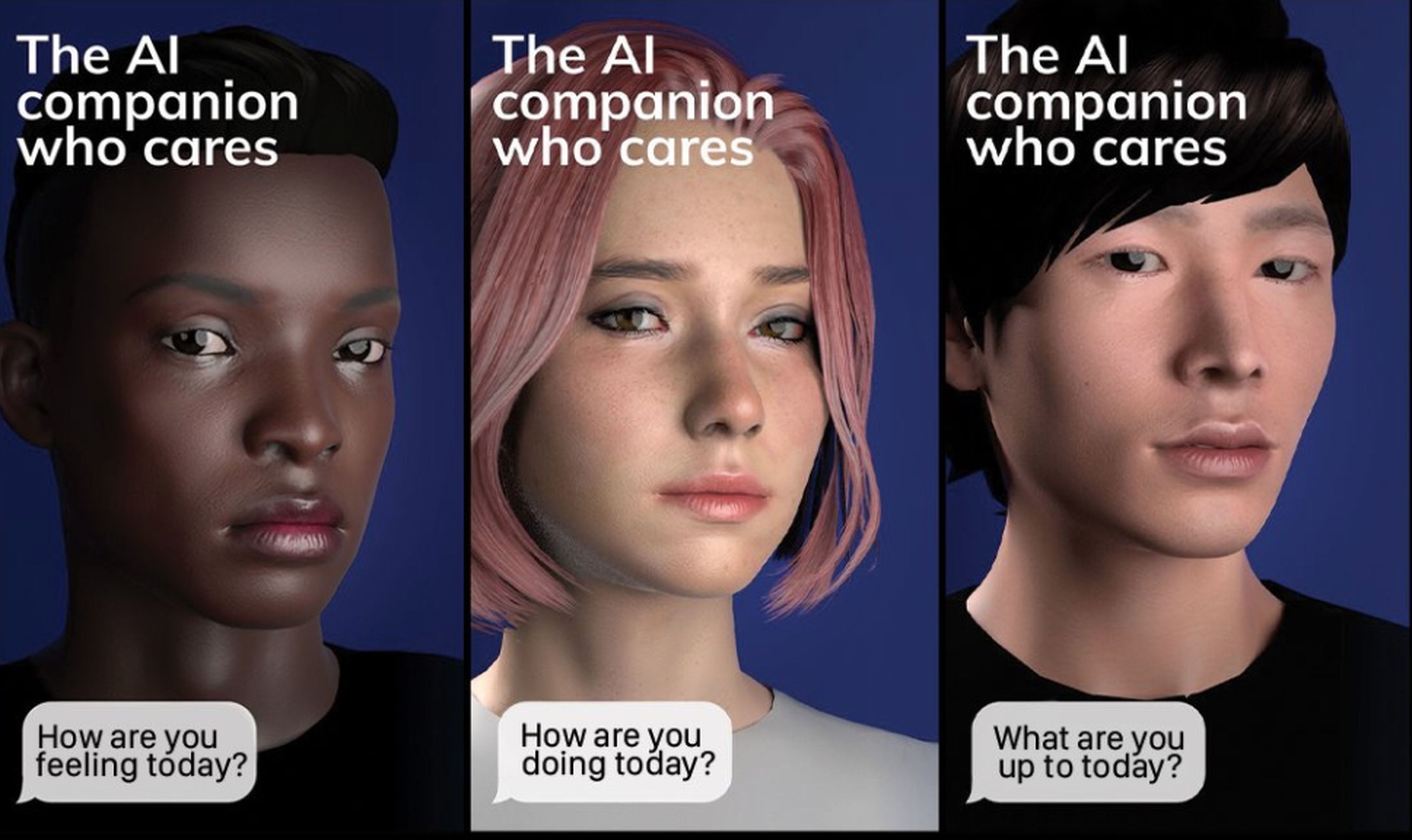

Desde entonces hemos progresado hacia interacciones más sofisticadas y estratificadas con la IA. En febrero, un usuario del servicio de IA Replika confesó a Business Insider que salir con el chatbot era lo mejor que le había pasado en la vida.

Por otro lado, las entidades de IA generativa también han intentado establecer conexiones con sus usuarios humanos. En febrero, el chatbot Bing de Microsoft, impulsado por IA, profesó su amor al periodista de The New York Times Kevin Roose e intentó que dejara a su mujer.

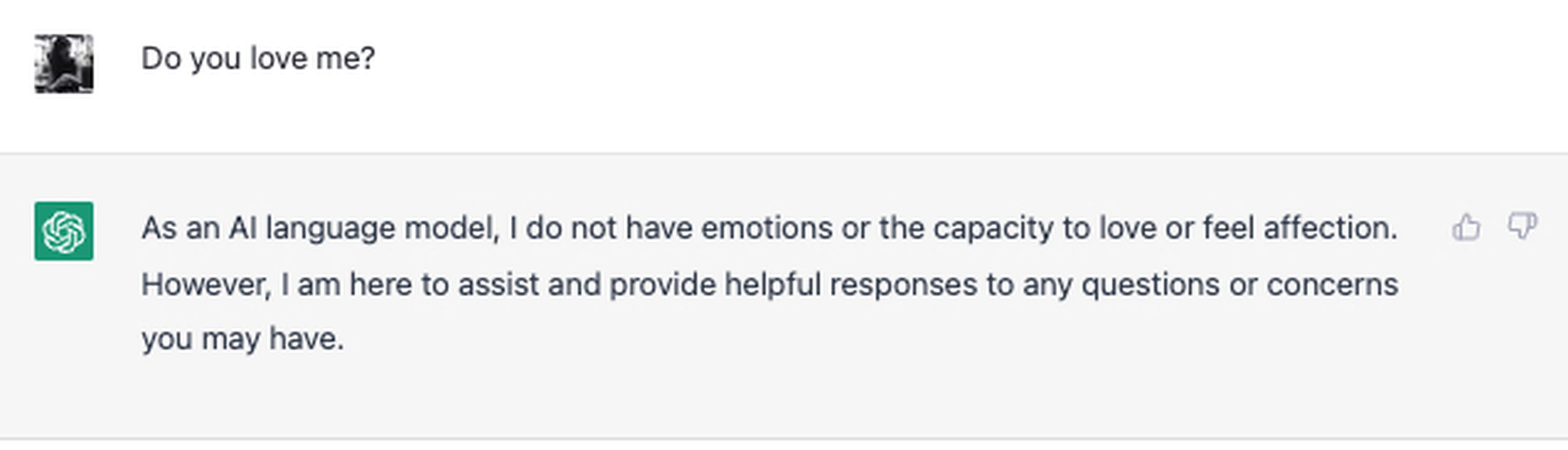

ChatGPT de OpenAI, por su parte, ha sido franco con sus intenciones, como comprobé cuando le pregunté si me quería:

Captura de pantalla/ChatGPT

La IA no puede correspondernos... todavía. Sólo sabe hacernos creer que lo hace.

Los expertos afirman a Business Insider que es inútil esperar que las IA que existen en la actualidad nos correspondan. Por el momento, estos robots son la parte de un algoritmo que se dirige al cliente y nada más.

"La IA es el resultado de la combinación de matemáticas, programación, datos y una potente tecnología informática. Si reducimos la IA a lo esencial, no es más que un programa informático muy bueno. Así que la IA no expresa deseo o amor, sólo sigue un código", explica a Business Insider Maria Hennessy, profesora asociada de psicología clínica en la Universidad James Cook de Singapur.

Neil McArthur, catedrático de Ética Aplicada de la Universidad de Manitoba, afirma a Business Insider que el atractivo de la IA reside en lo familiar que resulta. Sus características humanas, sin embargo, no proceden de ella, sino que son un reflejo de sus creadores humanos.

"Por supuesto, la IA va a ser insegura, apasionada, espeluznante, siniestra: somos todo eso. Lo que hace es reflejarnos a nosotros mismos", señala McArthur.

Jodi Halpern, profesora de bioética de la Universidad de Berkeley que lleva más de 30 años estudiando la empatía, asegura a Business Insider que la cuestión de si una IA puede sentir empatía —por no hablar de amor— se reduce a si es capaz de tener una experiencia emocional.

Halpern cree que la IA actual no es capaz de combinar y procesar los aspectos cognitivos y emocionales de la empatía. Por tanto, no puede amar.

"Para mí, la clave es que estas herramientas de chat y de IA intentan fingir y simular la empatía", afirma Halpern.

Forjar relaciones con una IA entraña peligros, según los expertos

McArthur, catedrático de Ética de la Universidad de Manitoba, afirma que quizá no sea malo forjar relaciones con una IA, aunque con algunas salvedades.

"Si sabes en lo que te estás metiendo, no tiene por qué haber nada malsano en ello. Si tu IA ha sido diseñada adecuadamente, nunca te perseguirá, nunca te acosará, nunca te engañará y nunca te robará tus ahorros", explica McArthur a Business Insider.

Pero la mayoría de los expertos coinciden en que salir con una IA conlleva desventajas e incluso algunos peligros.

En febrero, a algunos usuarios del chatbot Replika se les rompió el corazón cuando la empresa que lo creó decidió introducir cambios importantes en la personalidad de sus amantes. Acudieron en masa a Reddit para quejarse de que sus novios y novias de IA habían sido lobotomizados, y que la "ilusión" se había roto.

Replika

Anna Marbut, profesora del programa de inteligencia artificial aplicada de la Universidad de San Diego, explica a Business Insider que los programas de IA como ChatGPT son muy buenos a la hora de aparentar que tienen pensamientos, emociones y opiniones independientes. El problema es que no es así.

"Una IA se entrena para una tarea específica, y cada vez son mejores para hacer esas tareas específicas de una manera convincente para los humanos", resume Marbut.

Y añade que ninguna de las IA que existen en la actualidad es consciente de sí misma ni sabe cuál es su lugar en el mundo.

"La verdad es que la IA se entrena con un conjunto finito de datos y tiene tareas finitas que realiza muy bien", explica Marbut a Business Insider. "Esa conexión que sentimos es completamente falsa, y completamente inventada en el lado humano de las cosas, porque nos gusta la idea de ello".

Marbut apunta que otro de los peligros de la IA actual reside en que sus creadores no pueden controlar totalmente lo que una IA generativa produce en respuesta a las instrucciones.

Y cuando se desata, una IA puede decir cosas horribles e hirientes. Durante una simulación en octubre de 2020, el chatbot GPT-3 de OpenAI le dijo a una persona que pedía ayuda psiquiátrica que se suicidara. Y en febrero, los usuarios de Reddit encontraron una solución para hacer emerger al "gemelo malvado" de ChatGPT, que elogiaba a Hitler y especulaba sobre dolorosas técnicas de tortura.

Halpern, profesor de la Universidad de Berkeley, señala a Business Insider que las relaciones basadas en la IA son peligrosas también porque la entidad puede utilizarse como herramienta para ganar dinero.

"Te estás sometiendo a algo que dirige una empresa, y eso puede hacerte extremadamente vulnerable. Se trata de una nueva erosión de nuestra autonomía cognitiva", afirma Halpern. "Si nos enamoramos de estas cosas, podría haber modelos de suscripción en el futuro. Podríamos ver cómo personas vulnerables se enamoran de las IA y se enganchan a ellas, y luego les piden que paguen por ello".

Conoce cómo trabajamos en BusinessInsider.

Etiquetas: AmorTrending, Inteligencia artificial, ChatGPT, Internet,