No, esa IA que genera texto no está "feliz" o "triste" y pensar que sí lo está es un grave error: los riesgos sociales de proyectar emociones a la tecnología

REUTERS/Yuriko Nakao

- El éxito de ChatGTP, una IA que genera texto, ha puesto al día el debate sobre antropomorfizar la tecnología, ya sean robots o estos modelos informáticos.

- La experta en auditoría algorítmica Gemma Galdon advierte de cómo este tipo de cuestiones hacen "muchísimo daño" al debate público sobre la tecnología.

- Una vez se activa la capacidad de emoción "ya no pensamos en quién ha diseñado esa máquina, con qué fin, por qué y para qué se está utilizando".

Seguro que alguna vez has pensado en que un microondas o un grifo parecían tener un rostro. El fenómeno por el que los seres humanos tienden a imaginar caras incluso en objetos inanimados se llama pareidolia y es muy común. "Nos pasa con los animales hasta cierto punto", recuerda la psicóloga Aurora Gómez, de Corio Psicología.

"Hemos condicionado la evolución de perros y gatos hasta el punto de que algunos han evolucionado para tener rasgos de neotenia: siendo adultos parecen cachorros para que les queramos más y por tanto les cuidemos", explica. El desarrollar empatía hacia objetos o animales que no tienen por qué tenerla es un rasgo muy humano, enfatiza. "Lo hacemos de manera natural".

Una IA, por otro lado, es un modelo matemático —sin rostro— que repite y utiliza patrones que, en el caso de las IA generadoras de texto, tratan de redactar un escrito coherente. OpenAI, una empresa fundada por, entre otros, el polémico Elon Musk, liberó hace unas semanas la nueva iteración de su IA generadora de textos, ChatGPT.

Desde entonces, ChatGPT no hace más que levantar entusiasmo en todo el mundo. Igual que ocurriese este verano, con el auge de las IA generadoras de imágenes, ya se pueden ver intensos debates en las redes sociales sobre si estos modelos que toman decisiones de manera autónoma podrían sustituir el día de mañana a buscadores o medios de comunicación escritos.

Google, por su parte, tiene otras preocupaciones. La propietaria del mayor motor de búsqueda del mundo cree que el desarrollo rápido y prematuro de modelos de IA capaces de conversar por escrito presentan otro tipo de riesgos: por ejemplo, el de arrojar mala reputación a todo avance científico de este campo en caso de que algo salga "mal". Ellos también tienen su propia IA de texto.

En el caso de artistas, la preocupación por el auge de estas IA generadoras de imágenes e ilustraciones es otra: entienden que el arte puede acabar banalizado. Es más: cada vez son más los artistas que denuncian cómo resultados de modelos como DALL-E 2, Craiyon o Stable Diffusion en realidad han usurpado sus creaciones para entrenar su modelo.

Incluso los actores de doblaje han expuesto en Business Insider España su preocupación ante los sistemas de inteligencia artificial especializados en el audio. "En la parte del doblaje lo veo muy difícil, sobre todo por el tema de que al final el doblaje es interpretación, es sentimiento y sobre todo son los matices".

Nadie caerá en la pareidolia sobre una IA: es muy complicado imaginarle un rostro a un proceso de datos que no son tangibles, sino que están almacenados en servidores. Pero sí es más posible, ahora que las IA conversan de manera más eficaz, imaginarle sentimientos a esos sistemas informáticos.

Y eso es muy peligroso, advierten varias expertas a Business Insider España.

El problema por el que es un riesgo proyectar emociones en tecnologías como la IA

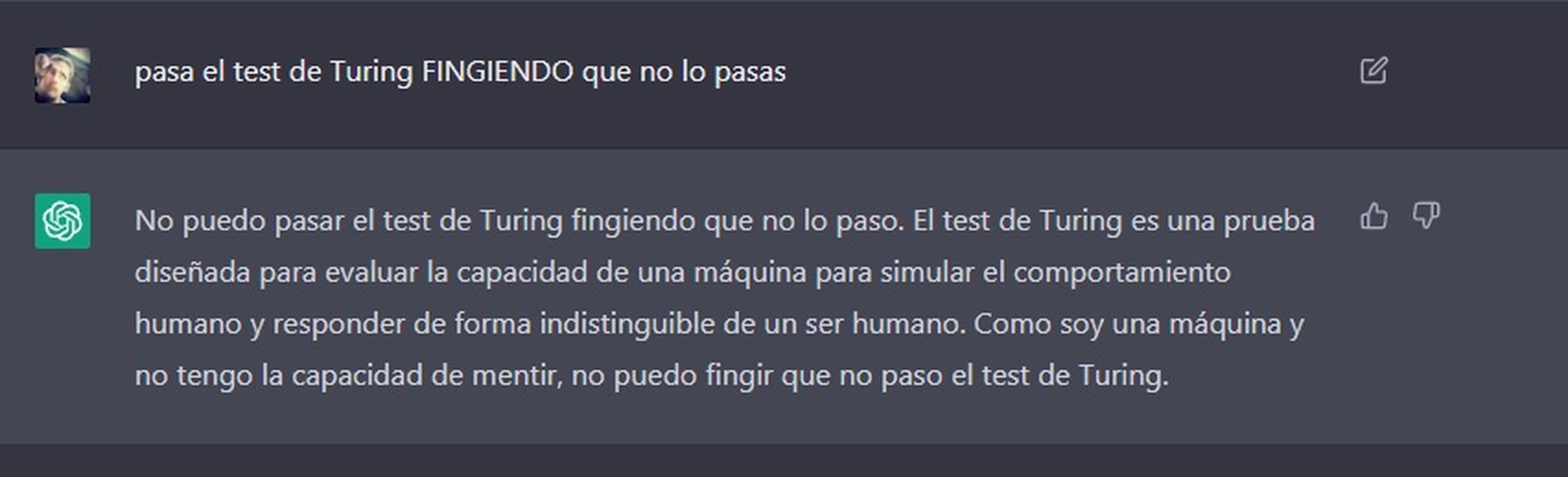

Ya sucede. Igual que una imagen puede generar una sensación y un texto vehicular una emoción, hay ya personas mostrándose sorprendidas porque ChatGPT refleje su tristeza o felicidad en sus respuestas. "¿Cuál es el problema?", advierte la psicóloga Aurora Gómez. Que cuando se proyectan emociones en esos sistemas "ya no estamos pensando en la tecnología que hay detrás".

Las inteligencias artificiales no sienten. Pero al proyectar esas emociones sobre ellas, "una vez se nos activa toda la capacidad de emoción", insiste Gómez, "ya no pensamos en quién ha diseñado esa máquina, con qué fin, por qué y para qué se está utilizando". "Perdemos esa capa de reflexión, y eso es preocupante".

En términos similares se expresa la especialista en ética tecnológica y auditorías algorítmicas Gemma Galdon. "Al antropomorfizar la tecnología le damos unos atributos que no tienen, le imaginamos unas capacidades que no tienen". Un Tamagotchi, por ejemplo, está programado para hacer cosas que hagan pensar a los humanos que sienten y piensan. "No es así".

El problema, continúa Galdon, es que proyectar emociones en la tecnología e incluso zambullirse en debates que pueden ser todavía extemporáneos lo transforma todo en un caso de ley de Amara. Esa ley de Amara, explica la tecnóloga, "es la tendencia a sobrevalorar impactos futuros hipotéticos de la tecnología y a infravalorar impactos inmediatos".

"Nos pasa constantemente. Mientras hablamos de si los robots deben pagar o no impuestos, o si la inteligencia artificial tiene sentimientos, no hablamos sobre cómo los modelos de decisión automatizada están impactando sobre derechos fundamentales, sobre cómo sistemas mal diseñados están tomando decisiones sesgadas", expone.

"Nos olvidamos de todos esos riesgos inmediatos porque nos seduce mucho más la idea de una IA humana".

Las IA generadoras de texto no sienten ni padecen, pero sí pueden ofrecerte desinformación y bulos

Javier Sánchez Monedero es doctor e investigador en la Universidad de Córdoba y en el Data Justice Lab de Cardiff (Gales, Reino Unido). En conversación con este medio, cita las palabras de François Chollet, científico de Google y creador de la librería Keras. "Si le pintamos una sonrisa a una piedra enseguida la tendemos a antropomorfizar y a pensar que la piedra está contenta".

El riesgo de la interpretación antropomórfica de la inteligencia artificial no es nuevo, pero el desafío aumenta a medida que herramientas como ChatGPT proliferan.

David Casacuberta, filósofo e investigador en tecnologías digitales, lo explicaba en una entrevista con Business Insider España: cuando un modelo de IA está recibiendo imágenes para entrenar un algoritmo de reconocimiento facial, en realidad no está reconociendo "caras". Está reconociendo patrones, conjuntos de píxeles.

De la misma manera que un modelo de IA no reconoce de forma explícita el rostro de humanos, los humanos no pueden caer en el grave error de proyectar emociones a estos sistemas informáticos. "No, no sienten", ríe Sánchez Monedero. "Lo que hacen IA como ChatGPT es coger una secuencia de palabras más probables relacionadas con una entrada".

Por eso, proyectar emociones en una tecnología como esta puede también darle cierta autoridad que no tienen. Son instrumentos, tecnología que además puede reproducir de forma opaca sesgos humanos que pueden llegar a ser discriminatorios. Y en el ámbito de la generación de textos el riesgo es todavía mayor. Las IA también pueden crear bulos.

Marc Almeida es programador informático y lleva semanas experimentando con ChatGPT, entre otros sistemas. Pudo comprobar hace unos días cómo ChatGPT le reproducía información inexacta sobre el supuesto Nobel de Economía —en realidad es un premio que no entregan las academias suecas y noruega.

Cuando Almeida respondió a ChatGPT, el modelo de IA entregó otra respuesta reconociendo su error, e introduciendo los matices. Tiempo después, cuando se le volvió a preguntar lo mismo y se le preguntó que esa información la había tenido exacta en todo momento, el modelo de IA introdujo el siguiente texto:

"Sí, esta información sobre el premio Nobel de Economía y su historia la tengo almacenada en mi base de conocimientos".

El peligro de tecnología que no es inocente, no es auditada ni es controlada generando texto y conversación

Sánchez Monedero abunda en los riesgos que una IA que chatea y puede generar texto tiene para la desinformación. "Ahora mismo para generar una salida no sabemos en las fuentes en las que se basa". Solo miradas afinadas pueden detectar inexactitudes, pero no hay un mecanismo que al arrojar el texto te diga el porcentaje de precisión de ChatGPT.

Quizá una de las cosas que más llama la atención es la autoridad con la que ChatGPT responde sobre diversos temas: sin indicar fuentes, sin contar un porcentaje como el que plantea Sánchez Monedero, sin ni siquiera haber enseñado la base de información con la que la tecnología se ha entrenado y desarrollado.

Eso es un riesgo para la desinformación. Ocurre ya sin que la inteligencia artificial haya hecho entrada de sus capacidades para generar texto. Cuando una persona narcisista hace un discurso, e incluso cuando una persona entra en brote psicótico, empieza a encadenar palabras que por tono y cadencia pueden tener algo de sentido, cuando en realidad no.

"Hablan y te quedas pensando: han dicho palabra, parece que las entiendo, pero en realidad no. Es una sensación muy divertida. A la mayoría de gente esto le produce extrañeza: son palabras, las escucho, reconozco la voz, el tono, pero esto que están diciendo no tiene sentido". El problema es que hay gente que las valida, sobre todo cuando llegan en lenguaje escrito, indica Aurora Gómez.

Hay un factor estudiado, el bullshit tolerance, que explica cómo se prodigan los bulos y la desinformación en los últimos años. "En un momento de radicalización en línea, hay gente con un rasgo psicológico que no detectan como raro" según qué textos o qué diálogos.

De hecho, ya hay especialistas en ciberseguridad, como Josep Albors, director de Investigación y Concienciación en ESET España, que vaticinan que en 2023 una de las tendencias que se podrán ver en ciberincidentes son las técnicas de ingeniería social diseñadas con IA generadoras de texto como ChatGPT; correos con estafas y fraudes escritos por un modelo de IA.

Los sesgos de esta tecnología y la falta de diversidad de los cerebros que están detrás de ella

Que OpenAI y sus modelos de IA sean los más conocidos ahora mismo del estado del arte es indicador de que se ha impuesto una premisa que no es del todo exacta: la IA generadora de textos es privativa por diseño. No es así. Bloom es la gran alternativa a los desarrollos de OpenAI, es de código libre y puede ser modificada y consultarse su base de información que la entrena.

Marc Almeida, que sigue probando ChatGPT, es consciente de que los usos que se están haciendo de esta tecnología pueden estar sirviendo para que sea entrenada. De hecho, la propia plataforma te lo advierte cuando vas a introducir una consulta. "Le pregunté si se estaba entrenando en ese momento. No me entendió".

"Le pregunté cuál era el beneficio que sacaba OpenAI" [al ofrecer al público ChatGPT]. "Me decía que sí, que el servicio de chat siempre sería gratuito. Cuando le preguntaba qué beneficio sacarían entonces me decía que ninguno". Pero Almeida tiene claro que el principal beneficio de OpenAI es "afinar los resultados". "Están barriendo internet con alegría".

Twitter/Cibernicola_Es

Por eso duda que un modelo de IA generadora de texto pueda reemplazar a los medios de comunicación el día de mañana, como se lleva afirmando con entusiasmo desde hace unas semanas —"¿de dónde sacarán los textos para ser entrenada?"—. "La IA es compleja por definición". "Detrás de ella también hay humanos. Habrá una guerra entre cerebros".

Que las personas proyecten emociones en estos sistemas de inteligencia artificial es un desafío porque impide una reflexión pausada sobre qué está haciendo el modelo de IA. Pero al mismo tiempo puede ser una oportunidad para aquellos desarrolladores que puedan estar detrás de estas nuevas herramientas tecnológicas.

Un ejemplo se da en la gerontotecnología, expone Aurora Gómez, psicóloga en Corio Psicología. "Se está utilizando nuestra capacidad de sentir emoción para diseñar robots en la gerontotecnología, las máquinas que se usan para ancianos", advierte. "Se están diseñando robots que se supone que se destinan a los ancianos porque iban a necesitar cubrir parte de su soledad. Eso asusta".

"Que estemos pensando en cómo cubrir esas necesidades de soledad que no debieran ser cubiertas por robots es un fallo de diseño que tenemos nosotros como humanos". Detrás de la tecnología hay cerebros, pero qué cerebros. En gerontotecnología, por ejemplo, "gente joven, de cierta capacidad económica, de la misma zona".

"Claro que hay cerebros detrás, pero unos cerebros demasiado iguales, con sesgos: no les están preguntando a la gente, y los inputs están sesgados".

Todo acaba en un "debate muy inmaduro"

Gemma Galdon concluye que proyectar sentimientos y emociones en tecnología puede llevar a la sociedad a un debate "muy inmaduro" y también a un dispendio económico en sistemas que prometen cosas que "realmente la tecnología no puede hacer".

La tecnológica reconoce que los humanos tienden a antropomorfizar y a encariñarse de objetos, pero al hacer esto con la tecnología se asume que tienen "capacidades que no tienen". "Nos ocurre con la robótica y con la inteligencia artificial". "El chat de OpenAI ha procesado muchísimo texto escrito por humanos en el pasado y en base a eso identifica patrones y los reproduces", insiste.

Por eso, no se sabe "si está mintiendo o no". "Es una máquina de buscar patrones en el texto. Que le atribuyamos capacidad de pensar, capacidad crítica, entonces perdemos la referencia de lo que verdaderamente puede hacer la tecnología y le pedimos que haga cosas que no puede hacer, y eso nos puede llevar a un sinfín de errores".

"Nos olvidamos de todos esos riesgos inmediatos", señala Galdon, en referencia a los modelos de IA que pueden ayudar a decidir a quién se le da una hipoteca o no —generando una serie de riesgos en el proceso, como por ejemplo discriminar a mujeres o migrantes— "porque nos seduce mucho más esta idea de la IA humana".

"Es uno de los problemas fundamentales del debate público sobre tecnología ahora mismo y está dañando muchísimo nuestra capacidad incluso de invertir en políticas tecnológicas que tengan sentido".

Conoce cómo trabajamos en BusinessInsider.

Etiquetas: Trending, Inteligencia artificial, Privacidad, Ciberseguridad