Las empresas europeas son las que más impulsan la ética en los algoritmos, aunque la mayoría siguen sobreestimando sus avances, según BCG

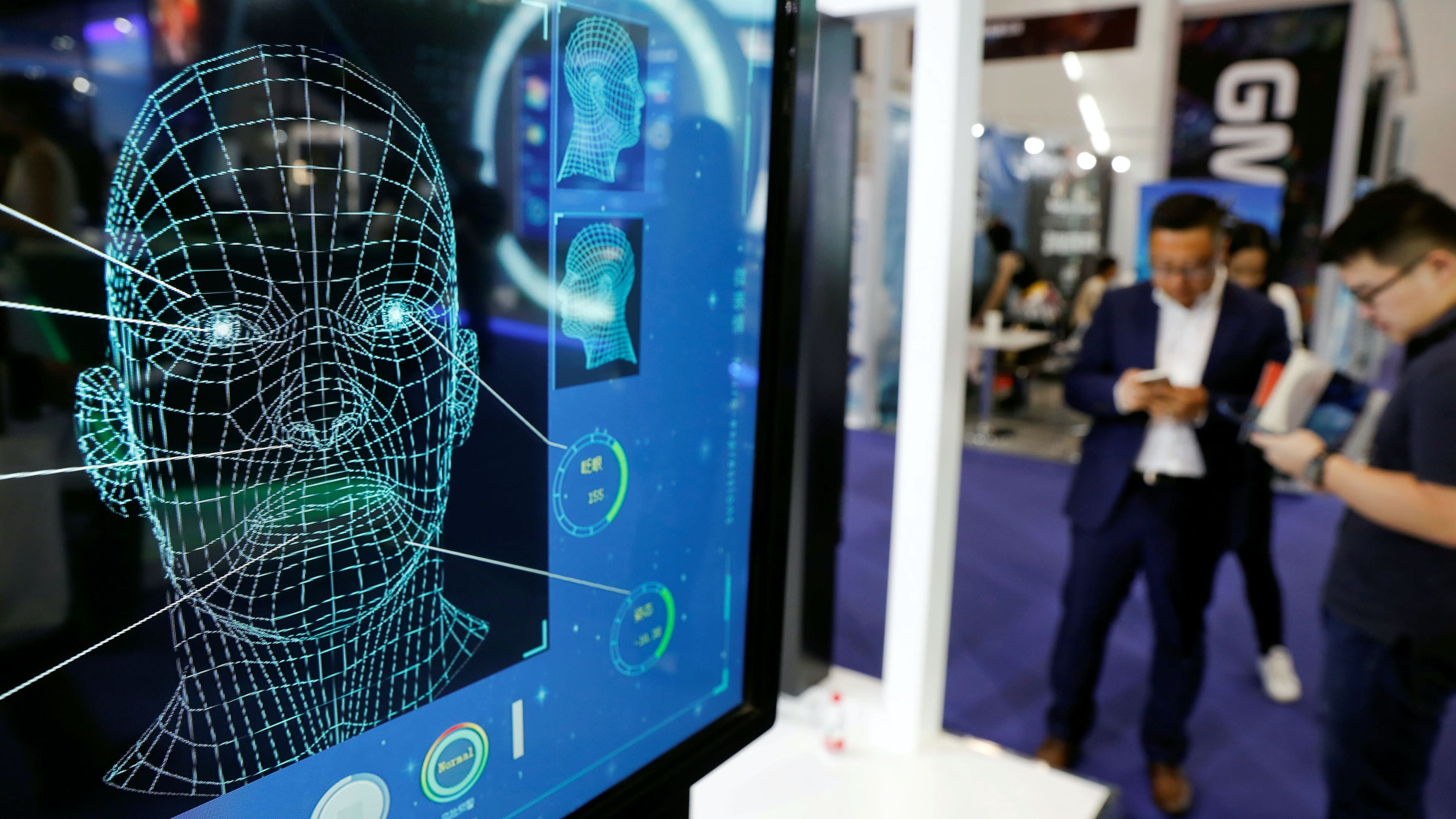

REUTERS/Damir Sagolj

- Un estudio de BCG determina que la mayoría de las grandes empresas sobreestiman sus progresos para conseguir una inteligencia artificial más ética y responsable.

- Europa es la región en la que las compañías están más concienciadas en conseguir que los algoritmos minimicen sus impactos sociales negativos.

- Descubre más historias en Business Insider España.

La IA responsable o la ética en los algoritmos son términos de los que cada vez se habla más.

Prueba de ello es un reciente estudio que la división de análisis de Boston Consulting Group (BCG), BCG GAMMA, ha elaborado con más de 1.000 empresas y organizaciones de varios rincones del mundo. Lo que pretendía la consultora es comprobar si la implementación de los sistemas de inteligencia artificial en todo tipo de compañías se están ajustando a unos mínimos éticos.

BCG define esta problemática a abordar como una estrategia de "IA responsable". Y los resultados eran los que cabían esperar. La mayoría de las grandes empresas que contestaron a la encuesta de la firma sobrevaloraron sus progresos en materia de IA responsable.

De todos los encuestados, el 35% reconoció haber impulsado estrategias para conseguir sistema de IA más responsables en sus organizaciones. De estas empresas, el 55% habían sobreestimado los esfuerzos que en realidad habían hecho hasta la fecha. Queda todavía mucho trabajo por hacer.

Para la consultora, la IA responsable no es otra cosa que "desarrollar y operar un sistema de inteligencia artificial que integre la empatía, la creatividad y el cuidado propio de los seres humanos". Solo así se garantiza que estos sistemas trabajen "en servicio del bien" mientras se consiguen "cambios de calado en el negocio".

La IA responsable, según BCG

¿En la práctica? La IA responsable supone "asegurarse de que los objetivos y las consecuencias de estas inteligencias artificiales son justos, carecen de sesgos y su funcionamiento es explicable". "Que son robustos y seguros", que siguen "buenas prácticas en gobernanza de datos" para garantizar la privacidad de las personas, y que "minimizan los impactos negativos sociales y medioambientales" de esta tecnología. En definitiva, que una IA "aumente" la capacidad del ser humano: no que la reemplace.

Esas son las siete principales dimensiones que BCG ha analizado para garantizar una IA responsable: transparencia, explicabilidad, justicia, seguridad, privacidad, mitigación de impactos negativos, y aumento de la capacidad humana. La encuesta de BCG se detuvo en cada uno de esos siete puntos. Los encuestados tenían que responder en una escala cómo de implementado estaba ese principio en el despliegue de la IA en sus respectivos negocios.

Con sus respuestas por escala y principios, Boston Consulting Group determina en qué estado está la adopción de una IA responsable por parte de una organización. Así, si ha obtenido menos de 28 puntos de media, BCG entiende que la empresa que ha atendido la encuesta está atrasada en cuanto al desarrollo de su estrategia de una IA responsable. Si consigue unos 53 puntos, considera que está en desarrollo.

Solo si supera los 74 puntos, BCG considera que la empresa en cuestión está progresando y avanzando en el despliegue de una IA responsable, pero que todavía necesita perfilar y retocar cuestiones para que estos sistemas no reemplacen humanos, sino que aumenten sus capacidades. Las compañías que han obtenido 97 puntos de media o más son consideradas "líderes" en su campo.

Las empresas europeas, las más implicadas

Con una media de 66,8 puntos, las empresas europeas han resultado ser las organizaciones que más avanzadas tienen sus estrategias para conseguir una IA responsable. Le sigue de cerca las compañías en EEUU que han obtenido una media de 66,3 puntos. En cuanto a sectores, las telecos y tecnológicas son líderes, seguidas de las energéticas y de las empresas financieras.

BCG también destaca cómo industrias como el del automóvil han salido mejor paradas de lo esperado: "Los principios de IA responsable son más sencillas de implementar al estar enfocadas en operaciones empresariales o B2B".

En España, Gemma Galdon es una de las mayores especialistas de este campo. Fundó y dirige una consultora que se dedica a auditar los sistemas de inteligencia artificial de compañías y entidades públicas para detectar, si los hubiera, sesgos en la aplicación de esos algoritmos que podrían acabar discriminando a las personas.

De hecho, la propia Galdon detalló en un reciente seminario web cómo las mujeres, a pesar de ser tan buenas pagadoras como los hombres, sufren discriminación a la hora de solicitar un préstamo hipotecario en determinadas entidades bancarias por culpa del sesgo en los algoritmos.

Galdon, al frente de Eticas Consulting, considera que el suyo es un mercado a punto de abrirse, y en varias entrevistas con Business Insider España ha destacado cómo nacen estos sesgos en los algoritmos y qué metodología utiliza para abordarlos.

Conoce cómo trabajamos en BusinessInsider.

Etiquetas: Trending, Inteligencia artificial, Empresa