Apple supuestamente amenazó a Facebook con retirarla de la App Store por preocupaciones en torno a la trata de personas

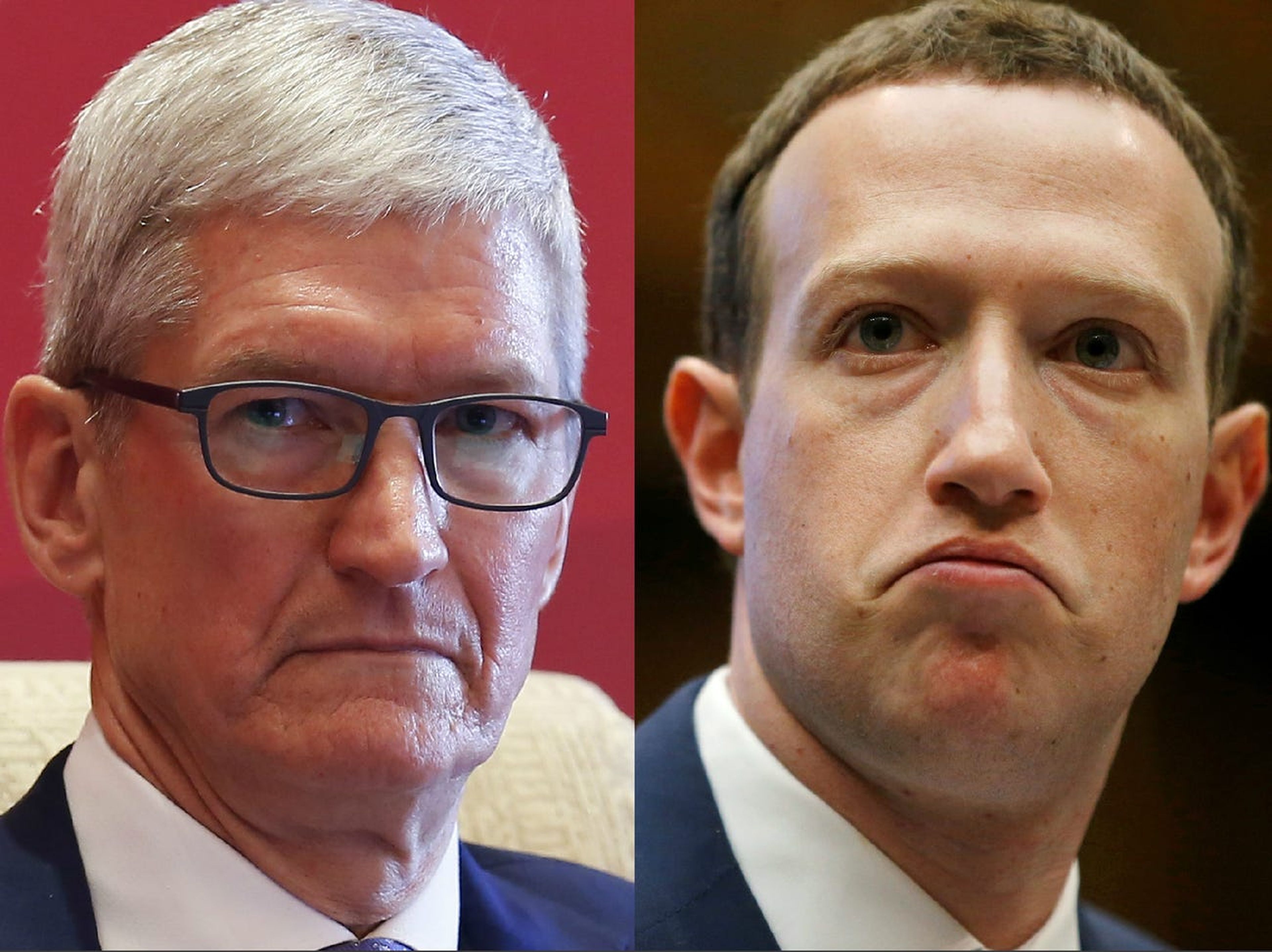

Visual China Group, Reuters

- Apple amenazó a Facebook con retirar la plataforma de la App Store después de conocerse un informe sobre un mercado de esclavos en línea.

- En 2019, la BBC informó que los traficantes de personas estaban utilizando los servicios de Facebook para vender trabajadores domésticos.

- The Wall Street Journal informa que Facebook conocía la práctica incluso antes de que Apple hiciese la amenaza.

- Descubre más historias en Business Insider España.

Apple amenazó con expulsar a Facebook de la App Store después de que un reportaje de la BBC de 2019 detallará cómo los traficantes de personas usaban Facebook, según The Wall Street Journal.

El periódico estadounidense ha tenido acceso a documentos de la compañía que muestran que un equipo de investigación de Facebook estaba rastreando un mercado de tráfico de personas en Oriente Medio cuyos organizadores estaban utilizando los servicios de Facebook.

Lo que parecían ser agencias de empleo en realidad publicitaban a trabajadores domésticos contra su voluntad, según el WSJ.

La BBC publicó una amplia investigación encubierta de la práctica, lo que llevó a Apple a amenazar a Facebook con retirarla de su App Store.

Un documento interno revela que Facebook estaba al tanto de la práctica incluso antes de esa fecha: un investigador de Facebook escribió en un informe con fecha de 2019, "¿Este problema era conocido por Facebook antes de la investigación de la BBC y la escalada de Apple?", según el WSJ.

Debajo puede leerse: "Sí. A lo largo de 2018 y el primer semestre de 2019, realizamos el Ejercicio de comprensión global entender bien cómo se manifiesta en nuestra plataforma el fenómeno de la esclavitud doméstica en todo su ciclo de vida: captación, facilitación y explotación".

Apple y Facebook no han respondido a las solicitudes de comentarios al respecto de esta noticia.

The Wall Street Journal también ha explicado recientemente cómo los moderadores de contenido de inteligencia artificial de Facebook no pueden detectar la mayoría de los idiomas utilizados en la plataforma, una habilidad necesaria si la empresa pretende monitorizar el contenido en los mercados extranjeros donde se ha expandido.

Los documentos a los que ha tenido acceso el periódico estadounidense demuestran que los moderadores humanos no saben hablar los idiomas que se utilizan en esos mercados, lo que deja un punto ciego en los esfuerzos de la empresa para tomar medidas enérgicas contra el contenido dañino.

Un resultado de esta situación, según The Wall Street Journal, fue que los cárteles de la droga y los traficantes de personas usaban la plataforma para hacer negocios.

Otros artículos interesantes:

Conoce cómo trabajamos en Business Insider.