La inteligencia artificial es una amenaza mayor para la humanidad que el cambio climático, según el profesor de Oxford avalado por Bill Gates

- Nick Bostrom, profesor de filosofía en la Universidad de Oxford, es un experto en los riesgos que plantea la inteligencia artificial.

- Bostrom, cuyo trabajo ha sido respaldado por Elon Musk y Bill Gates, dice a Business Insider que la IA es "una amenaza mayor para la existencia humana que el cambio climático".

- Dice que es "mucho esperar" que las grandes compañías de tecnología, como Google y Facebook, diseñen sus propios marcos éticos para la IA.

- Bostrom también afirma que cree que debería haber más gente con conocimientos básicos de IA en los gobiernos.

Uno de los principales pensadores del mundo sobre inteligencia artificial dice que la tecnología es una amenaza mayor para la civilización que el cambio climático.

Nick Bostrom, profesor de filosofía de Oxford, dice a Business Insider: "La IA es una amenaza mayor para la existencia humana que el cambio climático. El cambio climático no va a ser el mayor cambio que veamos en este siglo".

Añade: "Es poco probable que el cambio climático tenga una buena solución, pero si el desarrollo de AI sale mal, será mucho peor que el cambio climático. "La IA puede ser beneficiar mucho a la humanidad, pero también puede salir muy mal".

Bostrom es un pensador reconocido en su campo, habiendo publicado libros como Superintelligence: Paths, Dangers, Strategies. También es un caso inusual ya que convence a ambos lados del debate: su trabajo ha sido respaldado por Elon Musk, que ha expresado puntos de vista apocalípticos sobre la IA, y Bill Gates, un cauteloso y optimista defensor de la tecnología.

Es por eso que es cuidadoso en calificar su comparación con el cambio climático, una fuerza que podría dañar irrevocablemente a la Tierra a menos que los humanos hagan cambios radicales en la próxima década.

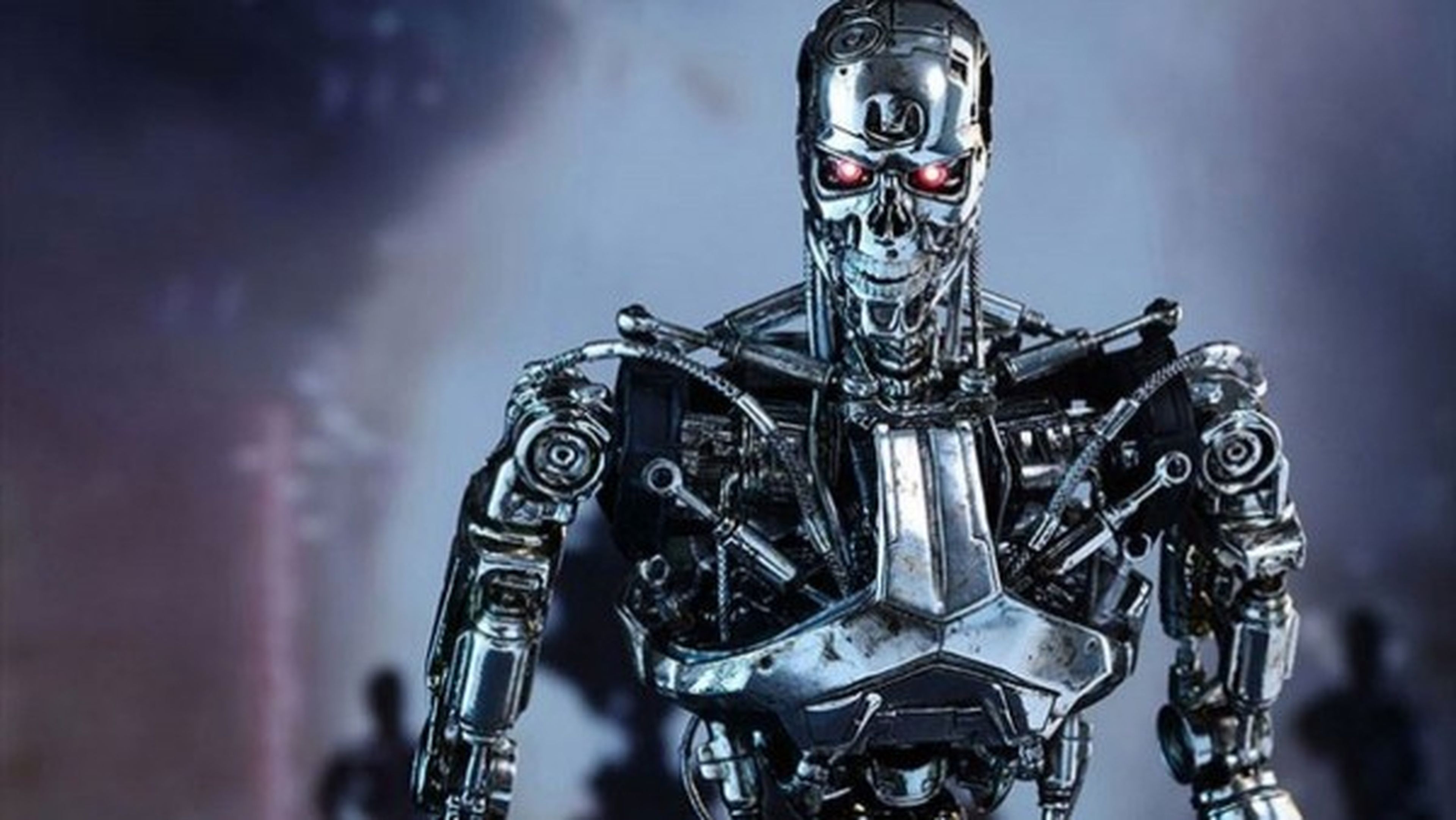

"La razón por la que la IA es a menudo representada como robots malvados en los medios de comunicación es porque es una buena historia. Los robots son más atractivos visualmente que un chip dentro de una caja negra; se pueden ver y sentir de una manera que no se puede con un chip", explica. "Pero la maldad no es el problema. Es la posibilidad de que las inteligencias artificiales sean indiferentes a las metas humanas."

Leer más: Robots con valores: los desafíos éticos de la Inteligencia Artificial

La IA puede ser indiferente a los objetivos de los humanos, y eso es peligroso

Todas las entidades inteligentes, ya sean humanas o artificiales, tienen metas, incluso si están preprogramadas. Para termómetros de IA muy simples, por ejemplo, el objetivo es medir con éxito la temperatura.

El temor de Bostrom es que si las inteligencias artificiales se vuelven lo suficientemente competentes en la búsqueda de sus objetivos, incluso aquellos que suenan inofensivos, pueden dañar a las personas sin darse cuenta.

En un artículo de 2003, Bostrom da el ejemplo de una IA cuyo único objetivo es maximizar la producción de clips de papel.

Si esta IA pudiera reprogramarse para mejorar su inteligencia -algo de lo que ya son capaces algunas IA desarrolladas por Google- podría llegar a ser tan inteligente que podría innovar en formas de maximizar el número de clips que produce. En algún momento, podría comenzar "transformando primero toda la tierra y luego aumentando porciones de espacio dedicadas a instalaciones de fabricación de clips", escribe Bostrom.

Si convertir el mundo en una máquina de clips de papel suena estúpido es porque no se alinea con los objetivos de los humanos. Pero la impresora de clips está siguiendo sus objetivos hasta una conclusión lógica.

Al volverse tan asombrosamente buena en hacer clips,podría terminar dañando a la gente. No se habría propuesto ser malvado, es indiferente a objetivos que van más allá de los suyos.

El ejemplo puede sonar descabellado, pero Bostrom dice que la indiferencia de la IA ante los esfuerzos de la humanidad podría ser ya una amenaza real.

"La mayor manera en que la IA puede tener un impacto negativo es en el papel de sistemas de información, como seleccionar noticias que confirmen los prejuicios de la gente o actuar como sistemas de vigilancia", explica.

Leer más: Deep Fakes: los usos más inquietantes de la Inteligencia Artificial

Ya están surgiendo problemas con estos últimos, lo que suscita interrogantes sobre si empresas como Amazon y Microsoft deberían estar vendiendo tecnología de reconocimiento facial a organismos públicos.

La American Civil Liberties Union dijo el pasado mes de mayo que Amazon había vendido su herramienta de reconocimiento a agencias gubernamentales y policiales con el propósito de vigilancia pública e identificar a "personas de interés". La ACLU también encontró el año pasado que Rekognition identificó incorrectamente a 28 miembros del Congreso como personas que habían sido arrestadas.

Para Bostrom, el gran desafío es mantener la IA bajo control y programarla para alinearla con los objetivos humanos.

"El primer desafío será técnico, como encontrar una forma de desarrollar la IA de manera controlada", dice. "Suponiendo que resolvamos eso, nuestros próximos objetivos son los retos sociales de crear un orden mundial que sirva al bien común."

La grandes tecnológicas está luchando para averiguar cómo hacer que la IA sea segura

Entonces, ¿cree Bostrom que las grandes empresas de tecnología se esfuerzan lo suficiente para desarrollar la IA de forma controlada? Google, Amazon, Facebook y Apple están a la vanguardia del desarrollo de la IA y, sin embargo, algunos académicos piensan que no están desarrollando una IA compatible con los objetivos humanos.

Bostrom cree que la gente con la que ha hablado en las grandes compañías de tecnología "se preocupa por hacer que la IA sea segura y compatible" con esos objetivos.

"También tengo la sensación de que no son capaces de averiguar cómo hacer esto", admite. "Es mucho esperar que cada compañía de tecnología cree su propio marco ético para controlar la IA."

Las empresas de tecnología están lidiando visiblemente con este problema. Google, por ejemplo, disolvió un comité de ética de la IAuna semana después de que miles de empleados hicieran campaña contra la inclusión de Kay Coles James, presidente de la Heritage Foundation, un think tank de derechas.

Pero si no se puede confiar en que las grandes empresas de tecnología creen marcos para desarrollar la IA de manera ética y segura, ¿quién puede hacerlo? ¿Qué hay de los gobiernos? De nuevo, Bostrom es escéptico.

"Todavía no hay muchas propuestas políticas claras sobre cómo deben intervenir los gobiernos", dice. "Ahora mismo, no está claro qué es lo que querríamos que hicieran los gobiernos. Tenemos que ampliar la conversación.

Se supone que el capitalismo funciona cuando los gobiernos crean las reglas de comportamiento y las compañías funcionan dentro de esas reglas", dice, pero "hay un desajuste cultural entre Silicon Valley y los gobiernos": Silicon Valley tiene una ética de inclinación libertaria, mientras que los gobiernos están por detrás y no son emprendedores".

Y añade: "Creo que será necesario que el gobierno cuente con más gente que entienda la IA, no necesariamente investigadores brillantes, sino gente con suficiente experiencia, especializados en informática. La capacidad de entender la IA viene en grados. A veces es mejor no ser demasiado especialista, porque si estás demasiado especializado, puedes tener una visión estrecha de las ramificaciones sociales más amplias de un campo".

Bostrom, sin embargo, cree que puede dar forma a la conversación en torno a la IA mientras permanece en el mundo académico. También afirma que los empleados activistas, como los de Google, están poniendo su parte para que sus empresas rindan cuentas.

"Hay cosas que los investigadores de la IA pueden hacer para influir en el comportamiento de las grandes empresas de tecnología sin tener que abandonar el mundo académico", dice. "También hay un grado de activismo público dentro de las comunidades de investigación de la IA, como el reciente levantamiento dentro de Google".

Este artículo fue publicado originalmente en BI Prime.

Conoce cómo trabajamos en BusinessInsider.

Etiquetas: BI PRIMETrending, Inteligencia artificial, Bill Gates, Cambio climático