Del porno a 'Juego de Tronos': cómo los deepfakes y los vídeos falsos están conquistando Internet (y por qué debería preocuparte)

- Los deepfakes, vídeos falsos manipulados con la ayuda de inteligencia artificial, tratan de engañarte al mostrarte que alguien hace o dice algo que en realidad nunca hizo. Y se han convertido en una tendencia al alza.

- En 2019, los deepfakes han agitado el mundo de la política, se han burlado del programa de televisión más popular del mundo y han hecho que algunos políticos estadounidenses o incluso el Pentágono pasen a la acción.

- Las manipulaciones son relativamente nuevas: aparecieron en 2017 en algunos hilos de usuarios en Reddit, casi siempre poniendo caras de famosas a vídeos pornográficos.

- Su rápido desarrollo desde la pornografía a la cultura popular ha hecho que los investigadores se esfuercen por mantenerse al día a la hora de crear un software que sea capaz de detectar las falsificaciones para evitar que los deepfakes se utilicen para difundir desinformación.

- Descubre más historias en Business Insider España.

Las deepfakes, vídeos que han sido manipulados para que parezca que el sujeto está diciendo o haciendo algo que en realidad no ha hecho, han entrado de lleno en la sociedad.

En lo que va de 2019 se han viralizado deepfakes que trataban de mostrar mensajes falsos del CEO de Facebook, Mark Zuckerberg, del personaje de Juego de Tronos Jon Snow o de importantes personajes políticos de Estados Unidos, como la presidenta de la Cámara de Representantes, Nancy Pelosi, o el presidente Donald Trump.

Eso ha hecho que algunos políticos e importantes investigadores, incluso del Pentágono, hayan pasado a la acción.

Los deepfakes parece que nacieron como un mero pasatiempo que, en poco tiempo, creció alrededor de la pornografía cuando los usuarios de ciertas comunidades online comenzaron a compartir vídeos en los que se intercambiaba los rostros de algunas famosas con los que aparecen en vídeos pornográficos.

Leer más: Deep Fakes: los usos más inquietantes de la Inteligencia Artificial

Ahora, después de esas advertencias que algunos ya avanzaron en 2017 sobre los potenciales peligros de los deepfakes, el escenario de pesadilla se ha convertido en una realidad: algunas de las personas más influyentes del mundo, y sus audiencias, se han convertido en la diana para los que se dedican a crear estas falsificaciones.

A continuación puedes entender cómo los deepfakes se han convertido en un fenómeno social y comprender qué es lo que realmente está en juego con estos vídeos falsos.

El término "deepfake" fue creado por un usuario de Reddit que afirma haber desarrollado un algoritmo de aprendizaje automático que le ayudó a intercambiar rostros de famosas en vídeos pornográficos.

Las "deepfakes", tal y como los conocemos, empezaron a llamar la atención en diciembre de 2017, después de que Samantha Cole de Vice publicara una pieza para Motherboard sobre el porno manipulado por la Inteligencia Artificial en la que aparecía la actriz Gal Gadot, de "Wonder Woman".

Los vídeos adquirieron ese nombre gracias a un usuario de Reddit —uno de los foros más populares de todo internet— llamado "deepfakes" que publicó una serie de vídeos falsos pornográficos de famosas que fue el tema principal de la pieza de Vice.

Los videos fueron significativos porque marcaron la primera vez en la que una sola persona era capaz de crear fácil y rápidamente vídeos falsos y convincentes de alta calidad.

Según Cole, que habló con el usuario deepfakes, utilizó "herramientas de código abierto para el aprendizaje automático como TensorFlow, que Google pone gratuitamente a disposición de investigadores, estudiantes de postgrado y cualquier persona interesada en el aprendizaje automático".

Los intentos de superponer famosas u otras caras al porno no era algo completamente nuevo, pero sí lo eran el modo, la velocidad y la aparente simplicidad del proceso. Según el investigador de IA Alex Champandard, que habló con Vice, el proceso de creación de un deepfake podría durar sólo unas horas con una tarjeta gráfica como la que muchos usuarios tienen en sus ordenadores.

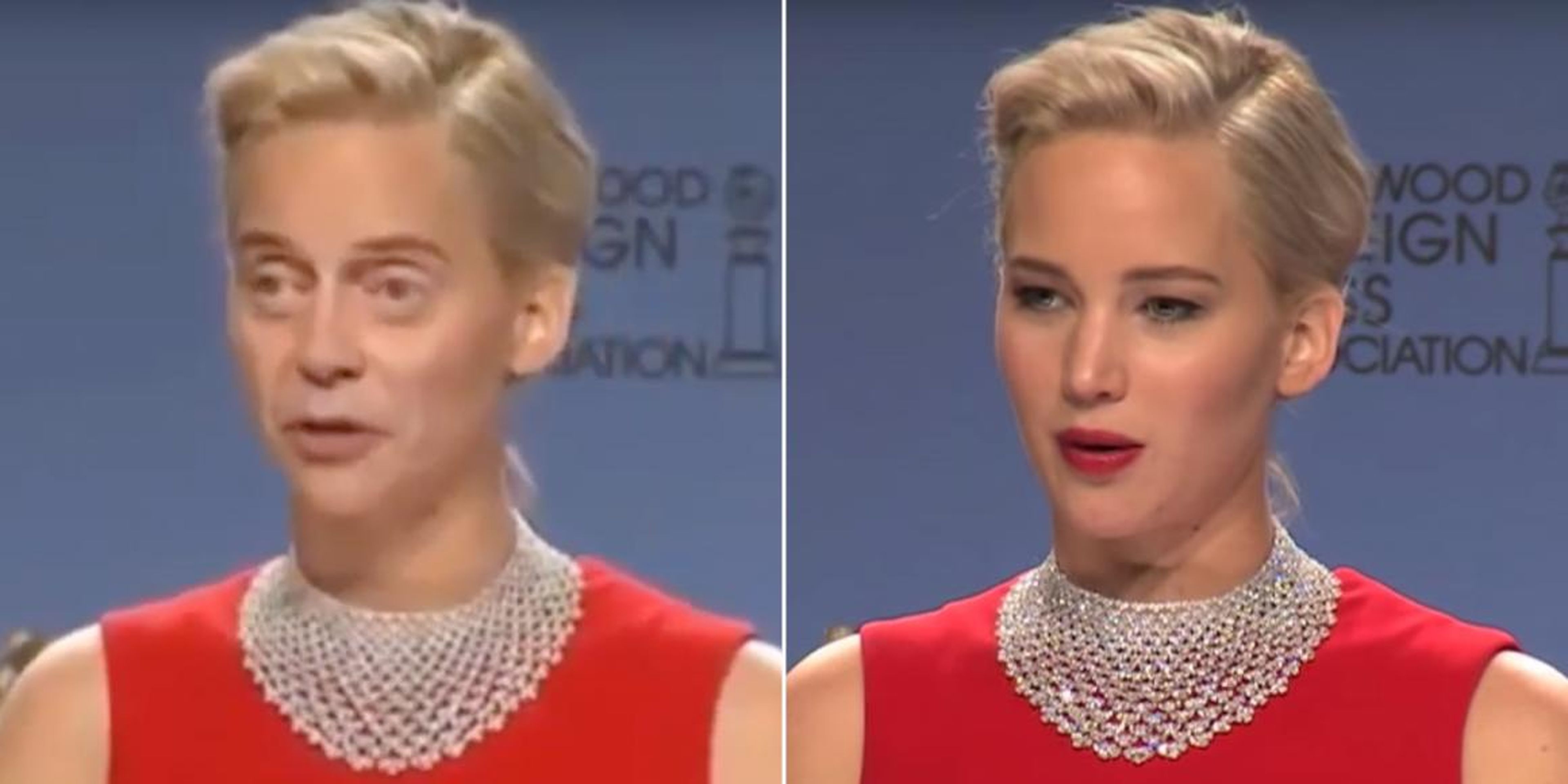

Los deepfakes también tienen el potencial de diferenciarse en el nivel de calidad frente a esfuerzos anteriores de intercambiar caras a otros cuerpos. Una buena falsificación, creada mediante Inteligencia Artificial que ha sido entrenada en horas de metraje, ha sido generada específicamente para su contexto, con movimientos de boca y cabeza sin fisuras y coloración apropiada. Simplemente superponer una cabeza a un cuerpo y animarlo a mano puede llevar a grandes desajustes de contexto muy evidentes para el ojo humano.

Inmediatamente, comenzaron las especulaciones y la preocupación sobre los posibles usos más amplios de la tecnología.

Los videos despertaron la preocupación sobre los posibles usos futuros de la tecnología y su ética.

Inmediatamente se planteó la cuestión del consentimiento. Más alarmante fue el potencial de chantaje y la aplicación de la tecnología para los que están en el poder.

En 2017, meses antes de que aparecieran los deepfakes pornográficos, un equipo de investigadores de la Universidad de Washington apareció en los titulares cuando publicaron un vídeo de Barack Obama, generado por ordenador, hablando a partir de viejos clips de audio o vídeo.

En ese momento, los riesgos en torno a la propagación de la desinformación eran claros, pero parecían muy lejanos, dado que se trataba de investigadores académicos que estaban produciendo esos vídeos.

Las creaciones a nivel de usuario añadieron una alarmante urgencia a los riesgos en cuestión.

En enero de 2018, se lanzó una aplicación de escritorio de creación de deepfakes llamada FakeApp, que permitía crear esos vídeos falsos a casi cualquier. En Reddit incluso se creó un hilo con docenas de vídeos de este tipo.

En enero de 2018, poco después de que aparecieran los deepfakes pornográficos, FakeApp, una aplicación de escritorio para la creación de falsificaciones, estuvo disponible para su descarga. El software había sido vendido originalmente por un usuario llamado deepfakeapp en Reddit y usaba el framework TensorFlow de Google, la misma herramienta utilizada por el usuario de Reddit deepfakes.

La tecnología disponible fácilmente ayudó a impulsar el subreddit dedicado a los deepfakes que surgió tras el artículo original sobre las falsificaciones en Vice.

Aquellos que usaron el software, que estaba enlazado y explicado en el subreddit, compartieron sus propias creaciones y comentaron sobre otras. La mayor parte era pornografía, pero otros videos eran más ligeros, con escenas de películas al azar en los que la cara del actor se cambió por la de Nicholas Cage.

Las plataformas empezaron a prohibir explícitamente las deepfakes después de que Vice informara sobre el porno de venganza creado con la tecnología.

A finales de enero de 2018, Vice publicó otro artículo que identificaba casos de deepfakes hechas con las caras de personas que la gente supuestamente conocía de la escuela secundaria u otros lugares, y posiblemente como venganza pornográfica.

La pornografía parecía estar en un área gris de leyes pornográficas de venganza, dado que los vídeos no eran grabaciones reales de personas reales.s.

Los mensajes identificados se encontraron en Reddit y en la aplicación de chat Discord.

Tras la revelación, numerosas plataformas como Twitter, Discord, Gfycat y Pornhub prohibieron explícitamente los deepfakes y las comunidades asociadas. Gfycat, en particular, anunció que estaba utilizando métodos de detección de la Inteligencia Artificial en un intento de vigilar proactivamente las deepfakes.

Reddit esperó hasta febrero de 2018 para prohibir los deepfakes y actualizar sus políticas para prohibir ampliamente las falsificaciones pornográficas.

En abril de 2018, BuzzFeed llegó a su conclusión lógica creando un video de Barack Obama diciendo palabras que no eran suyas.

En abril de 2018, BuzzFeed publicó un vídeo falso de Barack Obama espantosamente realista que se convirtió en viral y que había sido encargado previamente. A diferencia del video de la Universidad de Washington, a Obama se le atribuyeron palabras que no eran suyas.

El vídeo fue hecho por una sola persona que usaba FakeApp, lo que supuestamente tomó 56 horas para tener un modelo de Obama. Aunque era transparente en cuanto a que se trataba de un deepfake, constituyó un serio aviso del peligroso potencial de la tecnología.

En el último año, varios videos manipulados de políticos y otros individuos conocidos se han vuelto virales, destacando los peligros continuos de los deepfakes, y forzando a las grandes plataformas a tomar una posición sobre la tecnología.

Después del perturbador y realista deepfake de Obama, los casos de vídeos manipulados de personajes públicos comenzaron a volverse virales, y aparentemente engañaron a millones de personas.

A pesar de que la mayoría de los vídeos son aún más vulgares que los deepfakes, utilizando una edición de películas rudimentaria en lugar de IA, los vídeos iniciaron una preocupación constante por el poder de los deepfakes y otras formas de manipulación de vídeo, al tiempo que obligaban a las empresas de tecnología a adoptar una postura sobre qué hacer con ese contenido.

En julio de 2018, más de un millón de personas vieron un video editado de una entrevista a Alexandria Ocasio-Cortez que la hizo aparecer como si no tuviera respuestas a numerosas preguntas.

En julio de 2018, un vídeo editado de una entrevista con Alexandria Ocasio-Cortez se hizo viral. Ahora tiene más de 4 millones de visitas.

El vídeo, que corta la entrevista original y coloca a un presentador diferente, hace que parezca como si Ocasio-Cortez tuviera dificultades para responder a ciertas preguntas básicas. El vídeo desdibujó la línea entre la sátira y algo que podría ser un sincero esfuerzo por difamar a Ocasio-Cortez.

Según The Verge, los comentaristas respondieron con afirmaciones como, "completamente imbécil" y "tonta como una caja de serpientes", lo que hace que no quede claro cuánta gente fue engañada en realidad.

Aunque no es un deepfake, el video aumentó la preocupación en torno a la desinformación que pueden generar este tipo de vídeos.

En mayo de 2019, un video ralentizado de Nancy Pelosi recibió millones de visitas e inspiró la especulación en línea de que estaba borracha. Facebook se negó públicamente a eliminarlo.

En mayo de 2019, un video de la presidenta demócrata de la Cámara de Representantes, Nancy Pelosi, se difundió en Facebook y Twitter. El vídeo se ralentizó para hacerla aparecer como si estuviera difuminando su habla, e inspiró a muchos a cuestionar el estado mental de Pelosi.

El video, aunque no es un deepfak, ha sido una de las manipulaciones de vídeo más efectivas que han atacado a políticos de primer nivel, atrayendo más de 2 millones de visitas y engañando claramente a muchos comentaristas.

El peligro viral de la manipulación de vídeos estaba a la vista cuando el abogado personal de Trump, Rudy Giuliani, compartió el vídeo, antes de que Trump tuiteara otro vídeo editado de Pelosi.

Leer más: Deep Fakes: los usos más inquietantes de la Inteligencia Artificial

A pesar de que el vídeo era falso, Facebook se negó públicamente a eliminarlo y, en lugar de ello, lanzó la responsabilidad a los encargados de comprobar los hechos que sólo podían producir la información que aparecía junto al vídeo. En respuesta, Pelosi atacó a Facebook, diciendo que "a sabiendas eran cómplices y facilitadores de información falsa ".

El video ha desaparecido de Facebook, pero Facebook sostiene que no lo borró.

En junio de 2019, un deepfake de Mark Zuckerberg apareció en Instagram. Facebook también decidió mantenerlo, sentando un precedente para dejar videos manipulados en sus plataformas.

Poco después de la polémica de Pelosi, apareció en Instagram un deepfake de Mark Zuckerberg, en un vídeo de CBSN que nunca se grabó realmente, en el que Zuckerberg parece estar diciendo: "Imagínense esto por un segundo: Un hombre, con control total de miles de millones de datos robados de la gente, todos sus secretos, sus vidas, sus futuros. Se lo debo todo a Spectre. Spectre me mostró que quien controla los datos, controla el futuro". Spectre fue una exposición de arte en la que se presentaron varias falsificaciones hechas por el artista Bill Posters y una compañía de publicidad. Los carteles dicen que el vídeo era una crítica a la tecnología.

A pesar de una demanda de marca registrada por CBSN, Facebook se negó a quitar el video, diciendo a Vice: "Trataremos este contenido de la misma manera que tratamos toda la desinformación en Instagram. Si terceras partes lo marcan como falso, lo ocultamos en los algoritmos de recomendación de Instagram como las páginas Explorar y hashtag".

Más tarde, varios verificadores de Facebook marcaron el vídeo como falso, lo que redujo su difusión. En respuesta, el artista que hizo el video criticó la decisión, diciendo: "¿Cómo podemos hacer una exploración seria y debatir sobre estos temas tan importantes si no podemos usar el arte para interrogar críticamente a los gigantes de la tecnología?"

En septiembre de 2018, varios políticos estadounidenses pidieron al Director de Inteligencia Nacional que informara sobre la amenaza de los deepfakes tras la decisión del Pentágono de financiar la investigación de la tecnología de detección de deepfakes.

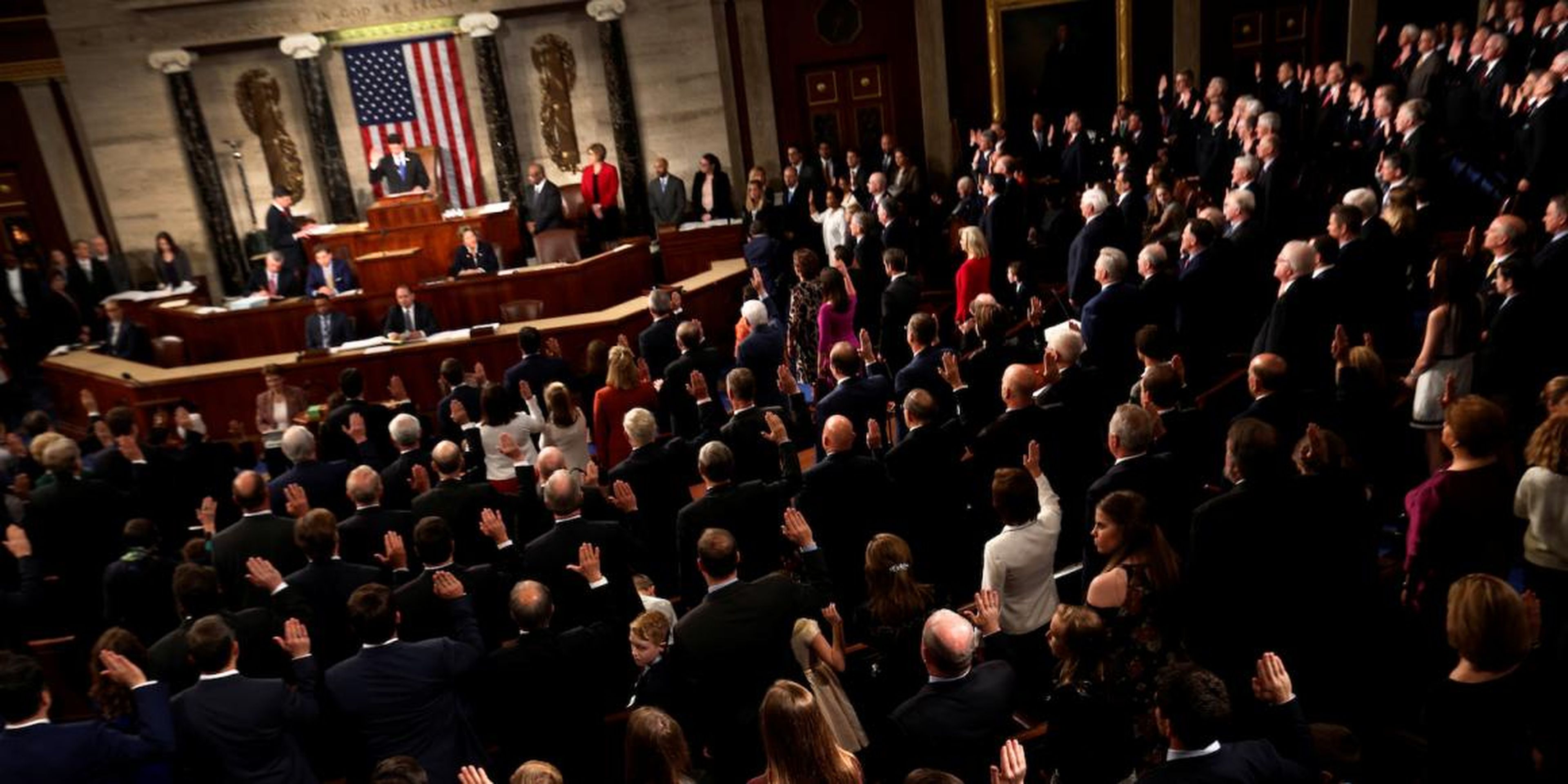

En septiembre de 2018, varios políticos estadounidenses pidieron al Director de Inteligencia Nacional que "informara al Congreso y al público sobre las implicaciones de las nuevas tecnologías que permiten a los actores maliciosos fabricar audio, vídeo e imágenes fijas".

Específicamente, los representantes plantearon las posibles amenazas de chantaje y desinformación, pidiendo un informe para diciembre de 2018.

Anteriormente, numerosos senadores habían mencionado los deepfakes en audiencias con Facebook e incluso audiencias de confirmación.

La Agencia de Proyectos de Investigación Avanzada de Defensa del Pentágono (DARPA) comenzó a financiar la investigación de tecnologías que podrían detectar la manipulación de fotos y vídeos en 2016. Al parecer, los deepfakes se convirtieron en un área de interés en 2018.

En junio de 2019, la Cámara de Representantes de los Estados Unidos tuvo una sesión sobre los deepfakes.

En una sesión del Comité de Inteligencia de la Cámara de Representantes en junio de 2019, los legisladores finalmente escucharon testimonios oficiales sobre los deepfakes y se comprometieron a examinar "las amenazas a la seguridad nacional que plantea el contenido falso facilitado por la Inteligencia Artificial, lo que se puede hacer para detectarlo y combatirlo y el papel que el sector público, el sector privado y el conjunto de la sociedad deberían desempeñar para contrarrestar un futuro potencialmente sombrío y posterior a la verdad".

En la vista, Adam Schiff, del Partido Demócrata, instó a las empresas de tecnología a "poner en marcha políticas para proteger a los usuarios de la desinformación" antes de las elecciones de 2020.

Los resultados de los ensayos para prevenir los deepfakes han sido variados.

Las plataformas que han tenido que lidiar con deepfakes junto con el Pentágono han estado trabajando en tecnología para detectar y eliminar los deepfakes, pero los resultados han sido variados.

En junio de 2018, una investigación de Vice descubrió que los deepfakes seguían alojadas en Gfycat a pesar de su tecnología de detección. Gfycat supuestamente eliminó los deepfakes que fueron marcadas por Vice pero permanecieron activos después de que volvieran a ser subidos en un experimento hecho por la periodista Samantha Cole.

Pornhub también ha sufrido a la hora de eliminar estos vídeos. En el momento de escribir este artículo, el primer resultado de una simple búsqueda en Google de "deepfakes en pornhub" apunta a una lista de reproducción de 23 vídeos pornográficos de estilo deepfake alojados en Pornhub que muestra las caras superpuestas de Nicki Minaj, Scarlett Johansson y Ann Coulter en vídeos explícitos. Pornhub ha respondido inmediatamente a la petición de comentarios al respecto de estos vídeos.

Leer más: Este es el verdadero aspecto de 40 famosas sin maquillaje

Las tecnologías que se han desarrollado específicamente para detectar deepfakes son engañosas, según los expertos. Siwei Lyu, de la Universidad Estatal de Nueva York en Albany, dijo a MIT Tech Review que la tecnología desarrollada por su equipo (financiada por DARPA) podría reconocer las deepfakes detectando la falta de parpadeos en los ojos en los videos manipulados, porque a menudo los parpadeos no se incluyen en este tipo de vídeos. Lyu explicó que lo más probable es que la tecnología se vuelva inútil si se incluyen imágenes de figuras parpadeantes cuando se entrena a la IA.

Otros equipos que trabajan a partir de la iniciativa de DARPA están utilizando pistas similares, como los movimientos de la cabeza para intentar detectar deepfakes, pero cada vez que se revela el funcionamiento interno de la tecnología de detección, los falsificadores ganan otro punto de apoyo para evitar la detección.

Los deepfakes varían en calidad e intención, lo que hace que el futuro sea difícil de predecir.

A pesar de la seriedad de las recientes manipulaciones de vídeo y de las falsificaciones profesionales, la práctica está creciendo.

Un reciente deepfake —claramente identificable como una manipulación— de Jon Snow disculpándose por la última temporada de "Juego de Tronos", ilustra la expansión y los potenciales usos de este tipo de vídeos.

La tecnología, aunque representa una amenaza en múltiples frentes, también puede ser utilizada legítimamente para la sátira, la comedia, el arte y la crítica.

El enigma se desarrollará a medida que las plataformas continúen lidiando con cuestiones de consentimiento, libertad de expresión y prevención de la difusión de información errónea.

Conoce cómo trabajamos en BusinessInsider.

Etiquetas: TrendingVídeo, Juego de Tronos, Celebrities, Listas