La transparencia en IA generativa es crucial para regularla y un nuevo índice suspende en ello a prácticamente todas, desde OpenAI a Google

Getty

- A la hora de regular la IA, la transparencia de sus sistemas —con qué datos se entrenan, cómo funcionan— es un aspecto clave.

- Un nuevo índice de la Universidad de Stanford suspende a prácticamente todas las desarrolladoras de IA generativa. La mayor nota es un 5,4 sobre 10.

Los sistemas de inteligencia artificial deben ser transparentes para que los usuarios puedan confiar en ellos. Lo dicen expertos, colectivos de la sociedad civil y desde hace menos tiempo legisladores, al menos en la Unión Europea donde se está negociando el nuevo Reglamento de la IA.

Esa necesidad también existe en los modelos de IA generativas, que además, para poder crear imágenes, audios o textos, han sido entrenados con ingentes cantidades de datos, en muchos casos recopilados de la red sin permiso y llegando a vulnerar derechos de autor. De ahí que haya artistas plásticos denunciando desde hace meses que esta tecnología les ha robado su trabajo.

El tamaño de sus bases de datos, de dónde la han sacado, hasta qué punto el modelo es público y accesible en repositorios de código. Todos los aspectos se analizan para determinar si un modelo funciona y para poder auditar si tiene algún sesgo implícito que pueda vulnerabilizar o perjudicar a alguno de sus usuarios.

Pero, por clave que sea, un nuevo estudio de la Universidad de Stanford revela que todas las desarrolladoras de IA generativa tienen mucho trabajo por delante a la hora de hacer más transparentes y accesibles sus desarrollos.

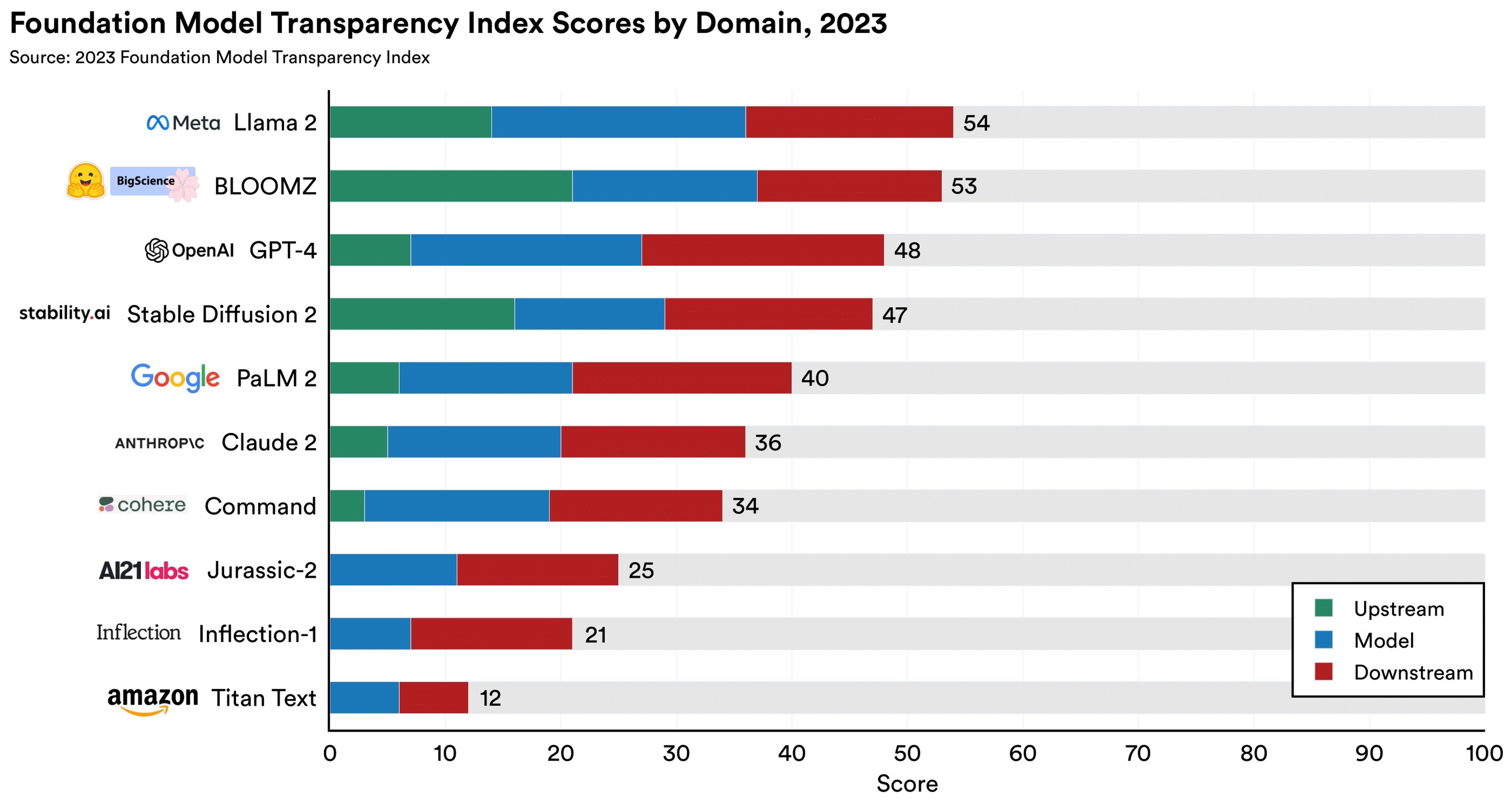

Lo revela el nuevo Índice de Transparencia de Modelos Fundacionales que han publicado varios investigadores de la Universidad de Stanford, del Massachusetts Institute of Technology (MIT) y de la Universidad de Princeton. De 10 desarrolladoras de IA generativa analizadas, solo aprueban 2... y están lejos de hacerlo con nota.

Universidad de Stanford

Para hacer esta particular clasificación, los autores del índice se han detenido en 3 aspectos distintos: aquella información que se puede interpretar como ascendente al flujo de datos o previa a los procesos algorítmicos, como con qué datos de entrenamiento cuenta, tamaño de su base de datos, etc.

La segunda es los aspectos relacionados con lo que sucede después de ese proceso algorítmico: aquí se tiene en cuenta si el modelo revela qué peticiones ha recibido de gobiernos, si permite a los usuarios dar feedback de los resultados del modelo, si se ha compartido cuál es la licencia del modelo, si sus términos y condiciones son accesibles para los usuarios...

El tercer factor es el que evalúa la información disponible sobre el modelo en sí mismo: si tiene evaluación de riesgos, descripción detallada de sus capacidades y de sus limitaciones, si es auditable o ha sido auditado por terceros, etc.

Los 3 modelos de IA generativas peor puntuados solo han cosechado 25, 21 y 12 puntos sobre 100. Se tratan de Jurassic-2, un modelo de procesamiento de lenguaje natural desarrollado por una compañía israelí, Inflection-1, otro modelo de texto californiano, y Titan Text, el modelo de texto en el que está trabajando Amazon.

Estas 3 IA generativas no han cosechado ningún punto en el factor de evaluación ascendente, es decir, no han compartido apenas ningún detalle sobre cómo han entrenado sus modelos.

Amazon está a la cola de la tabla. Sin embargo, la misma la encabeza otra gran tecnológica. Meta, con su Llama 2, es uno de los 2 modelos que para Stanford merece el aprobado. El desarrollo de la propietaria de Facebook, eso sí, solo ha obtenido 54 puntos sobre 100.

Detrás está BLOOMZ y en tercer lugar aparece OpenAI con su GPT-4, que suspende por décimas: obtiene 48 puntos de 100. Detrás de GPT-4 está Stable Diffusion 2 con 47 puntos, el PaLM 2 de Google con 40, Claude 2 con 36 y Command con 34.

Los autores de este nuevo índice llaman la atención en que el estudio se ha llevado a cabo sobre 10 modelos fundacionales —sinónimo de IA generativa— y se han tenido en cuenta unos 100 indicadores distribuidos en las 3 categorías antes mencionadas.

La puntuación media ha sido de 37 puntos sobre 100, con lo que "los desarrolladores pueden mejorar significativamente la transparencia de sus modelos adoptando las mejores prácticas de sus competidores". El estudio también pone de relieve en que los modelos abiertos —que no de código abierto— lideran la tabla.

Otros artículos interesantes:

Descubre más sobre Alberto R. Aguiar, autor/a de este artículo.

Conoce cómo trabajamos en Business Insider.