Esprint de reuniones en Bruselas por el Reglamento de la IA: por qué el nuevo artículo 6 de la norma no convence a expertos en tecnología y derechos

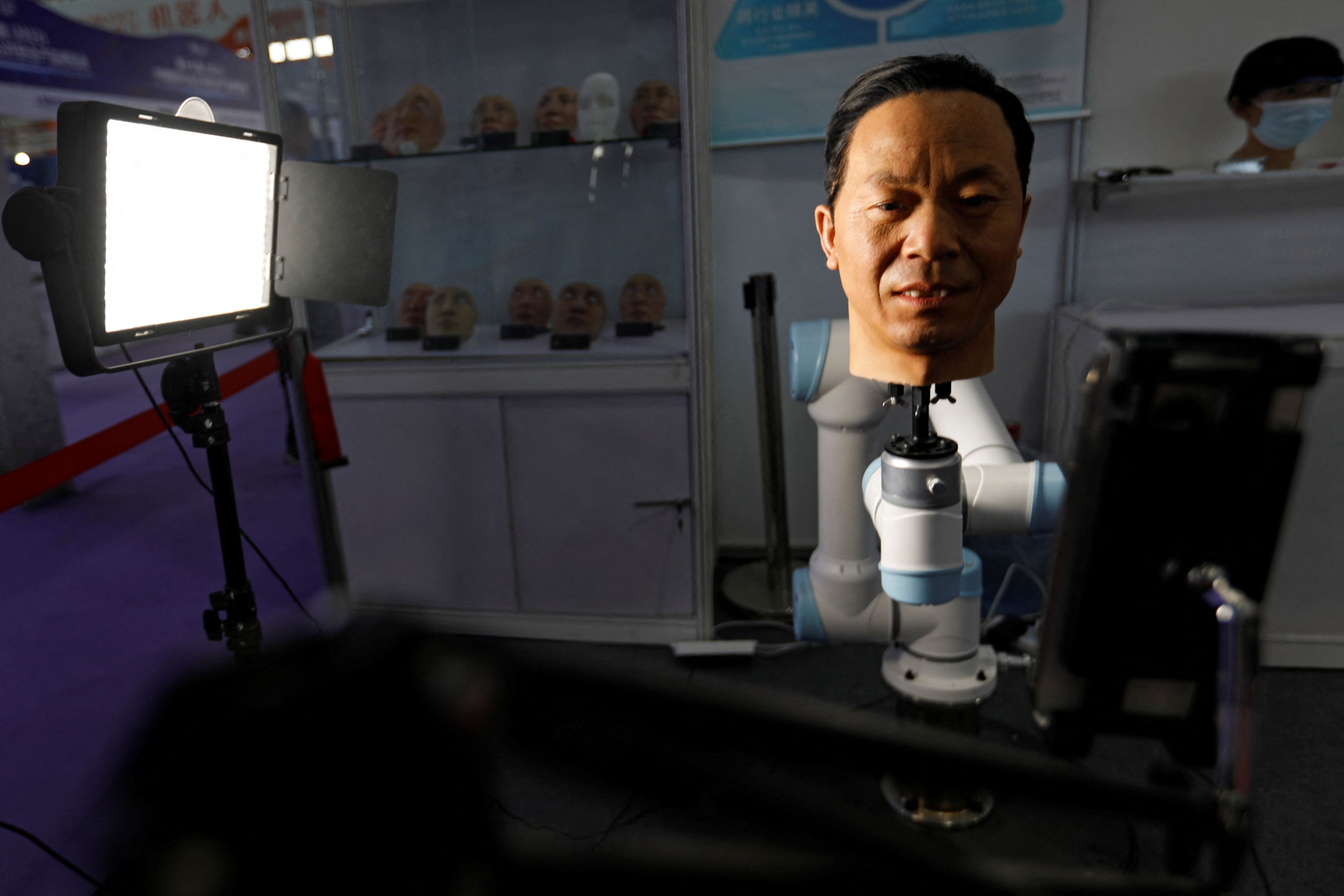

REUTERS/Florence Lo

- Desde principios de mes se han convocado varias reuniones técnicas con la vista puesta en las negociaciones del Reglamento de la IA, que se reanudan el día 25.

- Las negociaciones son secretas, pero las filtraciones han revelado un sustancial cambio en el artículo 6 de la norma que preocupa a muchos colectivos sociales.

Las imágenes de los líderes europeos paseando por la Alhambra de Granada ya es una de las instantáneas con las que el Gobierno podrá defender que la Presidencia Española del Consejo de la Unión Europea fue memorable.

La otra imagen que el Ejecutivo en funciones espera conseguir es la luz verde al futuro Reglamento de la Inteligencia Artificial. La Comisión presentó el borrador de esta norma en abril de 2021. Ahora ya está en fase de trílogos, las reuniones entre la misma Comisión, el Parlamento Europeo y el propio Consejo para tratar de alcanzar un consenso sobre un texto definitivo.

Cuando Bruselas propuso este reglamento europeo nadie sabía qué era una inteligencia artificial generativa o un modelo fundacional. ChatGPT tardaría meses en aparecer y ni siquiera se habían popularizado las herramientas generadoras de imágenes como DALL-E o Stable Diffusion.

El texto, en su borrador inicial, se centraba en los riesgos que determinados modelos de IA podían representar para la ciudadanía. Desde sistemas de reconocimiento facial a algoritmos de toma de decisiones: modelos, en definitiva, que pueden tener sesgos raciales, de género o clase y en consecuencia, si no son auditados antes de su despliegue, pueden ser discriminatorios.

Durante su desarrollo legislativo se han escuchado todo tipo de opiniones sobre la redacción del reglamento. Se trata de una de las primeras regulaciones integrales que se preparan en todo el planeta, con lo que está suscitando mucho interés tanto dentro como fuera de la Unión Europea.

Y también polémica.

Hace días varios colectivos de la sociedad civil levantaron la voz en España al entender que el Ejecutivo en funciones podía estar haciendo mucho más para involucrar a la población en las negociaciones en torno al reglamento que se están manteniendo en trílogo. Esas negociaciones son secretas, pero los últimos retoques al texto que se han conocido están levantando ampollas.

Esos colectivos publicaron una carta abierta dirigida especialmente a la secretaria de Estado de Digitalización e IA en funciones, Carme Artigas, así como a la vicepresidenta y ministra de Asuntos Económicos en funciones, Nadia Calviño. La primera recogió el guante en una publicación en X (antes Twitter) en la que reivindicaba de qué manera se estaba contando con la sociedad civil.

Apenas unas horas antes, la coalición electoral Sumar presentó una pregunta en el Congreso que el Gobierno tendrá que responder por escrito. Las cuestiones que formulaban las diputadas Tesh Sidi y Gala Pin tenían precisamente que ver con el papel que el Gobierno de Pedro Sánchez estaba adoptando al negociar el texto del Reglamento de la IA con el Parlamento y la Comisión.

El Reglamento de la IA europeo que podría ver la luz antes de que termine el año no será la única regulación que se tenga en España sobre esta tecnología. A expensas de que se pueda tener en cuenta o tramitar siquiera, Sumar también presentó hace días una proposición de ley que ponía el foco en los deepfakes y en la necesidad de contar con la sociedad civil al regular la IA.

Entre tanto, a cada poco que se producen avances en los trílogos sobre el futuro reglamento europeo más avanza la polémica. A nivel comunitario también docenas de asociaciones y organizaciones en defensa de los derechos digitales están haciendo valer su voz en lo que entienden como un posible retroceso en cuanto a la ambición de la futura norma.

Las negociaciones son secretas, sí, pero esto es todo lo que se sabe sobre los últimos y polémicos cambios alrededor del futuro Reglamento de la IA.

La clave de todo está en el artículo 6 del futuro Reglamento de la IA

Buena parte de la polémica se concentra en el segundo apartado del artículo 6.

El artículo 6 del Reglamento de la IA estipula cuándo un sistema se considera de alto riesgo y, en consecuencia, queda sujeto a una serie de condiciones o limitaciones a la hora de comercializarse o desplegarse.

Pero una cosa era lo que proponía en un principio la Comisión Europea y otra muy distinta es cómo será el texto definitivo una vez el Consejo, el Parlamento y la propia Comisión alcancen un acuerdo.

En ese proceso legislativo ha jugado su debido rol la industria tecnológica. Sin ir más lejos, en junio la revista Time reveló en exclusiva cómo OpenAI, propietaria de los modelos de lenguaje extenso GPT y por tanto dueña de ChatGPT, había hecho lobby en la Unión Europea para tratar de descafeinar el futuro reglamento.

A pesar de que Sam Altman, su CEO y fundador, realizó este mismo año una gira en distintos países europeos —también pasó por Madrid— a favor de regular la inteligencia artificial, entre bambalinas su compañía también maniobró para que el texto legal definitivo no sea pernicioso para su negocio. Centró sus esfuerzos, precisamente, en la consideración de sistemas de alto riesgo.

Altman, a través de los especialistas de su compañía, estuvo en contacto con los técnicos de la Comisión Europea. "Por sí mismo, GPT-3 no es un sistema de alto riesgo, pero [posee] capacidades que pueden emplearse en casos prácticos de alto riesgo", aducía OpenAI en una misiva a la que accedió Time y que recibieron funcionarios del Consejo y la Comisión.

En septiembre, Politico reveló en Morning Tech, una de sus newsletters, que las últimas negociaciones estarían alterando el tenor del artículo 6 del texto. En el segundo apartado de dicho artículo se detallaba que se considerarían sistemas IA de alto riesgo aquellos que apareciesen reflejados en el anexo 3 de la norma.

En ese anexo aparecen sistemas de identificación biométrica, gestores de tráfico, algoritmos para evaluar o contratar y despedir trabajadores, modelos para determinar si una persona puede acceder a una ayuda o subvención pública, herramientas de control migratorio como "polígrafos", entre otros.

Si el apartado segundo del artículo 6 decía literalmente que se considerarían sistemas de IA de alto riesgo "los sistemas IA que figuran en el anexo III", un documento con sello de la Comisión a la que accedió Politico a finales del mes pasado abría la puerta a una nueva redacción: esos modelos no se considerarían de alto riesgo si cumplían una serie de excepciones.

"Los sistemas IA referidos en el anexo III serán considerados de alto riesgo a no ser que su trabajo sea puramente accesorio respecto a las acciones o decisiones relevantes que tomen, y no impliquen un riesgo significativo para la salud, la seguridad o los derechos fundamentales". Esta sería la nueva redacción del artículo 6.2, que ordenaría además a la Comisión actuar.

Una reforma que favorecería a las grandes tecnológicas

Si prospera esta propuesta, la Comisión tendrá que, en un plazo "no mayor a un año" desde que entre en vigor el Reglamento de la IA, determinar las circunstancias con las que se podrá determinar si el trabajo de un sistema de inteligencia artificial es "accesorio" o no al modelo en el que esté actuando.

¿Y qué sería determinante para valorar si un sistema IA es o no es accesorio? La palabra de sus propios desarrolladores. Al menos así lo entienden y denuncian desde el mes pasado cerca de 120 asociaciones expertas en tecnología y libertades de toda Europa, que suscribieron un manifiesto conjunto liderado por la European Digital Rights (EDRi).

"Si los cambios en el artículo 6 del reglamento no se revierten, la Ley de IA permitirá a los desarrolladores de inteligencia artificial decidir por sí mismo quedarse al margen de las sustanciosas reglas que deben cumplir los modelos de alto riesgo", lamentan en el escrito los distintos colectivos firmantes.

De esta manera, el esperado Reglamento de la IA introduciría "incertidumbre legal", "fragmentaría el mercado único europeo" al permitir "distintas interpretaciones de lo que se considera IA de alto riesgo en los distintos países miembros", un mayor desafío a las autoridades nacionales de IA y permitiría a "desarrolladores sin escrúpulos" esquivar los objetivos de la regulación.

Además de la EDRi, entidades como StateWatch, Defend Democracy, el Chaos Computer Club alemán o las comunidades españolas de Algorights, AlgoRace o Eticas han rubricado ese manifiesto que se dio a conocer a principios de septiembre. El debate, además, ha llegado a España, por ser el país que está presidiendo desde este verano el Consejo de la Unión Europea.

Aquí, hace escasos días los colectivos que forman parte de la coalición IA Ciudadana elevaron un nuevo comunicado, este dirigido con énfasis al Gobierno de España —a la vicepresidenta de Asuntos Económicos en funciones, Nadia Calviño, y a su secretaria de Estado de Digitalización en funciones, Carme Artigas—.

En el escrito, las organizaciones firmantes —AlgoRace, Algorights, Lafede.cat, entre otras— instabna al Ejecutivo a ser más transparente y a compartir qué postura están negociando desde el Consejo de la Unión Europea en las reuniones sobre el Reglamento de la IA.

La propia Artigas reaccionó en redes sociales, asegurando que la voz de la sociedad civil se estaba teniendo en cuenta en el diseño de la regulación de la IA, pero sus argumentos no convencieron a Algorights que insistió en sus dudas e hizo especial énfasis en las reuniones que España está liderando por presidir el Consejo.

La otra polémica, la IA de código abierto

El agujero con el que las grandes tecnológicas podrían escapar de la consideración de alto riesgo no es el único problema que adolecería el Reglamento de IA todavía siendo un borrador. Andrés Torrubia, cofundador del Instituto de Inteligencia Artificial, advertía a las puertas del verano de los desafíos que prevé la ley para el movimiento open source.

Básicamente, la norma, tal y como se conocía antes de que comenzaran los trílogos, no cuenta con excepciones para herramientas de código abierto.

"En muchos aspectos el último borrador equipara los modelos fundacionales (que sirven de base para todo) con sistemas de alto riesgo, y aunque se distribuyan en "abierto" o gratis, multas de millones de euros si no pasas por procesos de certificación costosos o "sandbox". Personalmente, lo veo disuasorio", escribía el experto entonces en redes sociales.

"Donde más o menos dice "a la hora de poner multas miraremos con buenos ojos a las pymes" yo solo veo cifras de millones de euros y que si te ponen la multa, para una startup con financiación en fase crecimiento eso es sentencia de muerte". "Cuando se presentó el primer borrador se esperaba una ley robusta: salió ChatGPT y se ha tenido que modificar para incluirlo", advertía.

A finales de julio, un manifiesto compartido por varias empresas y organizaciones se sumaba a esas críticas. "El reglamento podría perjudicar el desarrollo de la IA de código abierto y, por lo tanto, podría socavar sus objetivos de promover la innovación responsable en línea con valores europeos", advertía Peter Cihon, responsable de Política en GitHub.

Curiosamente, el último reproche ha llegado también desde el otro lado del Atlántico. Hace escasos días Bloomberg accedió a documentos del Gobierno estadounidense en los que se advertía a la Unión Europea de que su propuesta de reglamento favorecería a aquellas empresas con los suficientes recursos como para cubrir los costes que implicará su cumplimiento.

En resumidas cuentas: EEUU piensa que el esperado Reglamento de la IA que cocina Bruselas solo va a ayudar a las grandes tecnológicas.

Próxima parada: 25 de octubre

Con todos estos mimbres continúan las negociaciones en trílogo entre Consejo, Comisión y Parlamento Europeo. La Eurocámara ya aprobó una resolución hace meses instando a combatir, por ejemplo, los sistemas de reconocimiento biométrico —y facial— en espacios públicos. Ese caso de uso de IA es el paradigma al que buscaba en un principio dar respuesta esta regulación.

Para multitud de organizaciones, que no se revierta los cambios introducidos en el artículo 6 del Reglamento de la IA podría hacer que incluso esa pretensión inicial acabe siefndo papel mojado.

Las negociaciones, secretas, continúan su curso. El primer trílogo tuvo lugar en junio. El segundo, en julio. El tercero, a comienzos de este mes. Y es probable que se conozcan nuevos detalles del Reglamento de la IA, incluso que se alcance un acuerdo, el próximo 25 de octubre.

Desde el día 6 de octubre hasta ese día 25 se seguirán celebrando reuniones técnicas con objeto de desbloquear las negociaciones y, en consecuencia, el texto definitivo. Un texto que corre el riesgo, para muchos expertos, de acabar sirviendo para favorecer a las grandes tecnológicas en el ámbito de la inteligencia artificial.

Otros artículos interesantes:

Descubre más sobre Alberto R. Aguiar, autor/a de este artículo.

Conoce cómo trabajamos en Business Insider.