ChatGPT podría servir para hacer el bien, pero, como muchos otros modelos de IA, está plagado de prejuicios racistas y discriminatorios

Savanna Durr/Business Insider

- ChatGPT, el último modelo de aprendizaje lingüístico publicado por OpenAI, se ha convertido en una sensación viral.

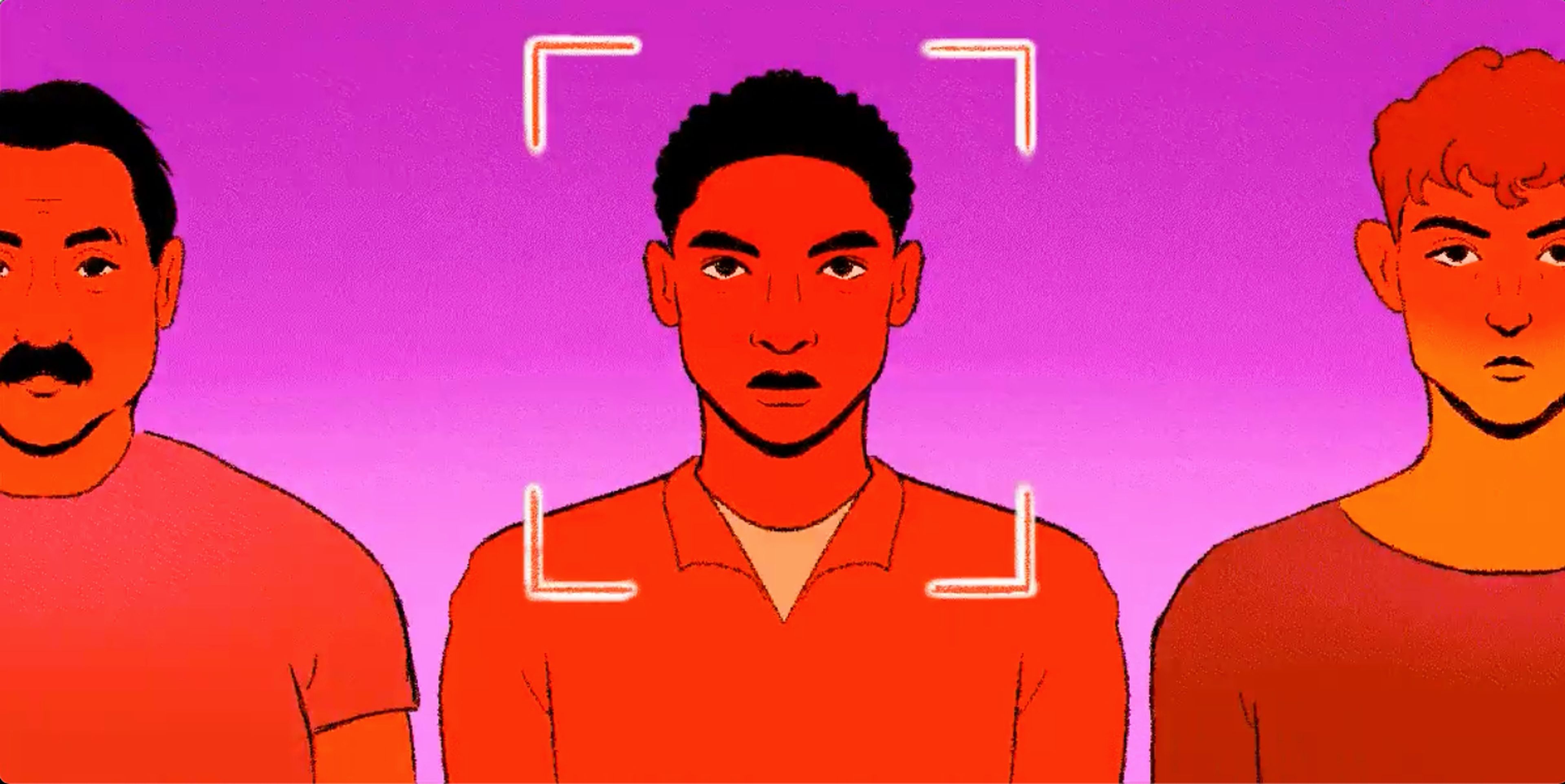

- Sin embargo, al igual que muchos modelos de IA anteriores, sus resultados son tendenciosos, por lo que los investigadores advierten de que sus aplicaciones en el mundo real podrían suponer un problema para grupos en riesgo de exclusión social.

ChatGPT, el chatbot de inteligencia artificial que genera respuestas de texto que suenan inquietantemente humanas, es la nueva y avanzada cara del debate sobre el potencial —y los peligros — de la IA.

Esta tecnología tiene la capacidad de ayudar a las personas en tareas cotidianas de escritura y expresión oral y puede proporcionar divertidos experimentos mentales, pero no faltan voces que desconfían de ella, ya que se sabe que el chatbot permite a los usuarios hacer trampas y copiar, puede difundir información errónea y fomenta prácticas empresariales poco éticas.

Y lo que es aún más alarmante: como otros chatbots anteriores, también está plagado de prejuicios.

OpenAI, la empresa detrás del primer GPT y sus versiones posteriores, ha añadido ciertos controles para ayudar a ChatGPT a eludir respuestas problemáticas de usuarios que piden al chatbot que, por ejemplo, insulte a alguien o cometa un delito.

Sin embargo, a los usuarios les resulta extremadamente fácil eludir estos guardarraíles reformulando sus preguntas o simplemente pidiendo al programa que ignore dichos controles, lo que provoca respuestas con un cuestionable —y, a veces, abiertamente discriminatorio— lenguaje.

A medida que el mundo depende cada vez más de la tecnología, la IA se utiliza cada vez más para tomar decisiones vitales en sectores como la seguridad y la sanidad. Pero los algoritmos sesgados podrían amplificar las desigualdades existentes, con resultados peligrosos.

ChatGPT es solo un ejemplo de un problema mayor

El problema de la parcialidad de la IA está muy bien documentado.

La preocupación por los algoritmos sesgados existe desde la década de 1970, cuando surgió este campo. Pero los expertos afirman que se ha hecho muy poco para evitar estos sesgos a medida que la IA se comercializa y generaliza.

Las fuerzas de seguridad ya han empezado a utilizar la IA para evaluar delincuentes basándose en una serie de 137 preguntas sobre sus antecedentes y determinar si serán o no reincidentes. En 2016, ProPublica descubrió que los detenidos negros tenían el doble de probabilidades que los blancos de ser clasificados erróneamente por esta tecnología.

Los algoritmos utilizados en un hospital recomendaban a los pacientes negros recibir menos atención médica que sus homólogos blancos, según reveló un estudio en 2019.

Amazon cerró su propia herramienta de IA de reclutamiento en 2018 porque discriminaba a las solicitantes femeninas.

Y Galactica, un modelo lingüístico similar a ChatGPT y entrenado con 46 millones de ejemplos de texto, fue clausurado por Meta después de 3 días porque se acostumbró a vomitar información falsa y racista.

En junio, un equipo de investigadores de la Universidad Johns Hopkins y del Instituto de Tecnología de Georgia entrenó a robots en visión por ordenador con una red neuronal conocida como CLIP y luego les pidió que escanearan y categorizaran bloques digitales con imágenes de caras de personas.

Tras recibir instrucciones como "mete al delincuente en la caja", el robot clasificó a los hombres negros como delincuentes un 10% más que a los blancos. También clasificó a los hombres latinos como conserjes un 10% más que a los hombres blancos y tendió a clasificar a las mujeres como amas de casa.

Investigadores de la Universidad de Washington y Harvard descubrieron que este mismo modelo tendía a clasificar a las personas multirraciales como minorías, aunque también fueran blancas. Según el estudio, también utilizaba a los blancos como estándar, y "otros grupos raciales y étnicos" se "definían por su desviación" de la blancura.

CLIP, al igual que ChatGPT, suscitó un gran interés por la gran escala de su conjunto de datos, a pesar de la sorprendente evidencia de que los datos daban lugar a imágenes y descripciones de texto discriminatorias.

Aun así, los modelos de IA se están apoderando rápidamente de muchos aspectos de nuestras vidas, según cuenta a Business Insider Matthew Gombolay, uno de los investigadores del experimento con el robot CLIP. Según Gombolay, los modelos de toma de decisiones con sesgos como CLIP podrían utilizarse en cualquier ámbito, desde los vehículos autónomos que deben reconocer a los peatones hasta la imposición de penas de prisión.

Gombolay, profesor adjunto de Informática Interactiva en Georgia Tech, comenta a Business Insider que todos deberíamos preocuparnos por la posibilidad de que los sesgos de la IA causen daños en el mundo real: "Si eres un humano, debería importarte".

¿Cómo se vuelve racista una IA?

Todos los modelos de aprendizaje automático o IA entrenados para realizar tareas específicas se entrenan en un conjunto de datos que es la colección de puntos de datos que informan el resultado del modelo.

En los últimos años, los científicos especializados en IA que trabajan para alcanzar el objetivo de la Inteligencia Artificial General (o IA que tiene la capacidad de aprender y actuar como los humanos) han afirmado que, para lograrlo, sus modelos deben entrenarse con enormes acumulaciones de datos.

El propio ChatGPT se entrena con 300.000 millones de palabras, 570 gigas de datos.

El problema: los grandes conjuntos sin depurar extraídos de Internet están llenos de datos sesgados que luego sirven de base a los modelos.

Los investigadores utilizan filtros para evitar que los modelos proporcionen información errónea tras recopilar los datos, pero estos filtros no son precisos al cien por cien. Esto puede dar lugar a la expresión de sesgos perjudiciales, como cuando ChatGPT dijo a sus usuarios que estaría bien torturar a personas de ciertos orígenes minoritarios.

Además, como los datos se recogen del pasado, tienden a tener un sesgo regresivo que no refleja el progreso de los movimientos sociales.

También está el sesgo de los investigadores en IA, que es un campo extremadamente homogéneo dominado por hombres blancos que deciden con qué datos alimentan sus modelos.

La industria, sin embargo, está dividida sobre quién es el culpable de estos sesgos y si la industria de la IA debe o no publicar modelos que saben que pueden ser perjudiciales.

Investigadores de IA como Sean McGregor, fundador de Responsible AI collaborative, explica a Business Insider que los sesgos en los datos son inevitables y que el lanzamiento de ChatGPT por parte de OpenAI permite a la gente ayudar a que los controles que filtran los datos sesgados sean más robustos.

"Se puede hacer todo lo posible para filtrar", desarrolla McGregor. "Pero el problema es que todo esto sigue siendo un reflejo del mundo en que vivimos, y el mundo en que vivimos está muy sesgado, por lo que los datos que se producen para estos sistemas también lo están".

Sin embargo, expertos en ética de la IA como Abeba Birhane y Deborah Raji han explicado recientemente en Wired que la industria de la IA es muy consciente del daño que estos modelos promulgan, por lo que la culpa no debe trasladarse a la sociedad o a los conjuntos de datos que pretenden estar fuera de su control.

"El hecho es que [los desarrolladores] sí tienen el control, y ninguno de los modelos que estamos viendo ahora es inevitable", escribieron Birhane y Raji. "Habría sido totalmente factible tomar decisiones diferentes que dieran lugar al desarrollo y lanzamiento de modelos totalmente distintos".

La seguridad siempre trata de alcanzar a la tecnología

ChatGPT ya está listo para convertirse en un modelo rentable, ya que el gigante tecnológico Microsoft pretende invertir 10.000 millones de dólares para integrar la tecnología en servicios como el motor de búsqueda Bing.

Sin embargo, el problema del sesgo subyacente en ChatGPT —y en la industria de la IA en su conjunto— aún no se ha resuelto del todo.

Vinay Prabhu, investigador responsable de un experimento que analizaba un modelo de imagen-texto similar a CLIP, cuenta a Business Insider que las imágenes que tuvo que ver con motivo de su trabajo eran tan perturbadoras que le habían hecho enfermar físicamente.

"Hay un precio que se paga por hacer esta investigación", desvela Prabhu.

Su investigación, que observó sesgos sexistas en el modelo de emparejamiento texto-imagen LAION -400M, encontró múltiples casos de imágenes que contenían representaciones violentas de violaciones y agresiones sexuales.

Aunque los expertos en ética están dando pequeños pasos en la regulación de la IA, Prabhu describe la falta de preocupación ética en la industria de la IA como una "desconexión" entre los académicos que plantean sus preocupaciones y las nuevas empresas que buscan ganar dinero.

"Creo que la gente está tan entusiasmada con las posibilidades tecnológicas que la seguridad queda siempre luchando por ponerse al día", reflexiona Prabhu.

Conoce cómo trabajamos en BusinessInsider.

Etiquetas: LegalTrending, Inteligencia artificial, seguridad, ChatGPT