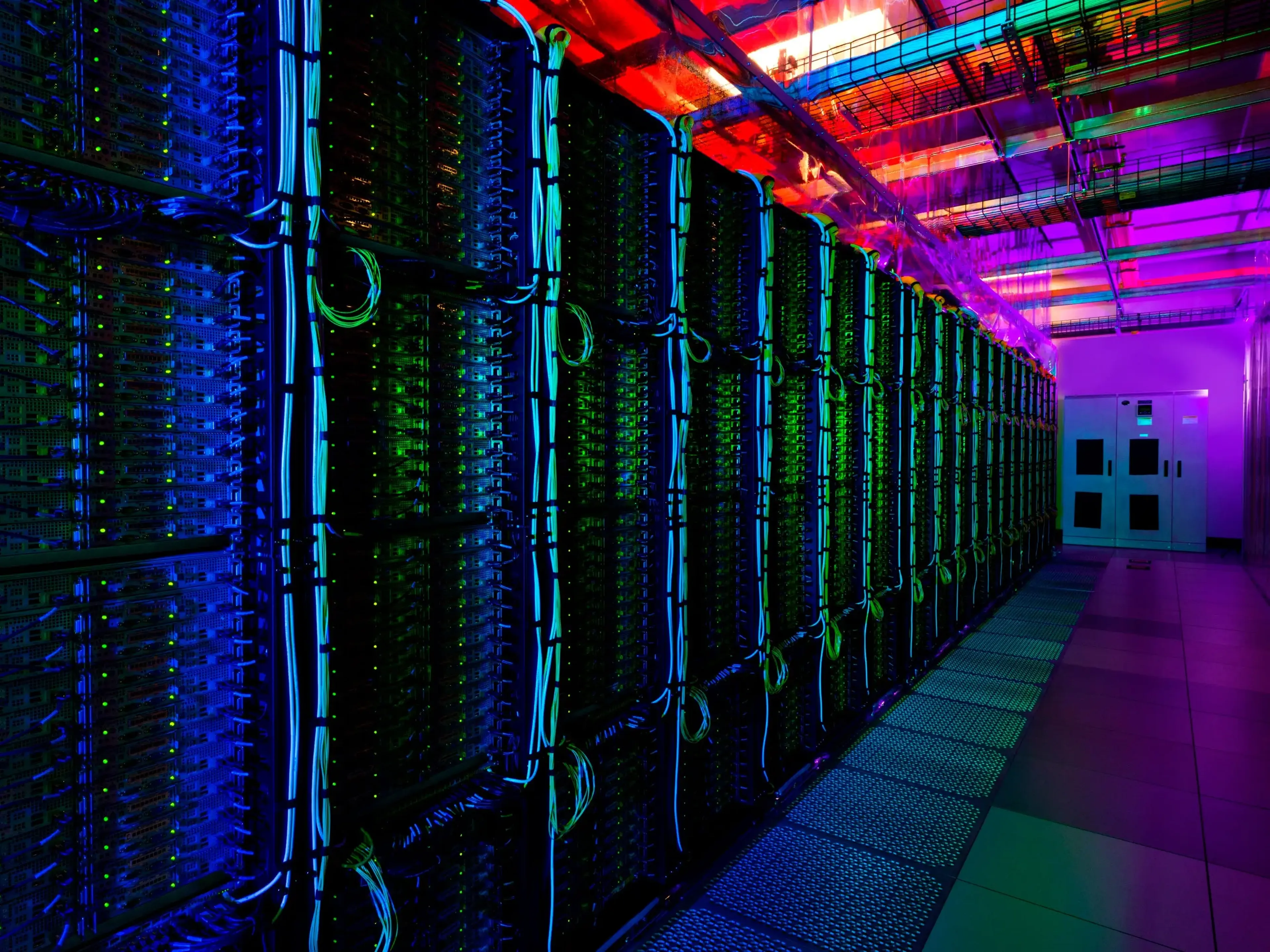

La nube consume ingentes cantidades de energía y la IA generativa será aún peor: ni siquiera los centros de datos están preparados para la nueva era

Reuters

- El entrenamiento de modelos de inteligencia artificial en centros de datos consume hasta 3 veces más energía que las tareas habituales de computación en la nube.

- La mayoría de los centros de datos actuales no cuentan con la infraestructura necesaria para gestionar este aumento de la demanda y la próxima generación de este tipo de instalaciones podría suponer un importante consumo de recursos.

El año pasado, el Data Center Alley estuvo a punto de quedarse sin energía. Se trata de una instalación al norte del estado de Virginia que alberga el mayor número de centros de datos de Estados Unidos y la distribuidora local, Dominion Energy, advirtió de que tal vez no iba a ser capaz de satisfacer la creciente demanda.

Esto ocurrió antes incluso de que se produjese el boom de la inteligencia artificial que ha provocado la llegada de ChatGPT, un nuevo consumo que podría duplicar o triplicar la cantidad de energía necesaria para los centros de datos. Lo que está por venir podría hacer que la caída que sufrió Dominion Energy parezca un paseo por el parque, según ejecutivos, investigadores y analistas del sector.

Los principales proveedores de cloud computing, como Amazon, Microsoft o Google, se esfuerzan por satisfacer la demanda de IA generativa, y el acceso a la energía podría llegar a ser incluso más importante que el diseño de nuevos modelos o la potencia de cálculo. Lo que está claro es que los centros de datos actuales no están preparados para soportar esta nueva revolución tecnológica.

"Es asombroso", afirma Marc Ganzi, CEO de DigitalBridge, una firma de inversión que posee y gestiona centros de datos, redes de fibra y otras infraestructuras tecnológicas. "No estoy seguro de cómo lo estamos haciendo".

Para el año 2030, se espera que los centros de datos alcancen los 35 gigavatios anuales de consumo eléctrico, frente a los 17 gigavatios del año pasado, según un estudio de McKinsey. Otro informe reciente, en este caso de Cowen, estimaba que los centros de datos de inteligencia artificial podrían necesitar hasta 5 veces más potencia que la de las instalaciones tradicionales.

La inminente competencia por los recursos energéticos

Tanto la industria tecnológica como la sociedad en su conjunto no están preparadas para esta nueva oleada de uso intensivo de la energía. Ya hay indicios de un futuro inquietante en el que las grandes tecnológicas diseñarán modelos de IA que afectarán a las empresas y dejarán a la gente sin trabajo, a la par que competirán entre ellas por los recursos y aumentarán sus facturas energéticas.

A principios de este año, el fabricante de armas Nammo aseguró que no podía ampliar una de sus fábricas porque un centro de datos que estaba siendo utilizado por TikTok estaba consumiendo toda la energía disponible en la región, según recogió el Financial Times.

Esto podría ser "un anticipo de lo que está por venir, conforme los centros de datos que dan soporte a las mentes pensantes detrás de las máquinas de imprimir dinero compiten con otras grandes industrias por la electricidad", ha adelantado Jack Clark, cofundador de una startup de inteligencia artificial respaldada por Google, Anthropic, en una newsletter del sector.

AP Photo/Matthew Barakat

El entrenamiento de modelos de IA consume mucha energía porque requiere del uso de tarjetas gráficas (GPU, por sus siglas en inglés). Estos chips especializados realizan mejor las multitareas y trabajan más rápido que las unidades centrales de procesamiento, o CPU, que ejecutan la mayoría de los servicios tradicionales en la nube.

Los servidores de inteligencia artificial que se instalan en los centros de datos suelen estar equipados con varias GPU, normalmente suministradas por Nvidia. Cada GPU consume hasta unos 400 vatios de energía, por lo que un servidor de IA puede consumir 2 kilovatios.

Un servidor cloud normal consume entre 300 y 500 vatios, apunta Shaolei Ren, un investigador de la Universidad de California, Riverside que ha estudiado cómo utilizan sus recursos los modelos avanzados de inteligencia artificial.

Por ejemplo, el consumo de energía del nuevo clúster de servidores GH200 de Nvidia es entre 2 y 4 veces mayor al de un clúster normal del mismo tamaño físico, según las estimaciones de Ren.

Una advertencia de un veterano que trabajó en los centros de datos de Microsoft

Microsoft

Tom Keane ha supervisado los centros de datos de los servicios de computación en la nube de Microsoft durante casi 20 años y ahora ha realizado una advertencia sobre este asunto. Microsoft es el principal impulsor de OpenAI, la desarrolladora de ChatGPT y la responsable de los modelos de IA más potentes que existen en la actualidad.

"En el caso de un centro de datos de entrenamiento, lo haces lo más grande posible, pones allí tantos ordenadores como sea posible y estás ejecutando ese centro a pleno rendimiento todo el tiempo", ha explicado Keane en una entrevista con Mark Moerdler, analista de Bernstein. "[Pero] tú empiezas a diseñar un centro de datos de IA de manera muy distinta".

Un centro de datos de inteligencia artificial va a necesitar hasta 3 veces más energía que una instalación cloud tradicional, ha argumentado el experto en la materia. Una instalación normal podría tener 30 kilovatios alimentando un rack de servidores en la nube, mientras que una nueva versión de IA necesitaría como mínimo 100 kilovatios.

"Todo empieza a cambiar cuando se piensa en lo que representa la inteligencia artificial", ha señalado Keane, que abandonó la firma de Redmond el año pasado, aproximadamente un mes después de que un artículo de Business Insider revelase que había abusado verbalmente de algunos empleados. En ese momento, Keane no respondió a la petición de declaraciones por parte de este medio de comunicación.

Una oportunidad "inmensa"

El aumento de la demanda de IA y los cambios que se avecinan suponen una oportunidad para inversores como Ganzi, el CEO de DigitalBridge: "Inmensa sería quedarse corto".

Este año, DigitalBridge se ha centrado en la construcción y actualización de centros de datos para manejar cargas de trabajo de inteligencia artificial generativa, con una inversión de casi 8.000 millones de dólares —unos 7.100 millones de euros— que tiene la intención de satisfacer esta nueva demanda, ha asegurado Ganzi a Business Insider.

Una diferencia clave entre los centros de datos tradicionales y las nuevas instalaciones de IA es cómo se consume la energía. Los centros de datos cloud están diseñados para gestionar una demanda variable: cuando todo el mundo está trabajando y transmitiendo vídeos, estas instalaciones están ocupadas; y, cuando cae la noche y la mayoría de la gente duerme, el uso disminuye.

En cambio, los centros de datos de inteligencia artificial están funcionando constantemente, sobre todo cuando se entrenan grandes modelos lingüísticos como aquellos con los que trabaja ChatGPT. Eso exige un mayor acceso a la energía y a la capacidad de mantenerla de forma constante.

"El centro de datos del futuro no está en Virginia"

Para compañías como DigitalBridge, eso implica salir de los principales mercados de centros de datos del mundo para construir una nueva generación de instalaciones que impulsen el auge de la IA.

En DataBank, un proveedor de centros de datos respaldado por DigitalBridge, Ganzi está instalando instalaciones más pequeñas en los suburbios de "ciudades de nivel 2 y 3", donde la red eléctrica está establecida pero no sometida a la presión de las actuales cargas de trabajo de la computación en la nube, que consumen mucha energía.

La proximidad con respecto a zonas urbanas más pequeñas implica una mayor densidad de potencia, lo que implica una conexión más rápida. Las ciudades más pequeñas también suponen menores costes de energía para el operador del centro de datos. Las ubicaciones ideales para los futuros centros de datos estarán en zonas de bajo coste, apunta Cowen.

"El centro de datos del futuro no estará en Virginia, ni en Santa Clara, ni en Dallas (Texas)", afirma Ganzi. "Esos son los principales mercados ahora mismo, y hay una limitación de la cantidad de energía que se puede obtener en esos mercados".

Conoce cómo trabajamos en BusinessInsider.

Etiquetas: BI PRIMETrending, Inteligencia artificial, sostenibilidad, Energía, ChatGPT