El último avance inquietante en IA: Nvidia crea una tecnología que genera animaciones faciales hiperrealistas a partir de archivos de audio

Nvidia

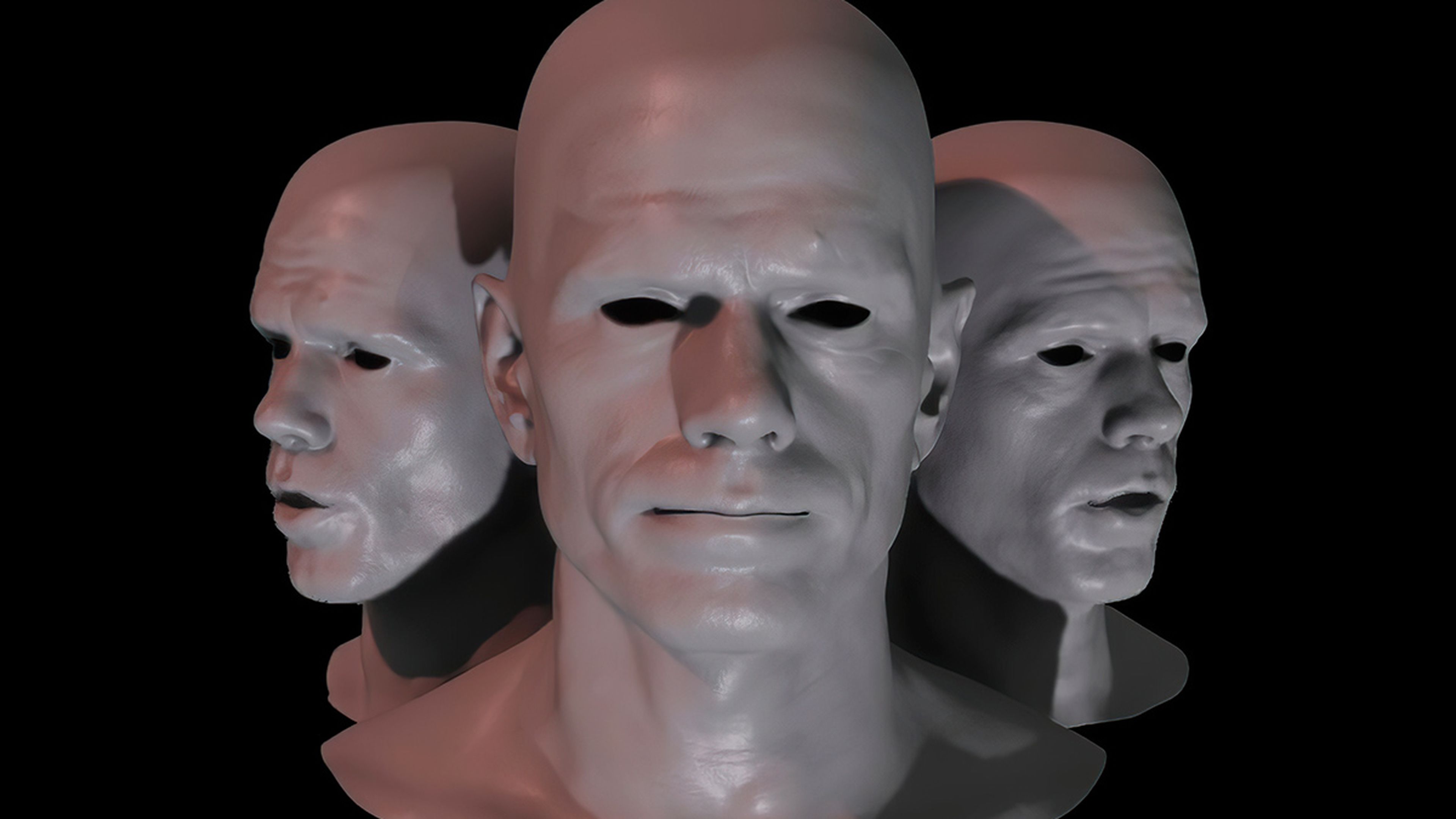

- La tecnología 'Audio2Face' de Nvidia utiliza IA para generar animaciones faciales que sincronizan la boca con el sonido de los archivos de audio.

- Nvidia ha implementado una red neuronal que hace coincidir las animaciones faciales con el audio en tiempo real.

- Descubre más historias en Business Insider España.

El desarrollo de videojuegos es un proceso increíblemente caro y que consume mucho tiempo, y gran parte de las reservas de liquidez de las compañías suelen consumirlas los presupuestos de arte y animación.

Es la tendencia para mejorar y dinamizar aún más los procesos. La animación facial, en particular, es fundamental para los títulos con escenas pesadas.

Esa es la razón por la última gran apuesta de Nvidia. La compañía está trabajando en una herramienta basada en inteligencia artificial que puede leer archivos de audio y crear animaciones faciales coincidentes en tiempo real.

Esta tecnología se conoce como 'Audio2Face' y lleva ya varios meses en versión beta. Hasta hace muy poco parecía no recibir especial atención, pese a sus revolucionarias implicaciones para los desarrolladores de videojuegos o, en general, para los animadores. Pero ahora ha recibido los focos y tiene grandes miradas encima.

No obstante, como cabe esperar de cualquier tecnología que esté impulsada por la IA y que aún esté en versión beta, Audio2Face no es perfecto. La calidad del audio de origen tendrá un gran impacto en la calidad de la sincronización de los labios en la tecnología, y no parece tener mucha precisión en la captura de las emociones faciales. Al menos, de momento.

Independientemente de la frase que se introduzca en el carácter predeterminado de 'marca digital' de Audio2Face, los ojos, las mejillas, los oídos y la nariz permanecen bastante estáticos. Hay algo de movimiento, pero, generalmente inferior al de las animaciones de los labios, que son claramente el foco principal.

Nvidia ha implementado una red neuronal que hace coincidir las animaciones faciales con el audio en tiempo real. Cuando se inicia el programa por primera vez, puede que lleve un momento sincronizar el motor Tensor RT que optimizara la red neuronal para nuestro hardware.

No obstante, esto quizás pueda ser positivo algo bueno. El hecho de transmitir emociones precisas frente a un personaje en 3D es para lo que los expertos en animación se entrenan durante años.

Dependiendo de lo fácil que sea implementar esta herramienta en el flujo de trabajo de un desarrollador determinado, podría proporcionar animaciones útiles, quizás marcadores de posición, de sincronización de labios, al tiempo que permite que los animadores se centren en otras partes del rostro de un personaje, según informa Techspot.

Algunos de los aficionados a Cyberpunk 2077, pueden recordar que el título de CDPR usaba una tecnología similar llamada 'JALI'.

Esta tecnología se nutrió de la IA para sincronizar automáticamente los diálogos en todos los principales idiomas compatibles del juego (aquellos con subtítulos y actuaciones de voz), lo que le una gran carga de trabajo a los animadores.

Audio2Face no tiene esa capacidad, pero sigue pareciendo útil.

Otros artículos interesantes:

Descubre más sobre Héctor Chamizo, autor/a de este artículo.

Conoce cómo trabajamos en Business Insider.