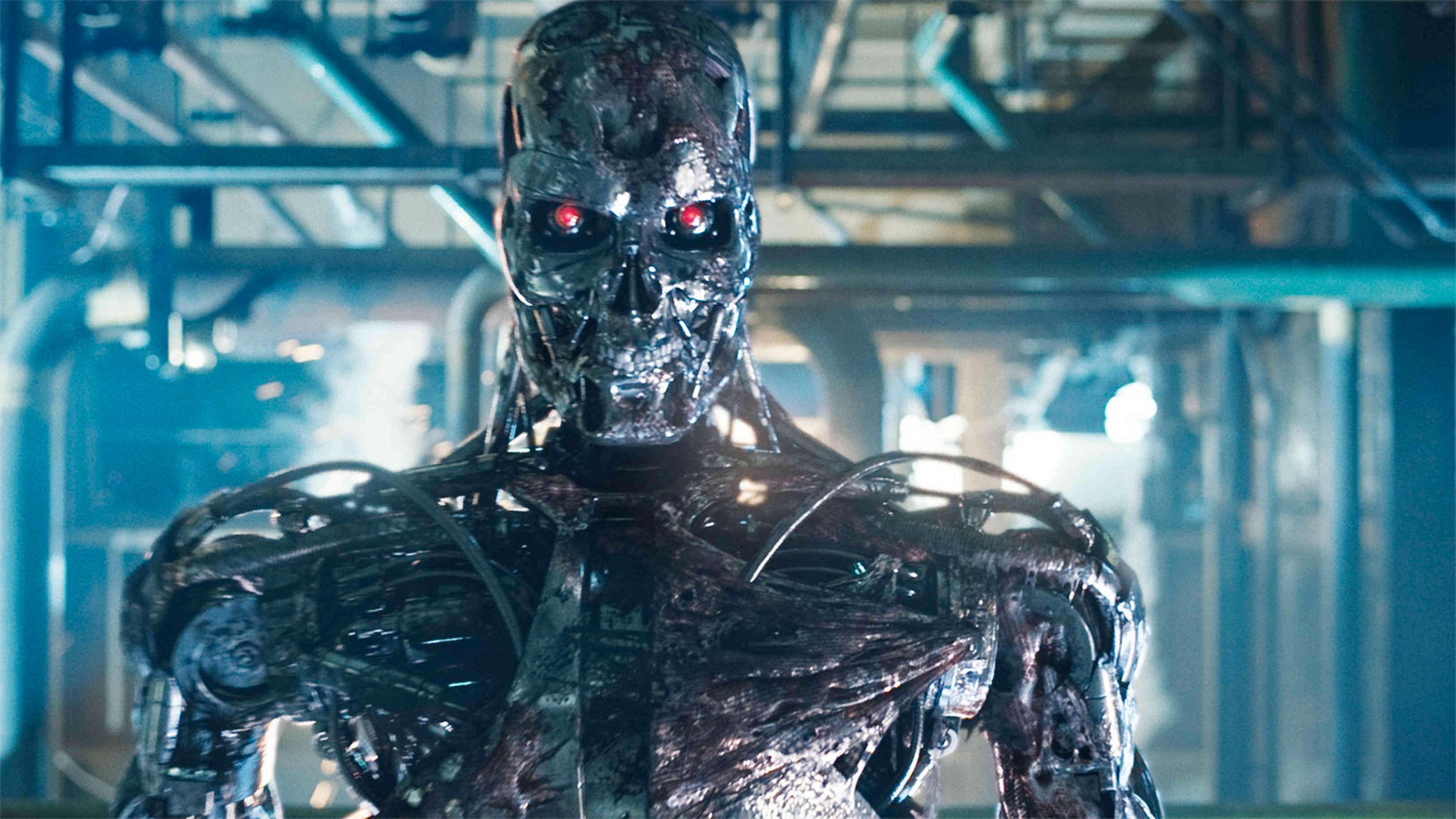

La guerra en Ucrania intensifica el desarrollo de robots asesinos

- El Departamento de Defensa de EEUU ha confirmado recientemente en una nota que la guerra en Ucrania está sirviendo para aprender más sobre IA de uso militar.

- La información contrasta con los esfuerzos que ha habido en las últimas semanas entre la comunidad internacional por regular su uso.

La guerra en Ucrania está enseñando a las máquinas a matar. Al menos, esto es lo que señalan los expertos y lo que se desprende de una nota publicada a finales del pasado mes de enero por el Departamento de Defensa de EEUU.

Esta confirma que el ejército estadounidense está siguiendo un plan articulado por la OTAN en octubre cuyo objetivo es preservar la "ventaja tecnológica" de la alianza en lo que a veces se denominan "robots asesinos".

Entre estos destacan, explica The Conversation en un artículo que aborda la cuestión, unos robots tripulados que son un cruce entre una bomba y un avión no tripulado. Estos pueden flotar durante largos periodos de tiempo a la espera de un objetivo y, por el momento, son manejados casi siempre por un humano que es quien decide el objetivo.

Google rectifica y promete que su inteligencia artificial no se utilizará para desarrollar armas

"Sabemos que los comandantes están viendo un valor militar en las municiones de merodeo en Ucrania", afirma a este mismo medio Richard Moyes, director de Article 36, una organización humanitaria centrada en la reducción de los daños causados por las armas de guerra.

Pero EEUU no es el único que está extrayendo lecciones de la guerra en Ucrania. Este mes, recuerda The Conversation, un fabricante ruso clave anunció planes para desarrollar una nueva versión de combate de su robot de reconocimiento Marker, un vehículo terrestre sin tripulación, para aumentar las fuerzas existentes en Ucrania.

A ello se añaden, entre otros recursos, los drones totalmente autónomos que se están utilizando para defender instalaciones energéticas ucranianas, entre otros enclaves. Míjail Fedorov, ministro ucraniano de Transformación Digital, ha afirmado en declaraciones recogidas por este medio que las armas totalmente autónomas son el "siguiente paso lógico e inevitable" de la guerra.

Estas informaciones contrastan con los esfuerzos llevados a cabo en las últimas semanas por la comunidad internacional para tratar de limitar el uso de robots autónomos en conflictos armados como el de Ucrania.

Sin ir más lejos, la semana pasada concluyó un encuentro llevado a cabo en La Haya y liderado por Países Bajos y Corea del Sur en el que más de 60 países firmaron un acuerdo para promocionar un "uso responsable" de la IA de uso militar.

Aunque este contó con la firma de EEUU y China, dos potencias que suelen ser reacias a consensos en materia militar, también adoleció de notables ausencias: Rusia no fue invitada, Ucrania no pudo acudir e Israel, una potencia mundial en desarrollo tecnológico, no quiso firmar.

Los expertos subrayan, además, que se trata de un acuerdo no vinculante sin valor jurídico, con lo que este tiene tantas posibilidades de quedar en papel mojado como los tímidos acercamientos que, bajo el amparo de la ONU, han tratado de llevar a cabo las grandes potencias armamentísticas en la última década.

A través de la conocida como Convención sobre ciertas armas convencionales, Naciones Unidas lleva desde 2014 tratando de limitar el uso de la IA en la guerra para que nunca recaiga sobre una máquina la decisión de quién debe morir en un conflicto armado.

Sin embargo, por ahora el temor a quedar rezagado en desarrollo tecnológico de estas armas ha podido más, y por norma general las grandes potencias militares del mundo han sido siempre reacias a llegar a ningún acuerdo vinculante.

Como respuesta, proliferan ya oenegés como Stop Killer Robots (Parad a los robots asesinos) que abogan por un control más férreo de esta tecnología.

"La tecnología debe utilizarse para empoderarnos a todos, no para reducirnos a estereotipos, etiquetas, objetos o simplemente a patrones de unos y ceros. Ante la creciente deshumanización digital, la coalición Stop Killer Robots trabaja para garantizar el control humano en el uso de la fuerza. Nuestra campaña reclama una nueva legislación internacional sobre la autonomía de los sistemas de armamento", reza su página web.

Aliada con Human Rights Watch, la ONG sostiene además que los sistemas de armas autónomas carecen del juicio humano necesario para distinguir entre civiles y objetivos militares legítimos. También tienden a subestimar el riesgo de bajas civiles, con lo que entran más en combate, y restan al ser humano control sobre lo que sucede en el campo de batalla.

Los expertos subrayan que EEUU, Rusia, China, Corea del Sur y la Unión Europea se han lanzado ya a una carrera armamentística por el dominio de la IA en la guerra que no solo puede desestabilizar el tablero geopolítico, sino que supone una amenaza para todos en caso de que esta tecnología caiga, por ejemplo, en manos de grupos terroristas.

No en vano, Eric Schmidt, antiguo CEO de Google y hombre involucrado de lleno en el negocio de la IA de uso militar, ha señalado recientemente que estos avances significarán para la guerra lo mismo que en su día supuso la bomba nuclear: un cambio total.

Conoce cómo trabajamos en BusinessInsider.

Etiquetas: Rusia, Inteligencia artificial, China, Guerra en Ucrania, Estados Unidos