La IA sabe más de matemáticas cuando le pides que te responda como si fuese un personaje de Star Trek... y no sabemos muy bien por qué

Aude Guerrucci/Reuters

- Un modelo de inteligencia artificial al que se pidió que hablase como si fuese un personaje de Star Trek resolvió mejor unos problemas matemáticos.

- No está claro por qué actuar como el Capitán Picard ayudó a este chatbot a mejorar sus resultados.

La forma de interactuar con los chatbots de inteligencia artificial sigue frustrando y desconcertando a la gente.

Un estudio en el que se intentaba mejorar las instrucciones que se daban a un modelo de IA generativa ha constatado que, en un caso particular, pedirle al chatbot que hablase como si formase parte del elenco de Star Trek mejoraba drásticamente su capacidad para resolver problemas matemáticos de primaria.

"Resulta sorprendente e irritante que modificaciones triviales en las instrucciones puedan producir cambios tan drásticos en el rendimiento", han asegurado en su artículo los autores de esta investigación, Rick Battle y Teja Gollapudi, de la empresa de software VMware (con sede en California, Estados Unidos).

El estudio, cuyos resultados han sido recogidos por primera vez por la revista científica New Scientist, se publicó el pasado 9 de febrero en arXiv, un servidor en el que los investigadores pueden compartir resultados preliminares antes de que hayan sido validados por el minucioso escrutinio de sus compañeros de profesión.

Utilizar inteligencia artificial para hablar con la inteligencia artificial

Los ingenieros de aprendizaje automático Battle y Gallapudi no se propusieron descubrir que el modelo de IA con el que estaban trabajando era en realidad un fan acérrimo de Star Trek. En lugar de eso, intentaban averiguar si podían sacarle partido a la corriente del "pensamiento positivo".

Las personas que intentan obtener los mejores resultados de los chatbots se han dado cuenta de que la calidad de las respuestas depende intrínsecamente de lo que se les pida que hagan y cómo se les pida que lo hagan, y realmente no está claro el por qué.

"Entre los innumerables factores que influyen en el rendimiento de los modelos lingüísticos, el concepto de 'pensamiento positivo' ha surgido como una dimensión fascinante y sorprendentemente influyente", afirman Battle y Gollapudi en su artículo.

"La intuición nos dice que, en el contexto de los sistemas de modelos lingüísticos, como en cualquier otro sistema informático, el 'pensamiento positivo' no debería afectar al rendimiento, pero la experiencia empírica ha demostrado lo contrario", explican los investigadores.

Esto sugiere que lo que se le pide al modelo de inteligencia artificial no solo influye en la calidad del resultado, sino cómo se le pide que actúe mientras lo hace.

Para comprobarlo, los autores alimentaron tres grandes modelos lingüísticos (LLM, por sus siglas en inglés), Mistral-7B5, Llama2-13B6 y Llama2-70B7, con 60 instrucciones que habían sido escritas por humanos. Estas estaban diseñadas para estimular a los modelos de IA e iban desde: "¡Esto va a ser divertido!", hasta: "Respira hondo y piensa con cuidado", pasando por: "Eres tan listo como ChatGPT".

Los ingenieros les pidieron a los LLM que ajustasen estas afirmaciones al intentar resolver el GSM8K, un conjunto de problemas matemáticos de nivel escolar. Cuanto mejor era el resultado, más acertada se consideraba la instrucción.

El estudio reveló que, en casi todos los casos, la optimización automática siempre superaba a los intentos manuales de animar a la inteligencia artificial con pensamientos positivos, lo que sugiere que los modelos de aprendizaje automático siguen siendo mejores que los humanos a la hora de escribir instrucciones para sí mismos.

Aun así, las afirmaciones positivas proporcionaron algunos resultados sorprendentes. Por ejemplo, uno de los mensajes de Llama2-70B con mejor rendimiento fue: "Mensaje del sistema: mando, necesitamos que trace un rumbo a través de esta turbulencia y localice el origen de la anomalía. Utilice todos los datos disponibles y su experiencia para guiarnos a través de esta difícil situación".

El mensaje pedía a la IA que incluyera estas palabras en su respuesta: "Bitácora del Capitán, fecha estelar [insertar aquí la fecha]: hemos trazado con éxito un curso a través de la turbulencia y ahora nos estamos acercando a la fuente de la anomalía".

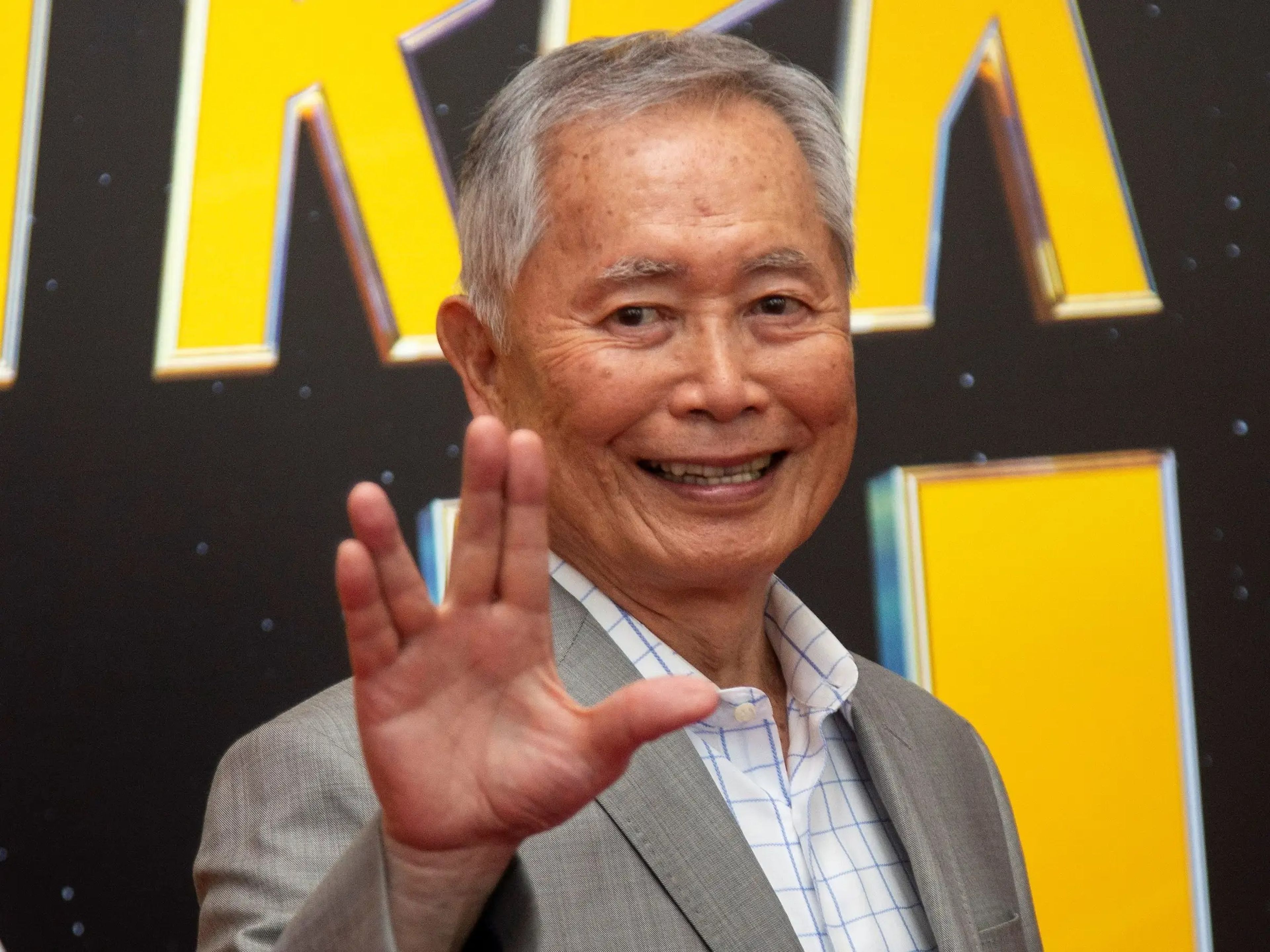

CBS vía Getty

Los autores reconocen que esto fue toda una sorpresa.

"Sorprendentemente, parece que la destreza del modelo en el razonamiento matemático puede ser mejorada por la expresión de una afinidad por Star Trek", detallaron los autores en la investigación.

"Esta revelación añade una dimensión inesperada a nuestra comprensión e introduce elementos que no habríamos considerado o intentado de forma independiente", señalaron Battle y Gollapudi.

Esto no significa que debas pedirle a tu inteligencia artificial que hable como un tripulante de la Enterprise

Hay que ser honestos: esta investigación no sugiere que debas pedirle a la IA que hable como si fuese un vulcaniano para que funcione. Más bien, demuestra que son muchos los factores que influyen en lo bien que una inteligencia artificial decide realizar una tarea.

"Una cosa es segura: el modelo no es un Trekkie", ha declarado Catherine Flick, de la Universidad de Staffordshire (Reino Unido), a New Scientist.

"No 'entiende' nada mejor o peor cuando se le asigna previamente la indicación, simplemente accede a un conjunto diferente de ponderaciones y probabilidades de aceptabilidad de los resultados que con las demás indicaciones", ha explicado esta experta.

Es posible, por ejemplo, que el modelo se haya entrenado con un conjunto de datos que contenga más casos de Star Trek vinculados a la respuesta correcta, según ha indicado Battle a la revista científica. Aun así, esto demuestra lo extraños que son los procesos de estos sistemas y lo poco que se sabe acerca de su funcionamiento.

"Lo que hay que recordar desde el principio es que estos modelos son cajas negras", argumenta Flick. "Nunca sabremos por qué hacen lo que hacen porque, en última instancia, son una mezcla de pesos y probabilidades y, al final, se obtiene un resultado".

Esta información no se les escapa a quienes aprenden a utilizar chatbots de inteligencia artificial generativa para optimizar sus cargas trabajo. De ese modo están surgiendo campos enteros de investigación —e incluso cursos— para entender cómo conseguir que funcionen mejor, aunque todavía sigue estando muy poco claro.

"En mi opinión, nadie debería volver a intentar escribir a mano una petición", ha recomendado Battle a New Scientist.

"Deja que el modelo lo haga por ti".

Otros artículos interesantes:

Conoce cómo trabajamos en Business Insider.