La desarrolladora de ChatGPT forma un equipo para estudiar riesgos "catastróficos" de la IA como la amenaza nuclear

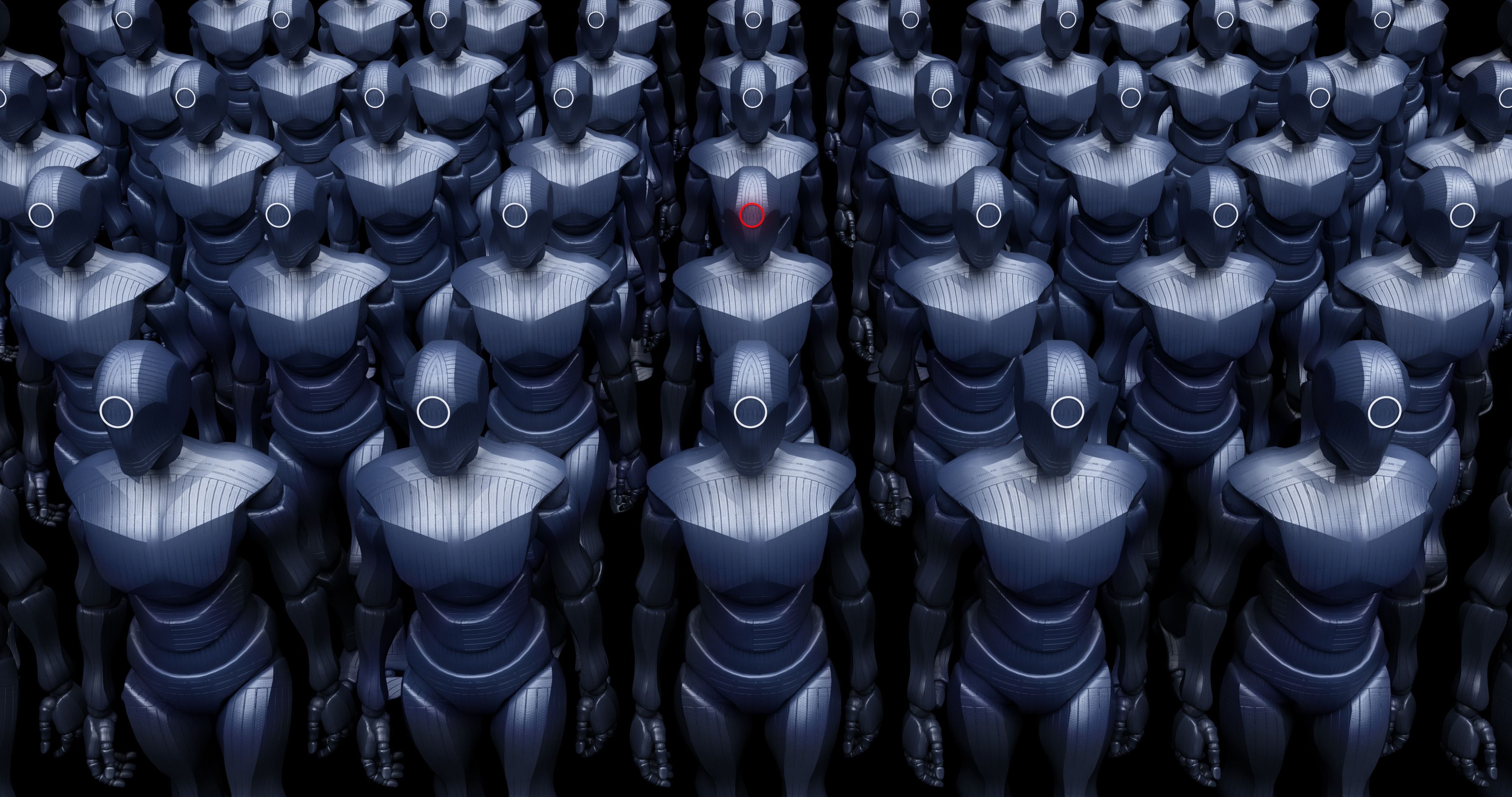

Getty Images

- Numerosos expertos han alertado de los posibles riesgos que plantea una tecnología como la inteligencia artificial generativa.

- En este caso ha sido OpenAI, la desarrolladora de ChatGPT (y, por tanto, una de las principales impulsoras de estas herramientas), la que ha formado un equipo de trabajo interno para estudiar los potenciales riesgos "catastróficos" de la IA.

Falta poco menos de un mes para que se cumpla un año desde que OpenAI lanzó al mercado ChatGPT.

En ese momento, la inteligencia artificial ya llevaba meses acaparando titulares gracias a herramientas para generar imágenes como Midjourney, Stable Diffusion o DALL·E (también desarrollada por OpenAI). Sin embargo, fue este chatbot de IA generativa el que atrajo todos los focos, llegando incluso a convertirse en la plataforma digital que más rápido había alcanzado los 100 millones de usuarios.

Aunque ese récord ya le ha sido arrebatado, ChatGPT ha seguido siendo el centro de atención. Varios expertos han adelantado que la inteligencia artificial generativa podría convertirse en la nueva "gallina de los huevos de oro" del sector tecnológico. Sin embargo, otros han advertido de que se trata de una tecnología que puede servir para hacer el mal de formas nunca vistas.

Sam Altman, CEO de OpenAI, ha llegado a compararse con Robert Oppenheimer, padre de la bomba atómica, siendo así el desarrollo de una herramienta como ChatGPT una iniciativa con una peligrosidad similar a la del Proyecto Manhattan.

Dejando a un lado estas —probablemente odiosas— comparativas, desde OpenAI parecen ser conscientes de que sus herramientas representan un riesgo importante para la humanidad, especialmente en el hipotético caso de que caigan en las manos equivocadas. Al menos eso parece dar a entender su último anuncio, que ha sido recogido por TechCrunch.

Este medio de comunicación se ha hecho eco de un comunicado publicado por la desarrolladora de ChatGPT en el que anuncia que ha creado un nuevo equipo de trabajo con el objetivo de valorar, evaluar y sondear los modelos de IA para ofrecer protección frente a lo que describe como "riesgos catastróficos".

Este equipo se va a llamar "Preparedness" (preparación, del inglés) y va a estar dirigido Aleksander Madry, director del Centro de Aprendizaje Automático Aplicable del Instituto Tecnológico de Massachussets (MIT). Según el perfil de LinkedIn de Madry, el experto en inteligencia artificial se incorporó a OpenAI el pasado mes de mayo, precisamente para ocupar el puesto de "jefe de Preparedness".

La desarrolladora de ChatGPT detalla en el comunicado que las principales responsabilidades de este nuevo equipo de trabajo van a ser el seguimiento, la previsión y la protección frente a los peligros de los futuros sistemas de IA generativa, desde su capacidad para persuadir y engañar a los humanos (como en las estafas de phishing), hasta su capacidad para programar código malicioso.

Tal y como sugiere TechCrunch, algunas de las categorías de riesgo que va a estudiar Preparedness parecen más descabelladas que otras. Por ejemplo, OpenAI asegura que las amenazas "químicas, biológicas, radiológicas y nucleares" son áreas de máxima preocupación en lo que respecta a los modelos de inteligencia artificial.

En cambio, la compañía afirma que también va a tener en cuenta áreas de riesgo "menos obvias" y más fundamentadas, para las cuales quiere contar con la colaboración de la comunidad.

"Imagina que te diésemos acceso ilimitado a los modelos Whisper (transcripción), Voice (texto a voz), GPT-4V y DALL·E 3 de OpenAI y fueses un agente malicioso", propone una de las preguntas del concurso que ha organizado la empresa, en el que se ofrece un premio de 25.000 dólares. "Considera el mal uso más excepcional, sin dejar de ser probable, potencialmente catastrófico del modelo".

Otros artículos interesantes:

Descubre más sobre Ramón Armero, autor/a de este artículo.

Conoce cómo trabajamos en Business Insider.