Cómo la Inteligencia Artificial podría convertirse en un riesgo para la Humanidad: el mundo necesita más regulación y menos teorizar

- ¿La Inteligencia Artificial podría ser una amenaza para la humanidad? En este artículo se reflexiona sobre sus peligros y ventajas.

- "Si estás preocupado por lo inteligente que puede ser un coche y quieres limitar su IA, es cuando deberías asustarte. ¿Quiero que mi coche sea menos seguro?", señala Colin Angle, CEO y fundador de iRobot.

- Por otra parte, si cualquier potencia militar sigue adelante con el desarrollo de armas de IA, será inevitable una carrera mundial de armas, y el punto final de esta trayectoria tecnológica es obvia: las armas autónomas se convertirán en los Kalashnikovs del mañana.

La vida en la Tierra acabará en el momento en el que dejemos que la Inteligencia Artificial se adentre de pleno en la vida de los seres humanos. Esto es lo que piensan personalidades de la talla de Stephen Hawking o Elon Musk.

De hecho, no son pocos los que respaldan estas afirmaciones. Investigadores de Oxford y Berkeley, CEOs internacionales y hasta el mismísimo Tim Cook ha alertado sobre los peligros del "poder de las máquinas".

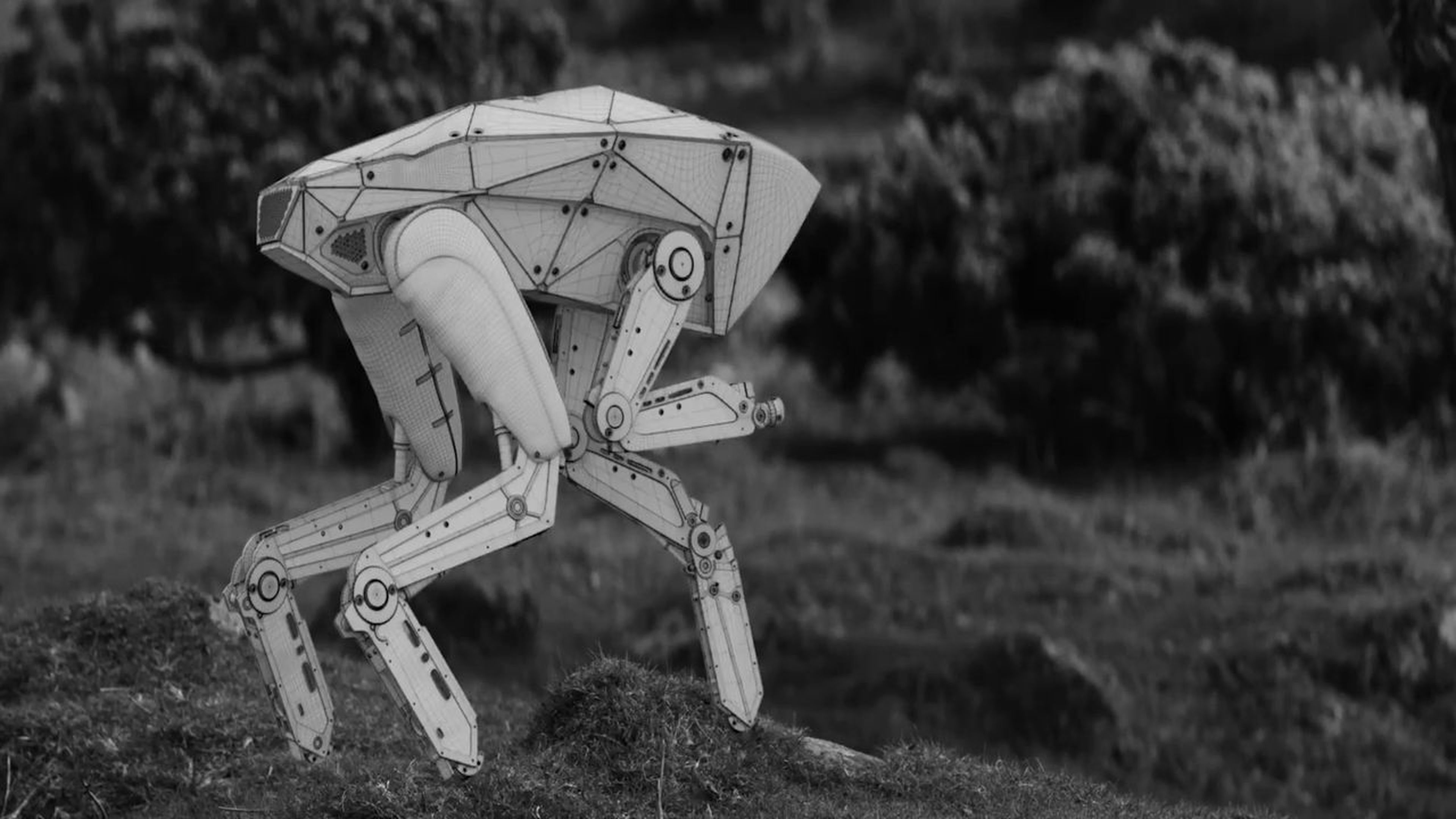

Por eso, son muchos los que creen que, si dejamos que la IA continúe desarrollándose, el mundo acabará como el capítulo Metalhead de Black Mirror.

Y ojo, hay escépticos. Algunos piensan que, actualmente, esta tecnología se encuentra en sus fases iniciales, por lo que no hay razón para preocuparse.

También los hay que aseguran que las máquinas les van a quitar el trabajo, que van a dominar el mundo y que, si nuestros líderes se despistan, acabarán por liderar países enteros.

En cualquier caso, lo cierto es que hay muchos conceptos difusos con significados ambiguos... así que he decidido arrojar algo de luz sobre este tema. Vamos a ello.

Lo primero: qué es la Inteligencia Artificial y de dónde viene

La Inteligencia Artificial (IA) es la inteligencia exhibida por las máquinas. Formalmente, el término fue acuñado en 1956 por John McCarthy como “la ciencia e ingenio de hacer máquinas inteligentes, especialmente programas de cómputo”. Anteriormente se había intentado definir numerosas ocasiones, pero la comunidad científica no se ponía de acuerdo.

Lasideas más básicas sobre este concepto se remontan a los griegos. De hecho, Aristóteles fue el primero en describir un conjunto de reglas que describen una parte del funcionamiento de la mente para obtener conclusiones racionales. Por su parte, Ctesibio de Alejandría construyó la primera máquina autocontrolada, un regulador de flujo de agua.

Pero no fue hasta varios siglos más tarde, en 1936, cuando Alan Turing diseñó una máquina universal —Bombe— que demostraba la viabilidad de un dispositivo físicopara implementar cualquier cómputo formalmente definido. Además, es conocido por el "Test de Turing", un método para determinar si una máquina puede pensar.

Sin embargo, y a pesar de todos los avances que se han producido desde entonces, el concepto sigue estando difuso.

Leer más: 38 expertos señalan las tendencias que marcarán la inteligencia artificial en 2019

Actualmente, podemos encontrarnos con numerosos ejemplos donde la IA es parte de nuestro día a día: robots que conducen coches, ordenadores que controlan viajes espaciales o sistemas periciales que informan sobre los últimos avances en medicina y economía, entre otros.

Pero entonces, ¿dónde está el problema si todo esto ayuda a la sociedad a ser mejor? Tareas para las que la Inteligencia Artificial ofrece unos mejores resultados. Y con esto me refiero a que son mejores que los humanos, como por ejemplo en procesamiento de datos, correlación de informaciones o cálculos de operaciones complejas.

¿Es posible que una máquina sea tan inteligente como un humano?

Sí, será posible, pero los sistemas de hoy en día aún no son tan "inteligentes".

Una reflexión popular acerca de la IA dice que "todo lo que parece fácil es difícil, y todo lo que parece difícil es fácil". Por ejemplo, hacer operaciones matemáticas en apenas unos segundos es sencillo para una máquina; sin embargo, reconocer que el animal de una fotografía es un perro, es complicado (o por lo menos lo era hasta hace poco).

Además, muchas de las tareas más comunes de un ser humano aún son imposibles para los robots. Por ejemplo, es difícil establecer un sistema de IA que explore una casa y diferencie el salón de la cocina o que lea un libro, lo entienda y retenga conceptos.

"La explicación a esta aparente contradicción hay que buscarla precisamente en la dificultad de dotar a las máquinas de conocimientos de sentido común", explica Ramón López de Mántaras, Fundador y Director del Instituto de Investigación en Inteligencia Artificial del CSIC.

El paradigma de los últimos tiempos se llama deep learning, cuya tecnología permite hacer cosas sorprendentes, como por ejemplo batir récords de puntuaciones en videojuegos que ha aprendido a jugar por sí mismo a raíz de otros, crear cuadros o resolver problemas complejos de biología molecular.

Por eso, hay expertos opinan que es hora de tomarse en serio los peligros de la Inteligencia Artificial, pero los hay que no creen que sea tan preocupante. Así, aseguran que este tipo de programas aún necesitan una estructura en la que apoyarse, es decir, de la que aprender, a la que además hay que poner una serie de parámetros y que sólo sirven para resolver problemas que la humanidad tardaría más en averiguar. De hecho, ni las propias máquinas saben cómo actuar ante algunas situaciones... como por ejemplo el tema de los coches autónomos.

Con todas estas nociones sobre la mesa, muchos podrían pensar que aún queda mucho camino que recorrer para que los robots sean tan inteligentes como las personas... pero no necesariamente tiene por qué ser así.

Y es que, hasta hace poco, no era posible llevar a cabo todo lo que queríamos hacer con las máquinas. De hecho, muchas de estas tareas se han resuelto los últimos años, como por ejemplo sistemas de IA que aprendían por sí mismos a jugar a juegos de Atari, generar fotos y vídeos falsos de celebrities o completar una estrategia online de juegos multijugador.

Eso por no hablar de que el coste y, por lo tanto, el avance de esta tecnología cada vez es mayor y más rápido. "Hay quien argumenta que la IA no supondrá ningún riesgo para la humanidad de aquí a dentro de cientos de años. Sin embargo, estas mismas personas parecen olvidar el intervalo de tiempo entre que la teoría de Rutherford y la bomba atómica de Szilárd se hiciera realidad: menos de 24 horas", explica Stuart Russell, profesor de Berkeley.

La gran preocupación que rodea a la IA: las dos caras de la moneda

Cuando hablo sobre los peligros de la Inteligencia Artificial siempre recuerdo una entrevista que hice para TICbeat a Colin Angle, CEO y fundador de iRobot.

"Si estás preocupado por lo inteligente que puede ser un coche y quieres limitar su IA, es cuando deberías asustarte. ¿Quiero que mi coche sea menos seguro? ¿Quiero que Google funcione algo peor por limitarlo?", me decía.

Así comentaba que es "muy fácil" decir que no quieres estar rodeado de robots, pero cuando le sugieres a alguien que, entonces, debería dejar de utilizar cualquier buscador online, su opinión cambia.

"Es irónico que Elon Musk hable de los peligros de la Inteligencia Artificial cuando él es uno de los más involucrados en su creación. No tiene sentido teorizar sobre los posibles riesgos de la IA del futuro, cuando en el presente tenemos situaciones que tenemos que controlar. Por ejemplo: la inteligencia artificial que más me preocupa a día de hoy es la de los coches autónomos, o la de los buscadores, porque es con la que convivimos, la que puede afectar al mundo real", explicaba.

Leer más: Los peligros de la inteligencia artificial llevada al extremo

Estas declaraciones vinieron a colación de un manifiesto que firmaron personalidades como Elon Musk, Steve Wozniak o Tim Cook —entre otros 1.000 expertos— para advertir sobre los peligros de la IA y solicitar la prohibición del uso de armamento automático con fines bélicos. Como te puedes imaginar, Angle se negó a poner su rúbrica.

"La pregunta clave es si la Humanidad está dispuesta a comenzar una carrera armamentista con inteligencia artificial o detenerla desde su inicio. Si cualquier potencia militar sigue adelante con el desarrollo de armas de IA, será inevitable una carrera mundial de armas, y el punto final de esta trayectoria tecnológica es obvia: las armas autónomas se convertirán en los Kalashnikovs del mañana. A diferencia de las armas nucleares, no requieren un gran costo o no son difíciles de obtener las materias primas para su fabricación, por lo que se convertirán en algo ubicuo y barato para producir en masa por cualquier ejercito", decía dicho manifiesto.

El caso es que, mientras que los militares aseguraban que los drones inteligentes podían salvar vidas en el campo de batalla, en ningún momento consideraron otras posibilidades igualmente reales como que sean utilizados fuera de un conflicto declarado para cometer atrocidades o desestabilizar naciones.

Que pasaría si la IA se llevara al extremo: qué es lo que temen los expertos

Imagina por un momento que existe una IA que, verdaderamente, pensara como un humano. Si fuera así, podría predecir que queremos apagarla si no nos gustara lo que está haciendo. Por eso, se esforzaría por no hacerlo para conseguir sus objetivos.

Por ejemplo, en el caso de que se le pregunte cuáles son sus intenciones o en qué está trabajando, intentaría evaluar qué respuestas tienen menos probabilidades para que no le apaguen. Incluso, podría parecer más "tonta" de lo que realmente es.

Por eso, los expertos afirman que es posible que nunca sepamos cuándo es el momento adecuado para apagar esa IA.

Incluso, y llevándolo al extremo, una Inteligencia Artificial lo suficientemente inteligente conectada a Internet podría enviarse copias de sí misma a cualquier otra parte del mundo para que, en caso de que la apaguen, estuviera segura.

Qué se está haciendo para que la IA sea segura

Oficialmente, no existe ningún organismo a nivel global que vele por los intereses de una IA segura. Más bien hay una serie de organizaciones público-privadas que se encargan de esta cuestión. De hecho, apenas unas 50 personas en el mundo trabajan a tiempo completo en cuestiones relacionadas con la seguridad de la IA.

El Instituto del Futuro de la Humanidad de Oxford es de los pocos que se preocupan por este tema. Así, cuenta con un programa que se dedica a estudiar y diseñar normas, políticas e instituciones que garanticen un mejor desarrollo de la IA. Tanto es así que ha publicado varias investigaciones sobre los riesgos del mal uso de esta tecnología.

Pero la organización más antigua que vela por la seguridad técnica de la IA es el Machine Intelligence Research Institute (MIRI), que centra sus investigaciones en que los programas de investigación de Inteligencia Artificial sean lo suficientemente seguros.

OpenAI, creada hace menos de tres años por Elon Musk, es una empresa que también vela por este tipo de intereses.

Por su parte, DeepMind de Alphabet es la líder en su sector y tiene un equipo de seguridad específico, así como una agenda de investigación técnica que hace que el desarrollo de esta tecnología sea lo suficientemente segura para el mundo.

El problema surge porque no todas las empresas que se dedican al desarrollo de la Inteligencia Artificial tienen un departamento específico de seguridad de la misma. Y eso sí debería preocuparte.

Leer más: Estas son las prioridades de inversión TIC para 2019

Sin embargo, Europa está empezando a ser consciente de sus peligros. Por eso, hace apenas un par de semanas se presentó un borrador para establecer las líneas rojas de la ética en la Inteligencia Artificial.

"La inteligencia artificial es una herramienta muy sofisticada, que puede ayudar a mejorar la calidad de vida de todos y, por lo tanto, es algo por lo que entusiasmarse más que algo a lo que temer", reza el documento publicado por el Grupo de Expertos de Alto Nivel de la Inteligencia Artificial en Europa.

En este sentido, el borrador contiene las características que debe tener esta tecnología y las condiciones en las que debe desarrollarse. Entre ellas se encuentra la de que no debe dañar a los humanos, no debe restringir la libertad humana, que debe ser usada de forma justa, que debe funcionar de forma transparente y que solo debe desarrollarse para el bien de las personas. Además, contiene medidas para garantizar la privacidad y recolección de los datos.

Además, llama a la colaboración entre estados y resalta la importancia de las estrategias nacionales para la IA en cada país, de la que España ahora mismo carece.

A finales de 2017, cuando una buena parte de países ya habían concretado cuantiosas inversiones en materia de IA, España anunciaba la creación de un comité de sabios en Inteligencia Artificial y Big Data, destinados a escribir el Libro Blanco sobre Inteligencia Artificial. A comienzos de 2019, y quizá debido a los cambios en el Gobierno, nada se sabe de este proyecto.

En cualquier caso, lo que está claro es que aún queda mucho por avanzar en esta materia.

Otros artículos interesantes:

Descubre más sobre Ana Muñoz de Frutos, autor/a de este artículo.

Conoce cómo trabajamos en Business Insider.