¿Debería la IA tener un freno de mano? El presidente de Microsoft España lo tiene claro

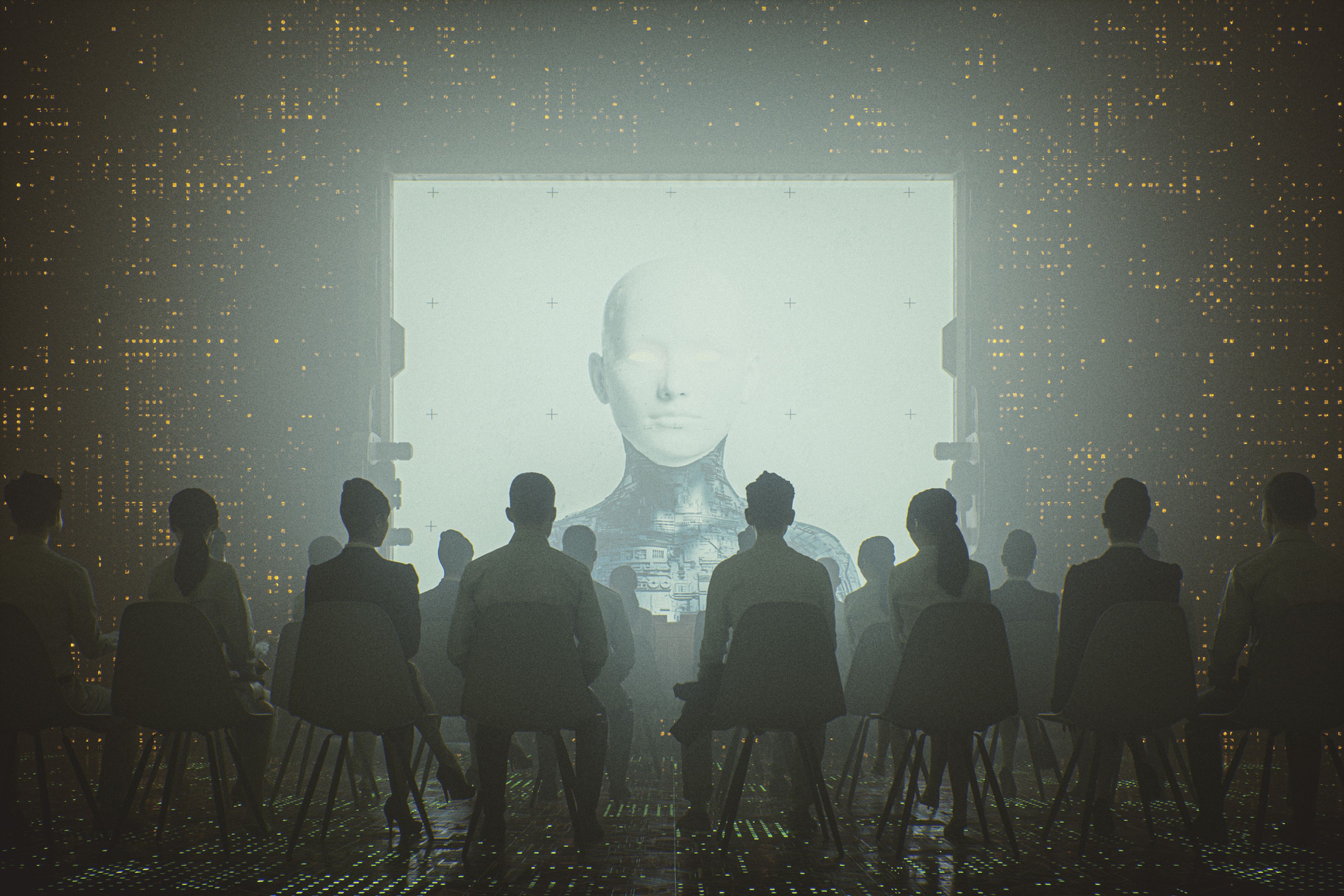

Getty

- El poder que han demostrado tener herramientas como ChatGPT ha provocado que multitud de expertos adviertan sobre el peligro que puede suponer la llegada de la inteligencia artificial generativa.

- Una de las piezas clave en este debate son las grandes tecnológicas como Microsoft. Su presidente en España ha reconocido que "tiene que existir un freno de mano, sobre todo cuando manejas sistemas de seguridad críticos".

El auge que ha experimentado la inteligencia artificial generativa en los últimos meses ha provocado que se generen una enorme cantidad de conversaciones en torno a esta tecnología.

Uno de los debates que más fuerza han cogido ha sido la posible necesidad de regular la IA generativa. Prácticamente desde que ChatGPT vio la luz a finales del pasado mes de noviembre, convirtiéndose en la plataforma que más rápido ha batido el récord de 100 millones de usuarios, los expertos comenzaron a señalar los posibles peligros que podrían atraer estas herramientas.

Se enumeraron riesgos como la posible violación de derechos de autor, la perpetuación de sesgos sociales (machismo, racismo, homofobia...), la desaparición de millones de puestos de trabajo o —directamente— la afección a la salud de millones de personas.

Estos debates pusieron sobre la mesa la necesidad de una regulación que controlase estas tecnologías. Por suerte para algunos y desgracia para otros, la Unión Europea se encuentra en las últimas fases para formalizar la aprobación del futuro Reglamento de Inteligencia Artificial, una normativa pionera en la legislación de herramientas como ChatGPT o Midjourney.

Sin embargo (y a diferencia de otras veces), las grandes tecnológicas que se encuentran detrás de estos programas —como OpenAI o Microsoft— se han posicionado abiertamente a favor de la regulación.

Sam Altman, CEO de OpenAI (la desarrolladora de ChatGPT), aprovechó una declaración ante el Senado estadounidense para pedir que se crease una agencia gubernamental que velase por la seguridad de la IA, y ahora ha sido Alberto Granados, presidente de Microsoft España, quien se ha mostrado a favor de la legislación.

"El compromiso de Microsoft es que los datos son de nuestros clientes"

BI España

La firma de Redmond ha organizado este miércoles un evento en Madrid en el que ha reunido a 1.200 asistentes de manera presencial para presentar la hoja de ruta de Microsoft en materia de inteligencia artificial y explicar cómo podría afectar esta tecnología a las empresas españolas.

"El compromiso de Microsoft es que los datos son de nuestros clientes", ha defendido Granados durante un encuentro con medios de comunicación al que ha acudido Business Insider España. "Nos basamos en modelos lingüísticos, los depuramos, pero esos datos son de nuestros clientes".

El presidente de Microsoft España ha querido apuntar a la propiedad de los datos como uno de los puntos clave, distanciándose así —hasta cierto punto— de OpenAI, cuyas herramientas utilizan las interacciones con los usuarios para entrenar sus propios modelos, lo que ha llevado a muchas compañías a prohibir a sus empleados que utilicen ChatGPT.

Granados ha argumentado que "todo esto tiene que tener una responsabilidad muy importante": "Estamos invirtiendo tanto en innovar como en gobernarlo, en estar seguros de que les damos a las empresas las capacidades para gobernarlo".

De ese modo, Microsoft ha establecido una "hoja de ruta de inteligencia artificial responsable" basada en 5 puntos. "Primero, definir nuevos marcos de seguridad: hemos trabajado activamente con los reguladores, tanto en Estados Unidos como en la Unión Europea", ha señalado el alto ejecutivo.

"De hecho, el AI Act que se ha anunciado recientemente en la UE ha sido una colaboración que hemos llevado con ellos", ha expresado. "En los próximos meses va a haber una ISO, la 42.001, estamos ya trabajando en ella para adaptarla a todos nuestros productos…".

Granados ha asegurado que "la infraestructura de la IA tiene que tener un freno de mano". "Tiene que existir un freno de mano, sobre todo cuando manejas sistemas de seguridad críticos. Esto tiene que estar regulado y, cómo tal, nosotros somos los primeros que lo apoyamos".

"Tenemos más de 300 personas dedicadas 100% a la IA responsable, eso es más que muchos gobiernos"

Granados ha explicado que la intención de Microsoft también pasa por que haya más transparencia a la hora de acceder a la tecnología: "No puede ser que la IA solo sea algo a lo que accedan las compañías del Ibex 35 que se lo puedan pagar". "Tiene que acceder cualquier pyme, tiene que acceder la academia, tienen que acceder las universidades, tienen que acceder las ONG…".

"La colaboración público-privada es absolutamente clave", ha afirmado el directivo, que ha defendido que llevan trabajando en estos principios desde 2016. "Tenemos más de 300 personas dedicadas 100% a la IA responsable, eso es más que muchos gobiernos. Son abogados, psicólogos, arquitectos, ingenieros...".

Las declaraciones del presidente de Microsoft España contrastan con las actuaciones de su socio estratégico, OpenAI. Aunque su CEO también se haya posicionado a favor de la regulación, según una investigación de la revista Time, la empresa habría presionado a la Unión Europea para que la futura normativa fuese mucho más laxa con respecto a las herramientas de IA generativa como ChatGPT.

Otros artículos interesantes:

Descubre más sobre Ramón Armero, autor/a de este artículo.

Conoce cómo trabajamos en Business Insider.