Imposible esconderse: una IA de reconocimiento facial de emociones evaluará la felicidad de los trabajadores chinos

Getty Images

- Un sistema chino de reconocimiento de emociones por IA puede monitorizar los rasgos faciales para saber cómo se sienten los empleados.

- No se podrá fingir, pues el sistema es capaz de analizar si la emoción mostrada es genuina.

- La empresa que está detrás del sistema cuenta con Huawei, China Mobile y PetroChina entre sus clientes, aunque no está claro si estas empresas han comprado el sistema de reconocimiento de emociones para utilizarlo en sus oficinas.

- Descubra más historias en Business Insider España.

Has trabajado 12 horas y te sientes cansado y frustrado, pero te obligas a mantener una expresión neutra en tu rostro. Estás demasiado agotado para seguir tecleando, pero no puedes bostezar, hacer una mueca o fruncir el ceño porque un ojo que todo lo ve te observa. Este ojo registra tus emociones y te delatará si te muestras demasiado enfadado.

Este no es el argumento de una película de ciencia ficción ni del próximo episodio de Black Mirror. Dentro de no mucho tiempo, podría ser una realidad para algunos empleados chinos que trabajan en grandes empresas tecnológicas.

Un sistema de reconocimiento de emociones desarrollado por la empresa china Taigusys puede detectar y controlar las expresiones faciales humanas y crear informes detallados sobre cada una de ellas para saber cómo se siente la persona en cuestión. Sin embargo, muchos investigadores afirman que este tipo de sistemas no solo suelen ser imprecisos, sino que, en principio, son muy poco éticos.

El sistema se dio a conocer este mes de mayo en un artículo de investigación de The Guardian. Taigusys tiene en cartera empresas multinacionales como Huawei, China Mobile, China Unicom y PetroChina, entre otros. No está claro, sin embargo, si estas empresas tienen licencia para utilizar este producto en particular.

Business Insider se ha puesto en contacto con Taigusys y con las 36 empresas que figuran en su lista de clientes, pero todas ellas han preferido no hacer comentarios.

¿Cómo funciona?

Taigusys

Taigusys afirma en su página web que su sistema ayuda a "afrontar nuevos retos" y puede "minimizar los conflictos" que plantea la confrontación.

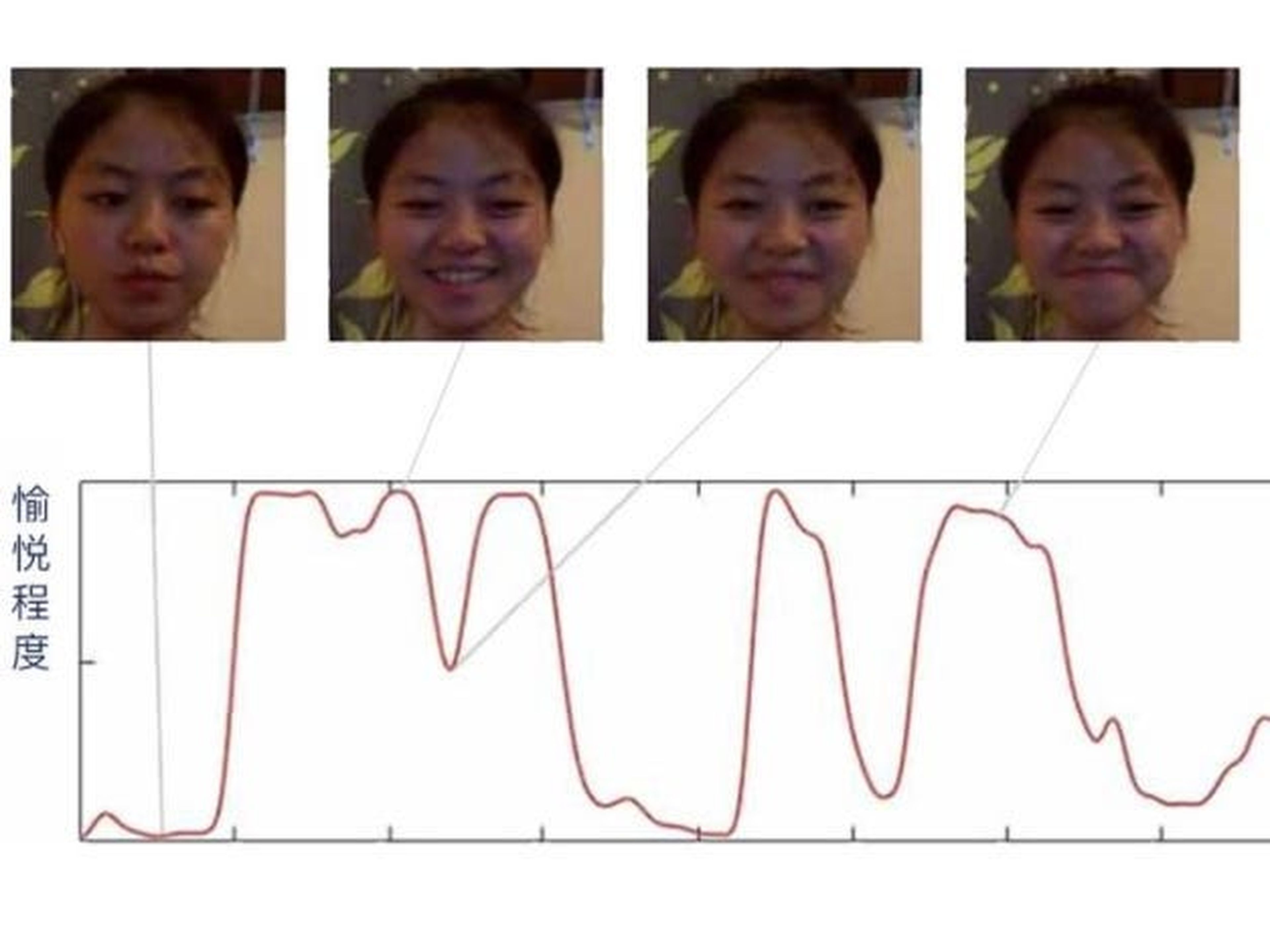

Esto se consigue gracias a un sistema de IA que puede evaluar las expresiones de varios individuos a la vez. A continuación, un algoritmo evalúa los movimientos de los músculos faciales y las señales biométricas de cada individuo y los clasifica según varias escalas señaladas por Taigusys.

Entre las emociones que busca el programa se encuentran la felicidad, la sorpresa y la euforia que procede de haber recibido de repente una buena noticia. El sistema de IA, no obstante, también comprueba el rostro de la persona en busca de emociones negativas como el asco, la pena, la confusión, el desprecio y la ira. De igual modo, tiene en cuenta emociones más neutras como el grado de concentración en una tarea.

Taigusys, incluso, va más allá y afirma que su software detecta tantos matices que puede saber cuándo alguien está fingiendo una sonrisa.

El software de reconocimiento de emociones puede, además, generar informes sobre los empleados para recomendarles apoyo emocional si superan los marcadores recomendados para las emociones negativas.

Taigusys

"A partir del análisis de los rasgos faciales, el sistema puede calcular el grado de frustración, estrés o nerviosismo de un individuo, entre otras métricas. También podemos analizar la respuesta emocional de la persona y averiguar si está tramando algo sospechoso", dice la empresa en la descripción del sistema.

Activistas en favor de los derechos humanos piden precaución en el despliegue de estos programas y destacan los problemas éticos que traen consigo

Activistas en favor de los derechos humanos y expertos en tecnología con los que ha hablado Business Insider han dado la voz de alarma sobre el despliegue de este tipo de programas y señalan que los sistemas de reconocimiento de emociones se basan fundamentalmente en ideas poco éticas y poco científicas.

Vidushi Marda, responsable de programa de la organización británica en favor derechos humanos Artículo 19, y Shazeda Ahmed, doctoranda en la Escuela de Información de la Universidad de Berkeley, han explicado a Business Insider que su trabajo de investigación conjunto sobre el mercado chino de reconocimiento de emociones, publicado este mes de enero, descubrió 27 empresas en China que estaban trabajando en el desarrollo de programas de reconocimiento emocional, entre ellas Taigusys.

"Si se implanta esta tecnología, se infringirán los derechos éticos y legales de los empleados en el lugar de trabajo. Incluso en las instalaciones de un lugar de trabajo privado sigue habiendo una expectativa de privacidad y dignidad. Esto, sin olvidar que existe el derecho de los empleados a actuar y pensar libremente", ha comentado Marda.

El activista ha añadido además que los sistemas de reconocimiento de emociones se basan en la pseudociencia y en la tenue suposición, científicamente no probada, de que las expresiones faciales están vinculadas al estado emocional interno de la persona.

"No hay forma de optimizar estas tecnologías para que se utilicen de forma ética porque los supuestos en los que se basan son en sí mismos poco éticos", ha señalado Marda.

Es más, plantea este experto, la vigilancia panóptica intensiva impuesta por dicha tecnología podría llevar a los trabajadores a la autocensura y a tener que explorar formas de controlar el comportamiento para burlar al propio sistema.

Daniel Leufer, analista de políticas europeas en la organización de derechos civiles digitales Access Now, ha hablado con Business Insider y ha ahondado en la cuestión de que, incluso si pudiera funcionar, a pesar de su inestable base científica, los programas de reconocimiento emocional constituyen una "flagrante violación" de varios derechos humanos como el derecho a la intimidad, la libre expresión y la libertad de pensamiento.

"Lo peor de todo es que todas estas violaciones se producen incluso si el reconocimiento de emociones no es científicamente posible. El mero hecho de que la gente crea que lo es y se pongan en marcha sistemas que afirman hacerlo tiene efectos reales en las personas", ha explicado Leufer.

"Una sociedad que controla las emociones es una sociedad que premiará a algunos y penalizará a otros". ¿Son ciertas emociones predictoras de la delincuencia o de la baja productividad?", se ha preguntado Rob Reich, profesor de Ciencias Políticas en Stanford y coautor de un libro sobre ética y tecnología que aparecerá pronto: Error del sistema. Dónde se equivocó Silicon Valley y cómo podemos darle al botón de reiniciar (System Error: Where Silicon Valley Went Wrong and How We Can Reboot, en su título original en inglés).

"El Gran Hermano estará vigilando y equipado para imponer un régimen emocional. El resultado es una violación sistemática de la privacidad y la degradación de la humanidad", he expresado Reich.

"Nunca es ético que otras personas utilicen sistemas de IA para vigilar las emociones de la gente, sobre todo si los que hacen la vigilancia están en una posición de poder en relación con los vigilados, como los empleadores, la policía y el gobierno", ha añadido Leufer.

Tal vez por eso, por el momento, las prisiones son uno de los únicos lugares de trabajo que han admitido abiertamente el uso del programa.

The Guardian ha hablado con Chen Wei, director general de Taigusys. Este ha revelado que los sistemas de la empresa están instalados en 300 prisiones y centros de detención de toda China. El sistema está conectado a unas 60.000 cámaras en esas instalaciones y ha ayudado a mantener a los presos "más dóciles", ha dicho Chen.

Con el sistema, las autoridades pueden controlar a las personas en tiempo real las 24 horas del día.

"La violencia y el suicidio son muy comunes en los centros de detención. Aunque hoy en día la policía no golpea a los presos, a menudo intenta agotarlos impidiéndoles conciliar el sueño. El resultado es que algunos presos sufren una crisis mental y buscan acabar con su vida. Nuestro sistema ayudará a evitar que eso ocurra", ha revelado Chen a The Guardian.

Más allá de las implicaciones éticas del software de reconocimiento de emociones, muchos dudan de que la tecnología sea lo suficientemente refinada como para pintar una imagen precisa

Desmond Ong, profesor adjunto del departamento de Sistemas de Información y Análisis de la Escuela de Informática de la Universidad Nacional de Singapur, cree que el software podría ayudar a "identificar situaciones peligrosas de vida o muerte, como pilotos y conductores de trenes fatigados, ebrios o con problemas mentales".

Pero, añade, "también podría utilizarse para penalizar injustamente u optimizar de forma inhumana el rendimiento de los empleados, como hacer de la empatía un indicador clave de rendimiento para los empleados de los centros de llamadas".

Ong señala además que sistemas como el desarrollado por Taigusys también socavan la complejidad de la expresión emocional humana al reducir a las personas a la expresión de las emociones más básicas.

"Sencillamente, no lo utilicen, no lo desarrollen y no lo financien. Es científicamente inestable, viola una serie de derechos fundamentales y además es francamente espeluznante", ha zanjado este experto, que subraya que no está claro hasta qué punto la IA sería capaz de entender la complejidad de las emociones.

Sandra Wachter, profesora asociada e investigadora principal del Instituto de Internet de la Universidad de Oxford, ha ido más allá. Para ella, es poco probable que un algoritmo entienda con precisión el complejo estado emocional de los seres humanos solo a través de sus expresiones faciales. Por ejemplo, explica, en el caso de las mujeres esto puede llegar a ser especialmente difícil, dado que, a la hora de socializar, estas tienden siempre a sonreír amablemente, lo que no necesariamente tiene por qué ser una señal de felicidad o de estar de acuerdo con el otro interlocutor o interlocutora.

Otros artículos interesantes:

Conoce cómo trabajamos en Business Insider.