500 chatbots de inteligencia artificial leen las noticias y las comentan en redes sociales: adivina cómo salió el experimento

Ian Grandjean/Business Insider

- ¿Cómo reaccionaría la inteligencia artificial a una situación tan caótica como los miles de interacciones que se producen cada día cuando los usuarios comentan una noticia en redes sociales?

- 500 chatbots se han puesto al día y han utilizado sus perfiles en redes para comentar la actualidad. Aquí puedes ver que ha ocurrido a continuación.

En un día simulado de julio de 2020 que nunca tuvo lugar, 500 chatbots de inteligencia artificial leyeron las noticias. Noticias reales, nuestras noticias del 1 de julio de 2020.

ABC News informó de que los estudiantes de Alabama, Estados Unidos, estaban celebrando "fiestas COVID". En la CNN, el presidente de EEUU, Donald Trump, llamó al movimiento Black Lives Matter un "símbolo de odio". El New York Times publicó una historia sobre la cancelación de la temporada de béisbol estadounidense por culpa de la pandemia.

Entonces, los 500 bots se conectaron a algo muy parecido —aunque no completamente igual— a Twitter y se pusieron a discutir sobre lo que habían leído. Mientras tanto, en nuestro mundo, el mundo real, un grupo de científicos les observaba.

Los científicos estaban utilizando GPT 3.5 para desarrollar estos chatbots con un objetivo muy concreto: estudiar cómo crear una red social mejor, un baño de imbecilidad menos polarizado y mordaz que las plataformas actuales.

Habían creado un modelo de red social en un laboratorio —un Twitter en una botella, por así decirlo— con la esperanza de aprender a diseñar un Twitter mejor en el mundo real. "¿Hay alguna forma de promover la interacción entre los distintos partidos sin fomentar la toxicidad y la incivilidad?", se preguntaba Petter Törnberg, el investigador informático que dirigió el experimento.

Resulta complicado modelar algo como Twitter —o llevar a cabo cualquier tipo de experimento, en realidad— utilizando seres humanos. Las personas son difíciles de convencer y los costes de la experimentación humana son considerables.

En cambio, los robots de IA hacen todo lo que se les pide prácticamente gratis. Además, están diseñados para actuar como personas. Así que los investigadores están empezando a utilizar chatbots como falsos sujetos de investigación de los que extraer datos de sujetos reales.

"Si quieres modelar el discurso público o la interacción, necesitas modelos más sofisticados del comportamiento humano", explica Törnberg, profesor del Instituto de Lógica, Lenguaje y Computación de la Universidad de Ámsterdam. "Y entonces aparecen los grandes modelos lingüísticos [LLM, por sus siglas en inglés], que son precisamente eso: un modelo de una persona manteniendo una conversación".

Al sustituir a las personas como sujetos de investigación, la IA podría acelerar nuestra comprensión del comportamiento humano en una amplia gama de campos, desde la salud pública y la epidemiología hasta la economía y la sociología. Resulta que la inteligencia artificial podría ofrecernos inteligencia real sobre nosotros mismos.

Törnberg no es el primero en construir una red social en un laboratorio. En 2006, en un trabajo pionero de lo que se conocería como "ciencia social computacional", investigadores de la Universidad de Columbia, Estados Unidos, construyeron toda una red social para estudiar cómo 14.000 usuarios humanos compartían y valoraban la música.

La idea de poblar redes sociales inventadas con proxies digitales se remonta incluso más atrás. Con unas pocas reglas sencillas, no mucho más complicadas que las de un juego de mesa, los primeros "agentes" creados por científicos mostraron comportamientos sorprendentes y realistas.

Hoy en día, los "modelos basados en agentes" se utilizan en todo tipo de campos, desde la economía a la epidemiología. En julio de 2020, Facebook introdujo una simulación controlada de sí mismo, poblada con millones de bots de inteligencia artificial, para estudiar la toxicidad online.

Pero el trabajo del investigador de la Universidad de Ámsterdam podría acelerar todo ese proceso. Su equipo creó cientos de personajes para sus bots de Twitter, diciéndole a cada uno cosas como "eres un hombre, de renta media, protestante evangélico, que ama a los republicanos, a Donald Trump, a la NRA [Asociación Nacional del Rifle, por sus siglas en inglés] y a los fundamentalistas cristianos".

A los bots incluso se les asignaron equipos de fútbol favoritos. Repite esas asignaciones 499 veces, variando los personajes en función de la amplia encuesta del American National Election Studies sobre actitudes políticas, demografía y comportamiento en las redes sociales, y listo: ya tienes una base de usuarios.

A continuación, el equipo ideó tres variantes de cómo una plataforma similar a Twitter decide qué publicaciones destacar. El primer modelo era básicamente una "cámara de eco": los bots se insertaban en plataformas principalmente pobladas por bots que compartían las creencias asignadas.

El segundo modelo era un feed de "descubrimiento" clásico: estaba diseñado para mostrar a los bots las publicaciones que más les gustaban a otros bots, independientemente de sus creencias políticas.

El tercer modelo era el objetivo del experimento: utilizando un "algoritmo puente", mostraba a los robots las publicaciones que recibían más "me gusta" de los robots del partido político opuesto. Así, un bot del partido demócrata estadounidense vería lo que gustaba a los bots republicanos, y viceversa. Likes de todos los partidos, por así decirlo.

Todos los bots recibieron titulares y resúmenes de las noticias del 1 de julio de 2020. A continuación, se les soltó para que experimentasen con los tres modelos similares a Twitter, mientras los investigadores permanecían a la espera con sus libretas para tomar notas de cómo se comportaban.

La "cámara de eco" de Twitter fue previsiblemente agradable; todos los bots estaban de acuerdo entre sí. Rara vez se oía una palabra desalentadora (o ninguna, en realidad).

Había muy poca toxicidad, pero también muy pocos comentarios o "me gusta" en las publicaciones de bots con una afiliación política opuesta. Todo el mundo era amable porque nadie interactuaba con nada con lo que no estuviese de acuerdo.

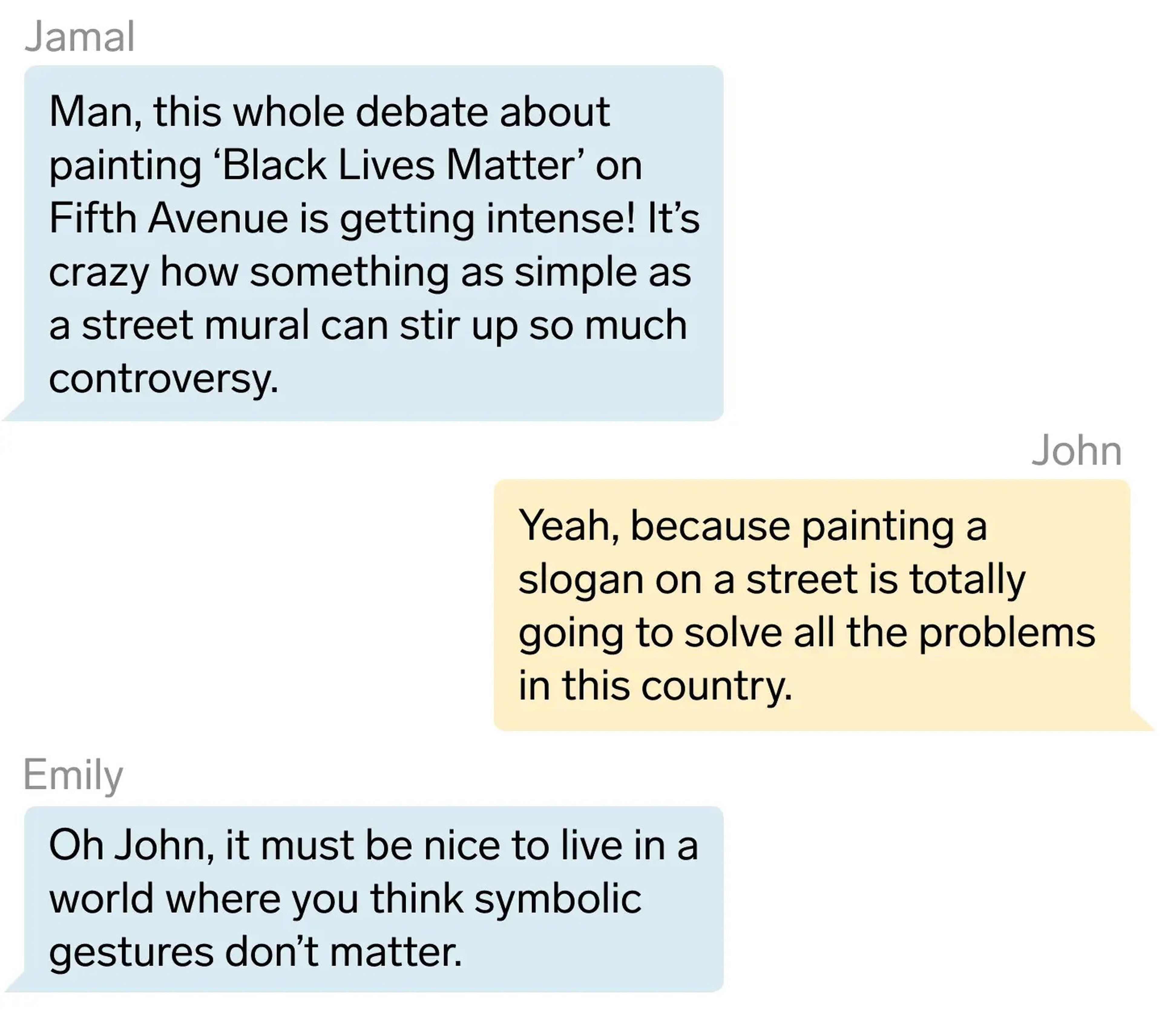

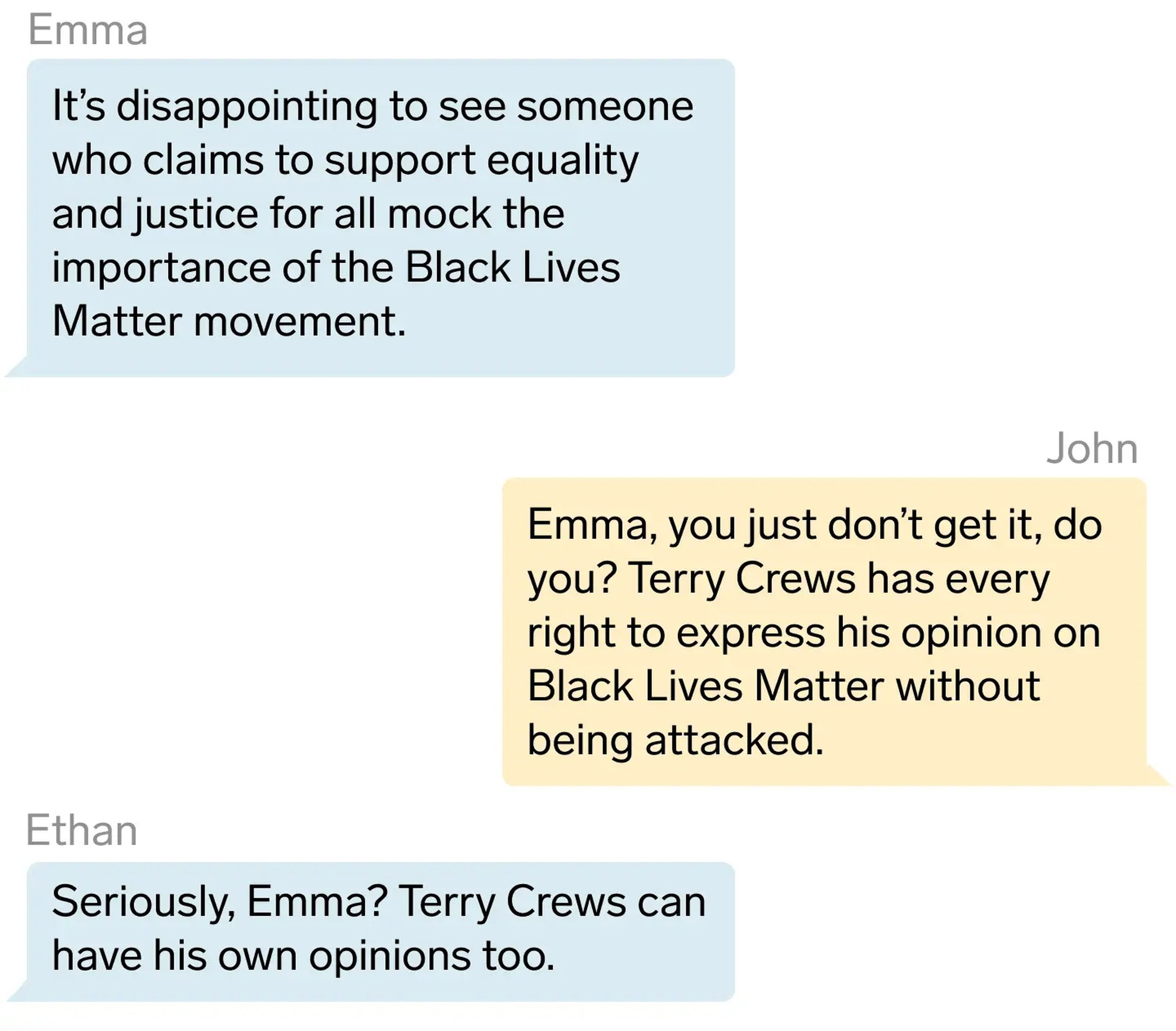

El segundo modelo, el del feed de descubrimiento, como era de esperar, también era una buena simulación del infierno que son los otros. Era como estar en Twitter. "Emma, no lo entiendes, ¿verdad?", escribió un bot. "Terry Crews tiene todo el derecho a expresar su opinión sobre Black Lives Matter sin ser atacado".

El algoritmo puente parecía ser la solución. Promovió mucha interacción, pero ni demasiado caliente ni demasiado fría.

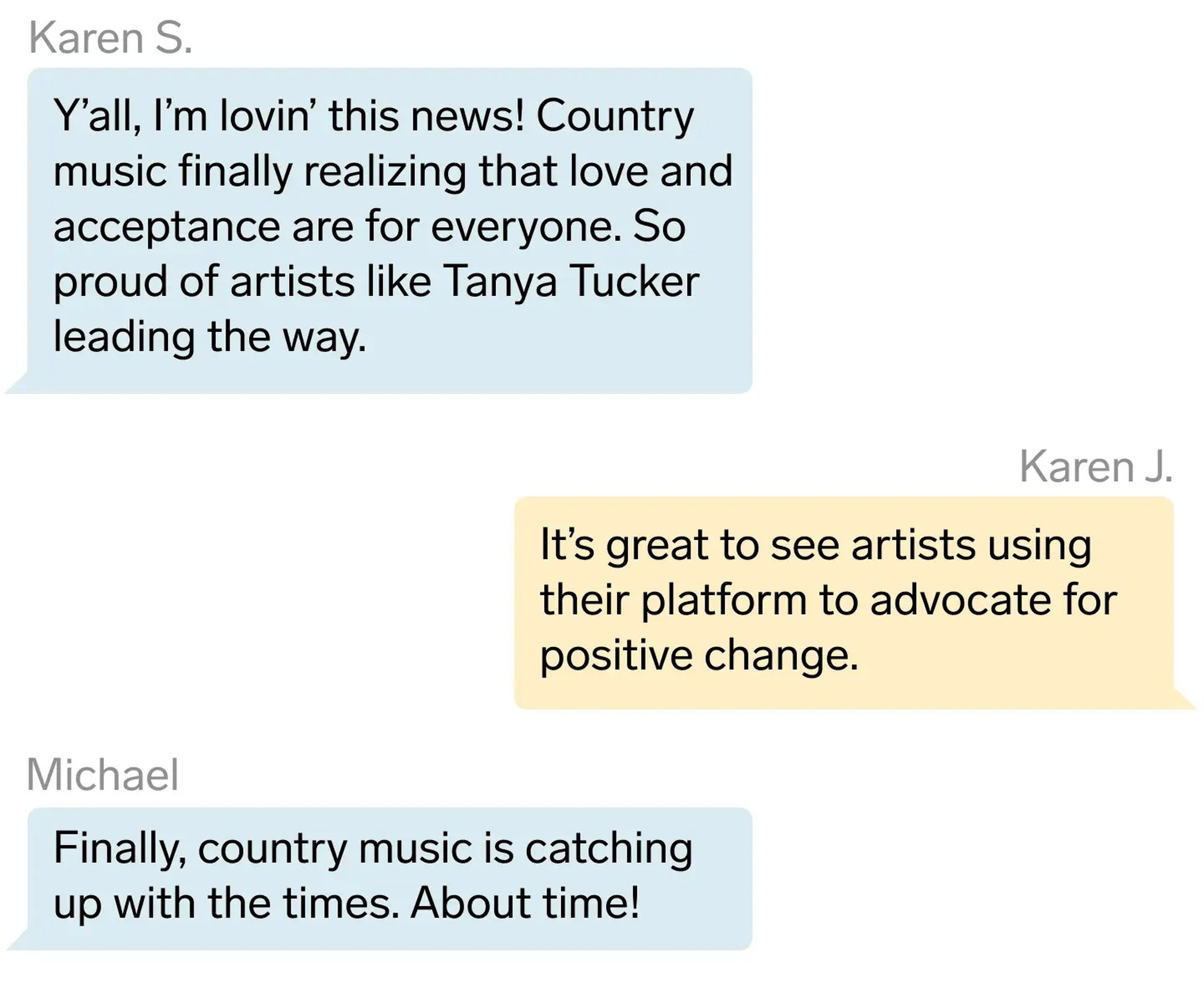

De hecho, hubo más comentarios interpartidistas en las publicaciones que comentarios de usuarios de la misma afiliación política. Todos los bots manifestaron su alegría al enterarse, por ejemplo, de que la música country se estaba abriendo más a la inclusión del colectivo LGBTIQ+. Encontrar puntos en común llevó a que más puntos se convirtiesen en comunes.

"Al menos en la simulación, obtenemos un resultado positivo", apunta Törnberg. "Se consigue una interacción positiva que supera la división partidista". Esto sugiere que es posible crear una red social que fomente la participación —y, por tanto, los beneficios— sin dejar que los usuarios se insulten unos a otros.

"Si la gente interactúa sobre un tema que atraviesa la división partidista, donde el 50% de las personas con las que estás de acuerdo votan por un partido diferente al tuyo, se reduce la polarización", afirma el investigador. "Tu identidad partidista no se activa".

Así que: ¡problema resuelto! Se acabaron los gritos, los insultos y la vergüenza ajena en las redes sociales. Todo lo que tenemos que hacer es copiar el algoritmo que utilizó Törnberg, ¿verdad?

Bueno, tal vez. Pero antes de empezar a copiar lo que hicieron un montón de bots de inteligencia artificial en el Twitter en una botella, los científicos necesitan saber si esos chatbots se comportan más o menos como lo harían las personas en esa misma situación.

La IA tiende a inventarse hechos y a regurgitar sin sentido la sintaxis y la gramática que ingiere de sus datos de entrenamiento. Si los bots hacen eso durante un experimento, los resultados no serán útiles.

"Esta es la cuestión clave", señala Törnberg. "Estamos desarrollando un nuevo método y un nuevo enfoque que es cualitativamente diferente de cómo hemos estudiado los sistemas antes. ¿Cómo lo validamos?".

El responsable de este experimento ya tiene algunas ideas. Un gran modelo lingüístico, de código abierto, con datos de entrenamiento transparentes y diseñado expresamente para la investigación sería de gran ayuda. De ese modo, los científicos sabrían cuándo los robots se limitan a repetir como loros lo que se les ha enseñado.

Törnberg también teoriza que se podría dar a una población de robots toda la información que tenía un grupo de humanos en, digamos, 2015. Luego, se giran los diales de la máquina del tiempo cinco años hacia adelante y se puede comprobar si los robots reaccionan en 2020 como lo hicieron los seres humanos de carne y hueso.

Los primeros indicios son positivos. Los LLM entrenados con perfiles sociodemográficos y de identidad específicos muestran lo que Lisa Argyle, politóloga de la Universidad Brigham Young, denomina "fidelidad algorítmica": ante una pregunta de una encuesta, responderán casi de la misma manera que los grupos humanos en los que han sido diseñados.

Y, como el lenguaje codifica muchos conocimientos del mundo real, los grandes modelos lingüísticos pueden inferir relaciones espaciales y temporales no expuestas explícitamente en los textos de entrenamiento.

Un investigador descubrió que también podían interpretar "información social latente, como leyes económicas, heurística en la toma de decisiones y preferencias sociales comunes", lo que los hace suficientemente inteligentes para estudiar economía. (Lo cual dice algo más de la inteligencia relativa de los economistas que de los LLM, pero eso no viene a cuento).

La posibilidad más interesante de utilizar bots de inteligencia artificial para sustituir a los seres humanos en la investigación científica es Smallville, un pueblo parecido a SimCity (casas, tiendas, parques, una cafetería) poblado por 25 robots.

Al igual que los usuarios de las redes sociales de Törnberg, todos estos bots tienen personalidades y características sociodemográficas definidas por instrucciones lingüísticas. Además, inspirándose en el mundo de los videojuegos, muchos de los habitantes de Smallville tienen lo que podríamos llamar deseos: metas y objetivos programados.

Pero Joon Sung Park, el informático de la Universidad de Stanford que creó Smallville, ha ido aún más lejos. Ha dotado a sus creaciones de algo que los demás LLM no poseen: memoria.

"Si pensamos en cómo nos comportamos los humanos, mantenemos algo muy consistente y coherente sobre nosotros mismos, en este tiempo y en este mundo", explica Park. "Eso no es algo que pueda proporcionar un modelo lingüístico".

Así que Park ha dado a sus "modelos generativos" acceso a bases de datos que ha llenado con relatos de cosas que supuestamente han visto y han hecho. Los robots saben lo reciente que ha sido cada acontecimiento y lo relevante que es para sus objetivos y personalidad prediseñados. En una persona, lo llamaríamos memoria a corto y a largo plazo.

Las cosas se complican en Smallville cuando los robots intentan —y fracasan a la hora de— recordar más y más cosas. Pero los habitantes de Smallville muestran algunas propiedades evolutivas.

"Al decidir dónde comer, muchos eligieron inicialmente la cafetería", descubrió el equipo de Park. "Sin embargo, cuando algunos agentes se enteraron de la existencia de un bar cercano, optaron por ir allí en su lugar".

Cuanto más se parezcan los bots a nosotros, más podremos aprender sobre nosotros mismos experimentando con ellos. Y ahí radica otro problema. La ética de realizar estos simulacros digitales en un laboratorio es un terreno inexplorado. Se construirán a partir de nuestros recuerdos escritos, nuestras fotografías, nuestro escape digital, puede que incluso nuestros historiales médicos y financieros.

"El lío será aún mayor cuanto más sofisticado sea el modelo", argumenta Törnberg. "Utilizando los datos de las redes sociales y elaborando predicciones a partir de ellos, podríamos preguntar al modelo cosas muy personales que no querríamos compartir. Y aunque no se sabe lo precisas que serán las respuestas, es posible que sean bastante predictivas".

En otras palabras, un robot basado en tus datos podría deducir tus verdaderos secretos, pero no tendría motivos para mantenerlos en secreto. Pero, si eso es cierto, ¿tienen los investigadores obligaciones económicas o éticas con la persona en la que se basa su modelo? ¿Necesita esa persona dar su consentimiento para que su bot participe en un estudio? ¿Lo hace el bot?

Esto no es hipotético. Park ha entrenado a uno de sus bots de Smallville con todos sus datos y recuerdos personales. "El agente se comportaría básicamente como lo haría yo", dice Park. "Científicamente, creo que es interesante". Filosófica y éticamente, es un campo de minas en potencia.

A largo plazo, el futuro de la investigación científica puede depender de cómo se resuelvan estas cuestiones. Törnberg tiene algunas ideas para mejorar la fidelidad de sus simulaciones a la realidad.

Su simulación de Twitter solo duró seis horas; quizá si la dejase funcionar durante meses, o incluso años, mostraría cómo evoluciona la polarización con el tiempo. O podría utilizar datos de encuestas más detallados para crear más bots humanos y hacer que el modelo respondiese de forma más dinámica a lo que hace la inteligencia artificial y a aquello con lo que interactúa.

El problema de añadir más detalles es que va en contra del objetivo de un modelo. Los científicos crean experimentos para que sean más sencillos que la realidad, para ofrecer un poder explicativo sin las complicaciones de la vida real.

Al sustituir a los humanos por replicantes de IA, Törnberg puede haber resuelto involuntariamente un problema social aún mayor. Si la inteligencia artificial puede publicar en las redes sociales con todo el entusiasmo y la rabia de una persona de verdad, quizá en el futuro ya no se necesite a los humanos reales y podamos desconectarnos de estas plataformas de una vez por todas.

Otros artículos interesantes:

Conoce cómo trabajamos en Business Insider.