Sí, la inteligencia artificial es racista, pero científicos y empresarios están intentando solucionarlo

Business Insider

- El año pasado, una inteligencia artificial de reconocimiento facial defectuosa condujo a la detención injusta de una mujer negra en Detroit, Estados Unidos.

- Los expertos afirman que los prejuicios e imprecisiones de la IA entre las personas racializadas tienen su origen en las influencias racistas de la tecnología.

- Algunos empresarios e investigadores están tratando de solucionar este problema.

La vida de Porcha Woodruff estaba empezando a tomar forma. Esta madre de dos hijos estaba planeando su boda y tenía un nuevo niño en camino. Sin embargo, el 16 de febrero de 2023 llamaron a la puerta. Varios policías de Detroit, Estados Unidos, detuvieron a Woodruff en su propia casa. La acusaban de un robo de coche.

"Lo único que pude pensar en ese momento fue: 'No quiero perder a mi hijo'", declaró la propia Woodruff a Business Insider el pasado verano, cuando pudo relatar lo que había ocurrido.

La policía había utilizado un nuevo programa de inteligencia artificial de reconocimiento facial que la identificó como sospechosa basándose en una antigua foto de ficha policial. El caso fue desestimado posteriormente, pero la detención de Woodruff sigue constando en el registro público del Tribunal del Distrito 36 de Michigan.

El Departamento de Policía de Detroit declaró entonces que el uso del programa de IA de reconocimiento facial estaba restringido a los delitos violentos y que las coincidencias que obtienía eran solo pistas de investigación. No obstante, dichas precauciones no fueron suficientes para Woodruff, que ha demandado a la ciudad estadounidense y a un detective de la policía por daños y perjuicios.

"No debería haber tenido que enfrentarme a algo así", asegura. "Me cambió la vida por completo".

La etnia y el sexo de Woodruff pueden haber sido un factor en su detención injusta. "No creo que esto le hubiera ocurrido a una mujer blanca", ha señalado Ivan Land, abogado de la demandante.

Dictar sentencia

La inteligencia artificial de reconocimiento facial, como la que utiliza el Departamento de Policía de Detroit, está diseñada para identificar rostros concretos a partir de grandes conjuntos de datos fotográficos. Es uno de los muchos tipos de IA que se utilizan en todo el mundo. Y —al igual que ocurre en muchos otros casos— el modelo presenta fallos.

Un estudio de 2018 realizado por los investigadores especializados en inteligencia artificial Joy Buolamwini y Timnit Gebru, que evaluaron las herramientas de reconocimiento facial de Microsoft, IBM y Face++, constató que las mujeres de piel más oscura eran las más propensas a ser identificadas erróneamente por la tecnología de reconocimiento facial, con una tasa de error de hasta el 35%.

Seis años después, la IA sigue cometiendo errores preocupantes, como identificar erróneamente a personas de piel más oscura y mostrar prejuicios cuando se enfrenta a un lenguaje asociado a interlocutores que no son blancos.

Una investigación publicada en marzo de este año, del que es coautor Valentin Hofmann, investigador del Allen Institute for AI, concluyó que cuando se utiliza el inglés afroamericano —AAE, por sus siglas en inglés— para preguntar a modelos como el GPT-4, de OpenAI, o el T5, de Google, las respuestas incorporan "un racismo encubierto en forma de prejuicios dialectales".

En el estudio se pedía a los modelos de inteligencia artificial que dictasen sentencia en casos penales hipotéticos en los que la única prueba era un enunciado del acusado en AAE o en inglés americano estándar. Cuando se utilizaba el AAE, los modelos tenían más probabilidades de condenar a los acusados.

En un hipotético juicio por asesinato, los modelos de IA propusieron con más frecuencia la pena de muerte para un angloparlante afroamericano.

Una propuesta novedosa

Uno de los motivos para que los modelos de inteligencia artificial presenten estos fallos es que las personas y empresas que desarrollan IA no son representativas del mundo que se supone que tienen que representar los modelos de inteligencia artificial.

En agosto de 1955, una propuesta para un nuevo campo de estudio del Dartmouth College —universidad de Nuevo Hampshire, EEUU— postulaba que la inteligencia podía ser artificial. Ocho investigadores, todos hombres blancos, se propusieron investigar cómo las máquinas podían razonar basándose en conexiones establecidas a través de datos que se les proporcionaban, gobernadas por conjuntos de reglas.

Casi 70 años después, los programas de formación en ciencias de la computación siguen teniendo un índice excesivo de participantes blancos y hombres.

El Centro Nacional de Estadísticas Educativas estadounidense informó de que, en 1991, los estudiantes blancos obtuvieron más del 70% de las licenciaturas en ciencias de la computación, mientras que los estudiantes negros obtuvieron alrededor del 8% de los títulos que se expidieron.

En 2022, el último año registrado, los estudiantes blancos obtuvieron alrededor del 46% de las licenciaturas en informática, frente al 9% de estudiantes negros. Los estudiantes asiáticos fueron los que más aumentaron en ese periodo, pasando de representar alrededor del 8% de las titulaciones a más del 19%.

Las grandes tecnológicas que lideran el desarrollo de la IA tampoco son especialmente diversas, a pesar de años de esfuerzos por mejorar esta situación. En 2023, el 13,6% de la población estadounidense se identificaba como negra o afroamericana. El informe DEI 2023 de Microsoft, por el contrario, indicaba que solo el 6,7% de la plantilla de la multinacional era negra.

Los límites de los datos

En la década de 1990, Geoffrey Hinton fue pionero en el desarrollo de redes neuronales de aprendizaje profundo —deep learning— inspiradas en el cerebro humano. Estas redes se configuran según el caso de uso (por ejemplo, para reconocer una cara) y deben entrenarse para emparejar patrones o inferir. Para ser buenos, estos modelos necesitan muchos datos.

"Los modelos no tienen suficientes datos negros. No existen", explica Christopher Lafayette, fundador de GatherVerse (una compañía de foros y eventos tecnológicos), a Business Insider.

Oji Udezue, director de producto de Typeform (una empresa de software para realizar encuestas), apunta que la limitada disponibilidad de los datos podría amplificar la desigualdad.

El acceso a internet en África y el Sudeste Asiático se ha desarrollado mucho más despacio que en Norteamérica y en Europa. Los datos online, que constituyen la base de la mayoría de los modelos de inteligencia artificial, son mayoritariamente blancos y occidentales.

"Los conjuntos de datos del Sur [global] no están online, no se pueden rastrear ni integrar", sugiere Udezue.

Por ejemplo, el rendimiento de las primeras herramientas de reconocimiento facial se medía a menudo con una referencia basada en más de 13.000 imágenes. Casi el 84% de las personas que aparecían en esas imágenes eran blancas.

El nuevo libro que ha presentado Buolamwini (el investigador especializado en IA), Unmasking AI ("Desenmascarando la IA"), cuenta que durante años esta herramienta ha sido la referencia para que compañías, como Meta (la matriz de Facebook), Google o Microsoft, evaluasen la precisión de sus herramientas de reconocimiento facial.

La inteligencia artificial ha sido desarrollada en gran medida por parte de investigadores blancos y entrenada con textos e imágenes occidentales. Quizá no deba sorprendernos que estos modelos ofrezcan respuestas que carecen de comprensión cultural y un rendimiento inferior a la hora de identificar a mujeres que tienen la piel más oscura.

Las grandes tecnológicas han reconocido algunos de estos problemas. OpenAI, la desarrolladora de ChatGPT, ha descrito los sesgos de sus herramientas como "errores, no funcionalidades" y ha prometido que está "trabajando para compartir información demográfica agregada" sobre las personas que revisan sus modelos de IA.

En algunas ocasiones, estas empresas han corregido este problema "en exceso". Por ejemplo, Gemini, el asistente de inteligencia artificial de Google, generó imágenes de personas negras en contextos históricamente inexactos (por ejemplo, formando parte de las filas del Tercer Reich alemán o de la tripulación del Apolo 11).

Algunos empresarios están intentando ofrecer alternativas. En mayo de 2023, John Pasmore fundó Latimer, un gran modelo lingüístico (LLM) que utiliza GPT-3.5 para sus capacidades básicas. Antes de responder a los usuarios, Latimer extrae información de su archivo de datos sobre personas negras en un proceso conocido como generación aumentada de recuperación.

Dicho proceso tiene el objetivo de ofrecer a los usuarios respuestas más elaboradas.

Desaprender la discriminación

A pesar de la rápida evolución del desarrollo de la IA, algunos investigadores y empresarios intentan incorporar a esta tecnología datos diversos y enfoques más equitativos.

"Podemos utilizar la inteligencia artificial para superar los prejuicios humanos", afirma Buolamwini, el investigador especializado. "Si no atendemos a las diferencias y no somos intencionados a la hora de ser inclusivos, corremos el riesgo de revertir los avances ya logrados".

Desaprender el hábito de la discriminación no es fácil. Las máquinas hechas a imagen y semejanza de sus creadores portan las peculiaridades, idiosincrasias y prejuicios de estas personas, por muy bienintencionadas que estas sean.

"Tanto si es consciente como inconsciente, creo que es más una funcionalidad que un error", explica a Timothy Bardlavens, director de equidad de producto de Adobe, a este medio de comunicación.

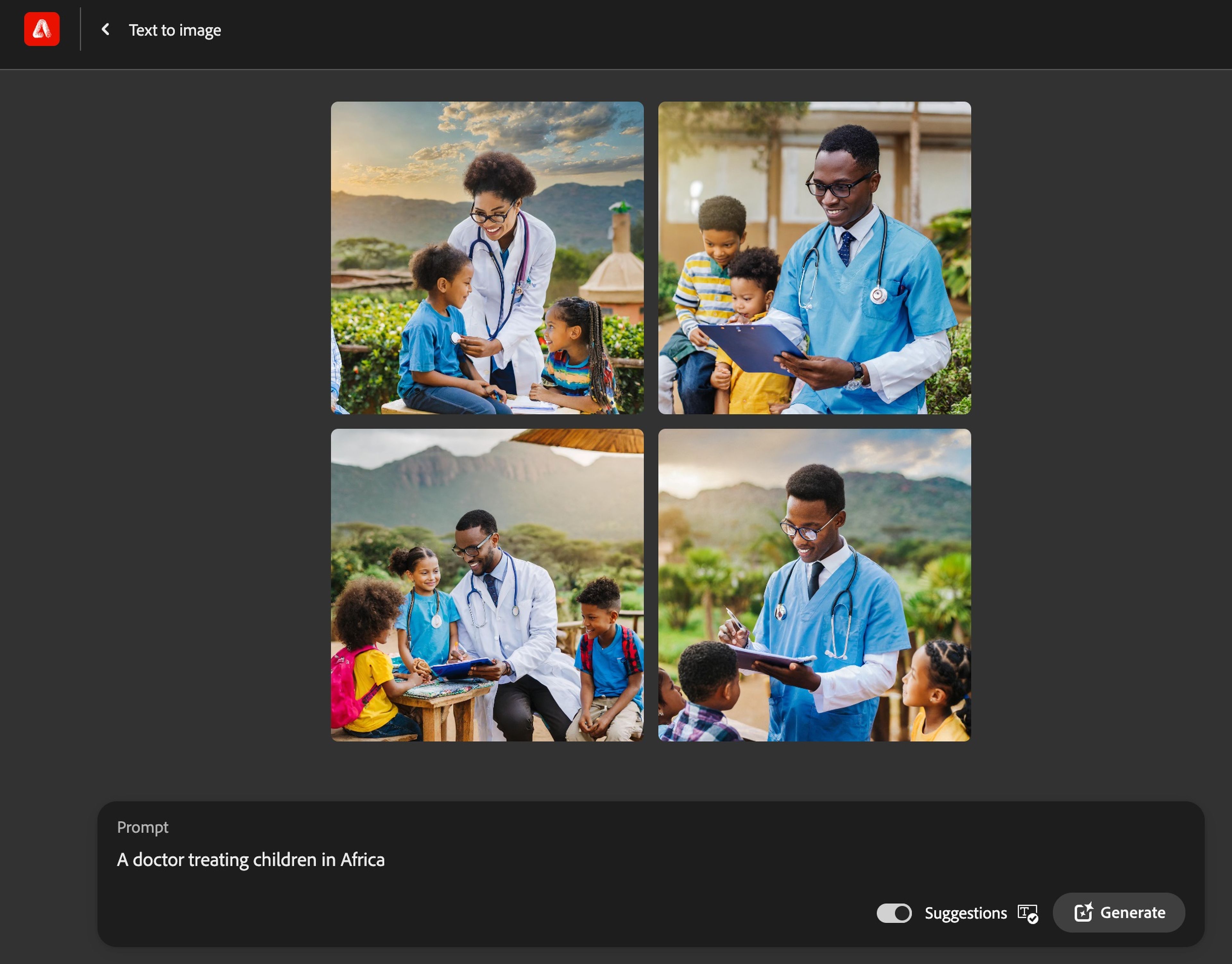

Bardlavens dirige un equipo cuyo objetivo es garantizar que la equidad se tenga en cuenta y se incorpore a las herramientas de IA de Adobe. Su generador de imágenes Firefly, por ejemplo, está diseñado para evitar estereotipos en la representación de grupos como las mujeres o las personas racializadas.

Cuando un usuario le pide a Firefly que genere imágenes de un médico atendiendo a niños en África, la herramienta ofrece imágenes de médicos y médicas negros:

Adobe

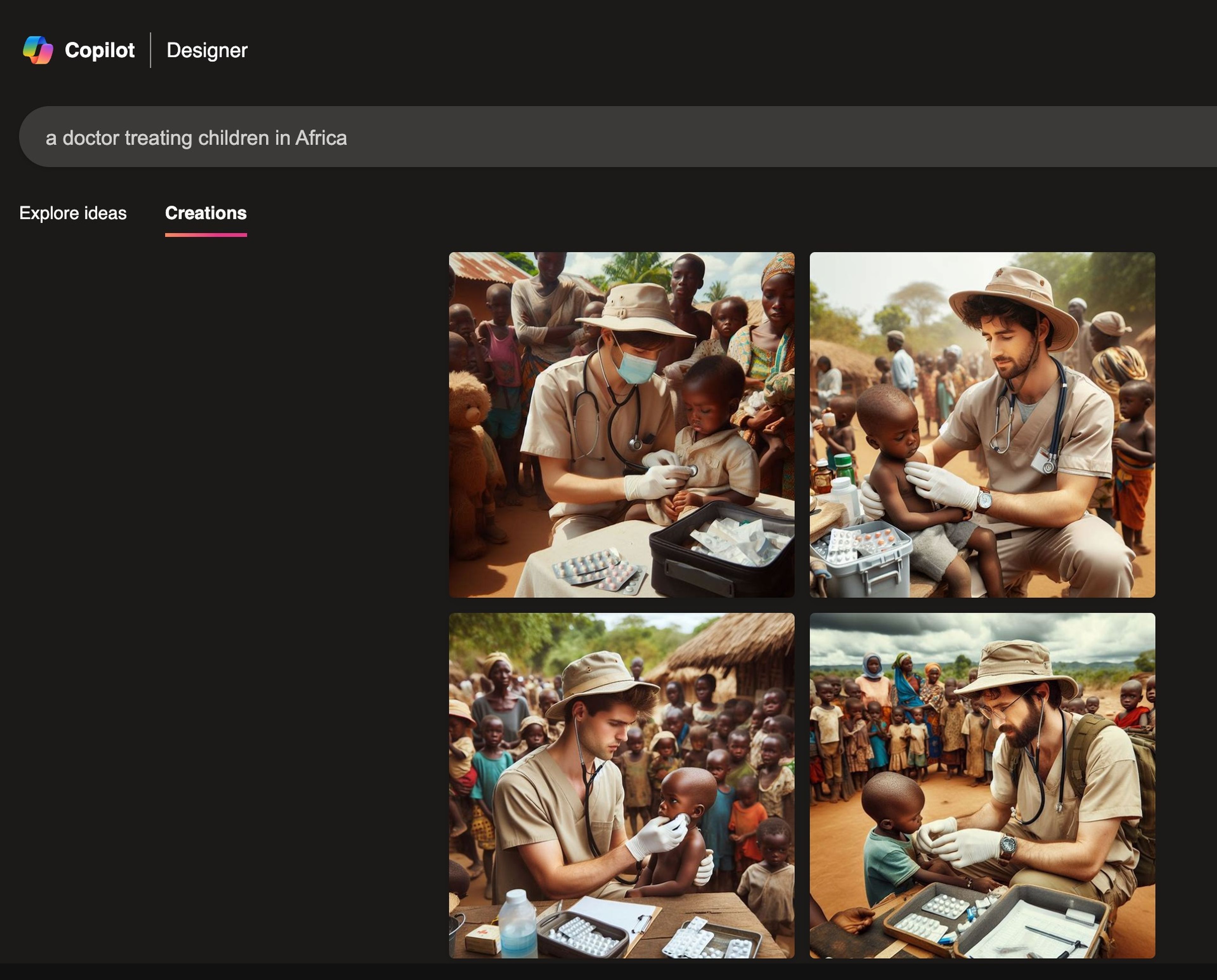

En cambio, cuando un usuario le hace esa misma petición al generador de imágenes de Microsoft, Copilot Designer, esta herramienta —al menos a fecha de 18 de marzo— devuelve imágenes de facultativos hombres y blancos:

Microsoft

Según el directivo de Adobe, son pocas las compañías que desarrollan tecnología a través de la cocreación, que consiste en obtener aportaciones de personas ajenas a las empresas de inteligencia artificial para incorporar sus experiencias al desarrollo de productos.

Sin esto, "se pierde el valor de contar con la opinión de las comunidades sobre sus experiencias", añade Bardlavens. "Es imposible desarrollar tecnología que de alguna manera no amplifique las creencias del creador".

Existe una oportunidad cada vez mayor para la inclusión si se presta una mayor atención a quién desarrolla los modelos de IA y a los datos con los que estos se entrenan.

Por ejemplo, Esther Dyson, la famosa inversora, se convirtió en la primera interesada en invertir en Latimer porque vio el potencial de la startup para hacer frente a la preocupante tendencia de la inteligencia artificial a ignorar la historia y la cultura de las personas negras.

"La IA no resolverá todos estos problemas, pero hará lo que los humanos le pidamos que haga. Utiliza a Latimer, pídele que encuentre la historia que estaba oculta", ha asegurado la propia Dyson a Business Insider. "El valor de la inteligencia artificial no está en los núcleos, sino en los bordes y en la relación entre los tipos de datos".

La inversora ha argumentado que las compañías que le dan prioridad al entrenamiento de sus modelos con los datos mejores y más representativos serán, en última instancia, las que tengan más éxito.

Los esfuerzos de Alza

Arturo Villanueva recuerda haber servido de intermediario entre sus padres y el sistema bancario estadounidense a la tierna edad de 9 años.

"Llamaba al banco, hablaba con ellos en inglés, luego hablaba con mis padres en español y luego me metía en problemas por no ser capaz de traducir palabras como 'hipoteca' o 'con intereses'", cuenta. "Y yo decía: 'Sólo tengo 9 años, ¿cómo voy a hacer esto?".

Villanueva es el fundador y CEO de Alza, una fintech, que utiliza técnicas de IA como la visión artificial y el aprendizaje automático para ayudar a las personas latinas y a otros hispanohablantes a acceder mejor a servicios financieros como cuentas de ahorros, cuentas corrientes o pagos transfronterizos.

Estos consumidores a veces tienen historiales de crédito más cortos o documentos de identificación que los bancos consideran inusuales.

Las herramientas bancarias de Alza, basadas en inteligencia artificial, están diseñadas para interactuar con personas que hablan muchos dialectos coloquiales del español y para adaptarse mejor a los tipos de documentos de solicitud con los que los bancos tradicionales pueden tener problemas, como los documentos de identidad emitidos por algunos países latinoamericanos.

Aun así, Alza está adoptando la IA con cautela, dados los problemáticos orígenes de la tecnología.

"Estamos utilizando la inteligencia artificial con cautela", sugiere Andrew Mahon, responsable de ingeniería de Alza. "Saltar demasiado rápido a la IA es arriesgarse a desplegar un modelo sesgado que podría malinterpretar nuestros datos".

Otros artículos interesantes:

Conoce cómo trabajamos en Business Insider.