Amazon dominó la llegada de la nube, pero el auge de la IA ha dado pie a la nube 2.0 y ya no parte con ventaja

Michael M. Santiago/Getty

- La nube 1.0 estuvo dominada por Amazon Web Services.

- El auge de la inteligencia artificial generativa ha dado paso a la era de la nube 2.0, pero esta vez Amazon no parte con ventaja y va a necesitar ayuda para alcanzar a Nvidia.

Cuando construyes una casa, puedes hacerlo de varias formas.

Puedes conseguir todas las herramientas que necesites y luego adentrarte en un bosque para cortar madera y convertirla en vigas y en pilares.

O puedes ir a Leroy Merlin y comprar madera ya cortada, junto con todos los clavos, martillos y demás utensilios que necesites.

O puedes pagar a un constructor para que haga la mayor parte del trabajo.

En los últimos 15 años, Amazon Web Services (AWS) se ha convertido en el constructor de referencia para cualquiera que quería construir algo en internet.

Una página web, una aplicación, un servicio de software empresarial. Hoy en día, muy pocos desarrolladores se aventuran en el bosque digital y cortan sus propios semiconductores y construyen sus propios servidores y centros de datos. AWS lo hace todo por ti y te proporciona la mayoría de las herramientas que necesitas.

Esto es lo que ha hecho que esta compañía pase de ser una idea lejana, como lo era en el año 2006, a un negocio de 80.000 millones de dólares —unos 76.000 millones de euros al tipo de cambio actual— con jugosos márgenes de beneficio y una base de clientes enorme y consolidada.

Es la esencia de una plataforma tecnológica.

El auge de la inteligencia artificial generativa ha creado lo que algunos expertos en tecnología denominan "nube 2.0". Hay una nueva gama de hardware, software, herramientas y servicios que impulsarán las aplicaciones de IA en los próximos años. ¿Qué empresa será el constructor de este nuevo mundo?

Cuando estés construyendo tu casa de inteligencia artificial, ¿a quién vas a recurrir para conseguir toda esa madera y las herramientas necesarias para hacer bien el trabajo?

Por el momento, parece que AWS no va a ser el líder, ya que Nvidia parte con una enorme ventaja.

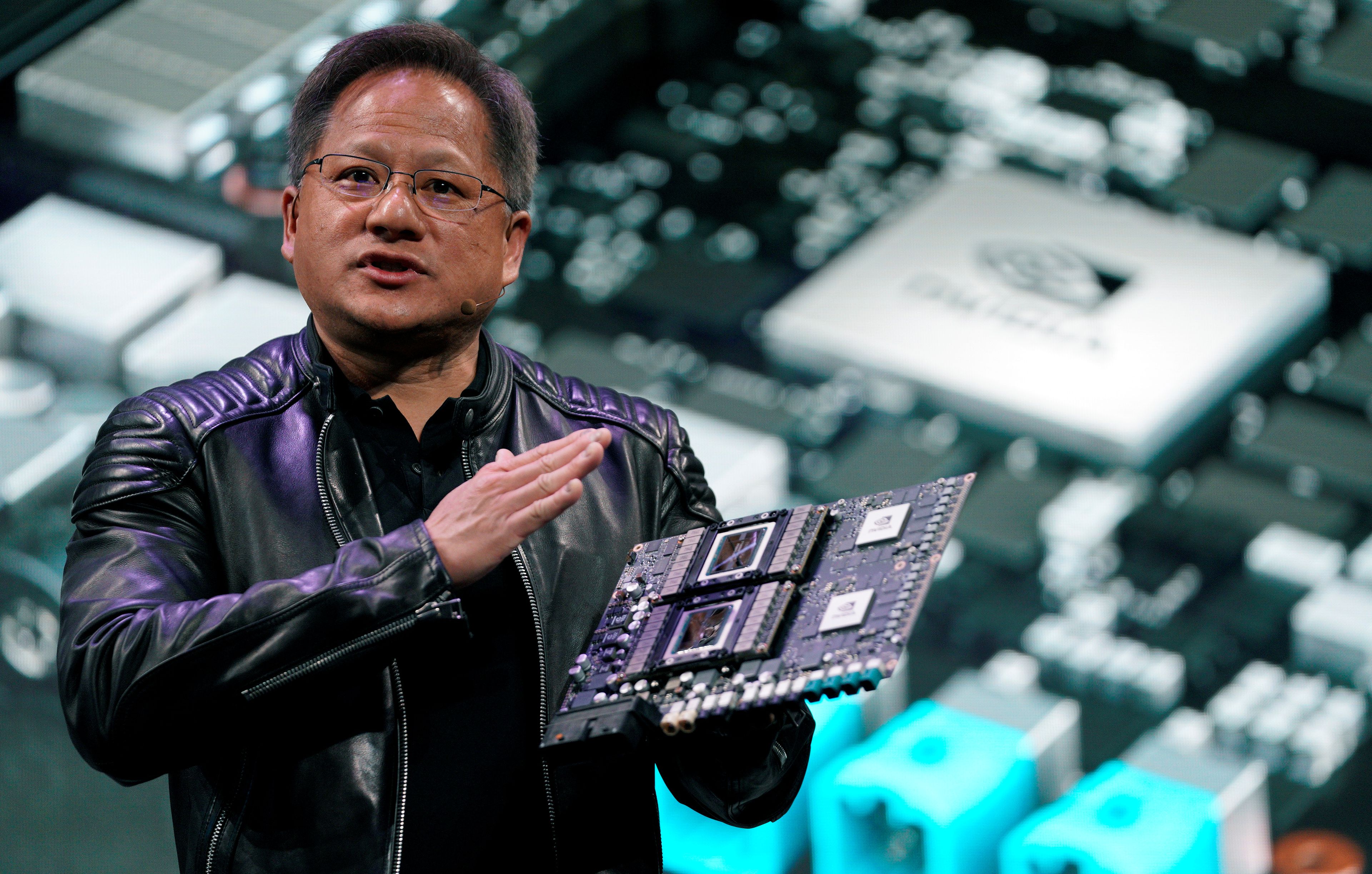

REUTERS/Rick Wilking

Nvidia lleva años diseñando y vendiendo tarjetas gráficas (GPU, por sus siglas en inglés), el chip de referencia utilizado por casi todo el mundo que está desarrollando grandes modelos lingüísticos y otros grandes modelos de IA.

Los investigadores de inteligencia artificial ya utilizaban estos componentes hace más de una década, cuando Andrew Ng y otros expertos descubrieron que las GPU podían realizar muchos cálculos en paralelo. En cambio, Amazon Web Services lanzó su tarjeta gráfica Trainium para el entrenamiento de modelos de IA en diciembre de 2020, casi una década después.

Durante esa década, Nvidia también construyó una plataforma en torno a sus GPU que ayudó a los desarrolladores de inteligencia artificial a hacer su trabajo. La compañía desarrolló compiladores, dirvers, un sistema operativo, herramientas, bibliotecas de código, notas y vídeos de formación y mucho más. El núcleo de esta plataforma es un lenguaje de programación llamado CUDA.

En la actualidad hay más de 4 millones de desarrolladores de Nvidia registrados que utilizan CUDA y todas sus herramientas relacionadas. Esta cifra es superior a los dos millones de agosto de 2020 y al millón de dos años antes. Lo más parecido que tiene AWS ahora mismo se llama Neuron, que, según su página de Github, fue lanzado en el 2019. CUDA salió 12 años antes, en el 2007.

Bibliotecas, modelos y entornos

Michael Douglas, un antiguo ejecutivo de Nvidia, habló recientemente con los analistas de Bernstein sobre todo esto, explicando que el software y las herramientas del fabricante de microchips están muy por delante de los de su competencia:

- Hay 250 bibliotecas de software a disposición de los desarrolladores que se asientan sobre CUDA. Una biblioteca es un código prediseñado que realiza una función, como ejecutar vídeo o audio, o hacer algo con gráficos.

- También existen 400 modelos prediseñados que Nvidia ofrece a los desarrolladores para tareas de IA como el reconocimiento de imágenes y la síntesis de voz.

- Estas bibliotecas y modelos se integran con entornos populares como PyTorch, TensorFlow, Windows o VMware.

- Todo ello se asienta sobre 65 plataformas. Una plataforma proporciona la mayor parte del resto del software que los desarrolladores necesitan para operativizar algo en un entorno en un centro de datos, o al límite, con inteligencia artificial.

"Lo que esto significa es que, es como si quisieras construir una casa, la diferencia entre ir al bosque y tener que talar tus propios árboles y hacer tus propias herramientas o ir a Home Depot, donde compras la madera y las herramientas y consigues que todo funcione a la vez", señaló Douglas.

La nube 2.0

Otro punto clave: la mayoría de los desarrolladores de IA ya saben utilizar tanto CUDA como las GPU de Nvidia. Todos los trucos y atajos están arraigados en la comunidad.

Podría decirse que Nvidia ya ha creado una plataforma de inteligencia artificial en la nube, como en su día hizo AWS en la era de la nube 1.0. A medida que llega la nube 2.0, va a ser más difícil para AWS, o para cualquier otro competidor, acabar con esto.

"Nvidia lleva mucho tiempo apostando por la IA. Tienen un nivel de madurez de software que ningún otro proveedor puede igualar", afirma Luis Ceze, CEO y cofundador de la startup de inteligencia artificial OctoML. "Con silicio personalizado para IA, existe una fuerte necesidad de un conjunto de software de sistema maduro y fácil de usar".

El bucle de retroalimentación Amazon-Anthropic

Sin embargo, todavía no hay que descartar a AWS. Es pronto, como repiten Andy Jassy y Adam Selipsky (CEO de Amazon y CEO de AWS, respectivamente). James Hamilton es un genio de la infraestructura en la nube de Amazon Web Services que puede enfrentarse a Nvidia, aunque el fabricante de chips lleve mucha ventaja.

"Nvidia tiene el mercado asegurado gracias a sus ventajas en software", asegura Oren Etzioni, director técnico de AI2 Incubator y socio de Madrona Venture Group. "Se puede argumentar que esta ventana está empezando a cerrarse".

La carrera de la nube 2.0 arrancó realmente hace apenas unos días, cuando Amazon anunció una inversión de hasta 4.000 millones de dólares —unos 3.800 millones de euros— en una startup de inteligencia artificial llamada Anthropic.

Esta empresa, relativamente pequeña y con sede en San Francisco (Estados Unidos), está repleta de investigadores que ayudaron a desarrollar el modelo GPT, que se sitúa en el corazón de la herramienta que ha dado lugar al boom de la IA generativa. Anthropic tiene uno de los modelos de inteligencia artificial más capaces que existen: Claude.

Cortesía de Anthropic

A partir de ahora, Anthropic va a poder utilizar los chips internos Trainium e Inferentia de AWS para desarrollar, entrenar e implementar sus futuros modelos de IA y las dos compañías van a poder colaborar en el desarrollo de futura tecnología.

Una pieza clave aquí es el bucle de retroalimentación entre Anthropic y Amazon Web Services. Los pioneros de la inteligencia artificial de Anthropic se han comprometido a utilizar las GPU de AWS, junto con todo el software y las herramientas asociadas. Si AWS tiene carencias en este sentido, Anthropic puede ayudar a identificar los mayores defectos y sugerir formas de subsanarlos.

Para alcanzar a Nvidia, Amazon necesitaba un desarrollador tan importante como este. Todo lo que necesitaba eran entre 1.000 y 4.000 millones de euros.

"Amazon necesita un actor importante de IA que utilice su propio silicio", argumenta Ceze. "Que AWS pueda enseñarle a Anthropic sus cargas de trabajo es una victoria. Quieren que otras personas que construyen modelos de inteligencia artificial se sientan seguras de que su silicio es bueno y su software está listo".

Evitar el impuesto de Nvidia

Fabricar tus propios chips de IA es una ventaja realmente importante para ganar la carrera de la nube 2.0. Si AWS tiene que seguir comprando tarjetas gráficas de Nvidia, va a tener que pagarle un margen al fabricante (algunos expertos en inteligencia artificial llaman a ese precio el impuesto Nvidia). Eso va a encarecer los servicios en la nube de Trainium e Inferentia de AWS.

Si, por el contrario, Amazon puede fabricar sus propios chips de IA, se va a poder quedar con el margen de beneficio de Nvidia, lo que significa que va a poder ofrecer servicios en la nube de entrenamiento e inferencia de inteligencia artificial que sean más rentables.

En un reciente evento de la tecnológica en Seattle, el CEO de AWS, Selipsky, insistió en este mensaje: sus servicios en la nube van a ser competitivos basándose en el "rendimiento del precio". Esto significa que debería ser más eficiente construir modelos de IA en AWS, explicó el CEO.

Noah Berger/Getty Images for Amazon Web Services

En la era de la nube 1.0, Amazon consiguió esto gracias —en parte— a la adquisición de Annapurna Labs en 2015. Esta startup ayudó a Amazon a diseñar sus propias tarjetas gráficas, Gravitron, para sus centros de datos. De repente, AWS ya no necesitaba comprar tantos chips Xeon a Intel. Este fue un elemento importante que convirtió a la empresa en un proveedor competitivo y exitoso.

¿Cómo de fácil es reemplazar a Nvidia?

Aquí está el problema: puedes tener buenos chips de inteligencia artificial y buenos precios, pero, ¿alguien va a dejar de usar las GPU de Nvidia y la plataforma CUDA? Si no lo hacen, puede que Amazon no gane la batalla de la nube 2.0 de la misma forma que lo hizo con la nube 1.0.

Esto conduce de nuevo a la analogía de la construcción de casas. Por el momento, Nvidia ofrece probablemente la mejor combinación de madera y herramientas para hacer el trabajo. Si ya estás usando esto, ¿vas a poder cambiar fácilmente?

Sharon Zhou es la cofundadora de Lamini AI, una startup que se pasó varios meses desarrollando un centro de datos desde cero para ayudar a sus clientes a entrenar modelos de IA. Cuando se presentó en septiembre, la sorpresa fue que Lamini utilizaba tarjetas gráficas de AMD en lugar de los chips de Nvidia.

¿Cómo fue el proceso? Zhou dice que Lamini ni siquiera lo intentó porque hubiese sido muy complicado.

"Nunca cambiamos. Fundamos la empresa con la tecnología de AMD. Por eso funciona", apunta. "Cambiar sería más difícil que empezar de cero. Si quieres cambiar, tendrías que aplicar una refactorización importante de toda tu base de código".

Zhou hace referencia a uno de los argumentos a los que también se refería Douglas (el exdirectivo de Nvidia): las librerías de inteligencia artificial y otros entornos de desarrollo, y herramientas en torno a CUDA están más desarrollados.

"Hoy en día, las bibliotecas están muy integradas en Nvidia", expresa la experta. "Es necesario volver a implementar las capacidades fundamentales para trabajar con grandes modelos lingüísticos. Aparte de los fundamentos, también es necesario hacerlo para otras bibliotecas comunes".

Las trabas de Nvidia

Etzioni, el director técnico de AI2 Incubator, indica que Nvidia todavía le pone dos grandes trabas a los desarrolladores de IA que no quieran utilizar su tecnología.

El primero es que PyTorch, un entorno de inteligencia artificial, está muy bien optimizado para CUDA y, por tanto, para las GPU de Nvidia. OctoML, la startup que dirige Ceze, está trabajando en una serie de correcciones técnicas con las que espera facilitar a los desarrolladores el uso de cualquier GPU con diferentes entornos y plataformas en el futuro, incluidas las que ofrece AWS.

En segundo lugar, una vez que puedas conectarte de forma eficiente a otra pila de software de IA, esa plataforma alternativa tiene que ser al menos tan buena como CUDA. "Y las alternativas aún no existen", afirma Etzioni.

Según este experto, en este momento AMD puede ser la que más se acerque a Nvidia. Este fabricante de chips cuenta con ROCm, una plataforma de software que ofrece a los desarrolladores de inteligencia artificial acceso a lenguajes, bibliotecas y herramientas populares.

En cambio, Etzioni no menciona ni a AWS ni Trainium.

Conoce cómo trabajamos en BusinessInsider.

Etiquetas: AmazonTrending, Inteligencia artificial, Cloud computing