¿Cómo decide ChatGPT qué debe decir? Aquí tienes una breve explicación

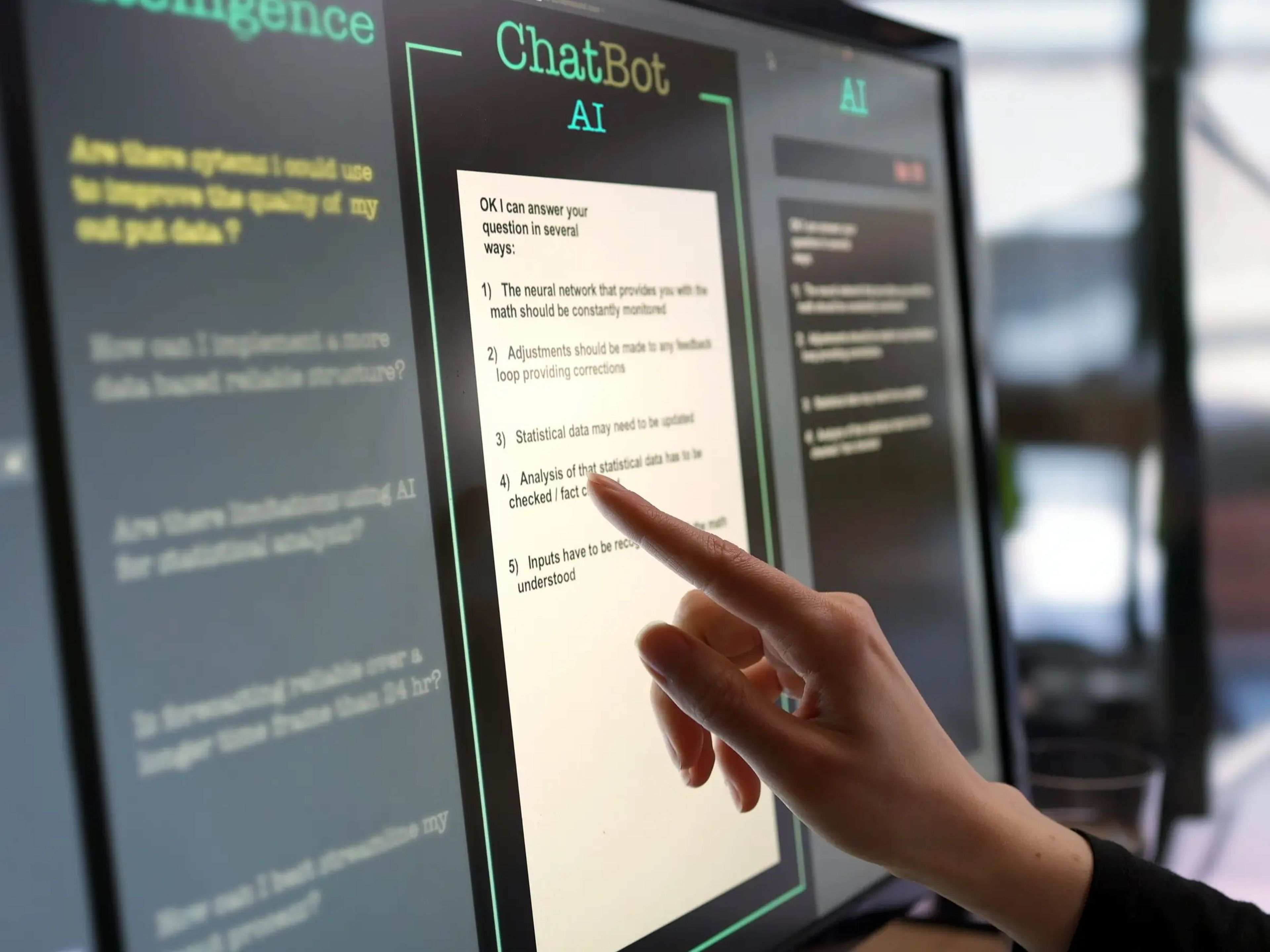

Laurence Dutton/Getty

- La tecnología que permite que los generadores de texto por inteligencia artificial como ChatGPT funcionen se basa en grandes modelos lingüísticos que reciben una gran cantidad de información.

- Estas herramientas también son entrenadas por humanos que ayudan al sistema a "aprender" la respuesta correcta: aquí tienes una breve explicación de cómo elige ChatGPT lo que tiene que decir de la mano de expertos en la materia.

ChatGPT y otros chatbots basados en inteligencia artificial pueden hablar utilizando oraciones fluidas y gramaticalmente correctas, con un ritmo que parece natural.

Sin embargo, los expertos aseguran que no hay que confundir un diálogo bien articulado con el pensamiento, la emoción o incluso la intención.

El funcionamiento de estos generadores de texto se parece mucho más al de una máquina que realiza cálculos matemáticos y análisis estadísticos para encontrar las palabras y frases adecuadas según el contexto. Detrás hay mucho entrenamiento —realizado incluso por entrenadores humanos que ofrecen retroalimentación— que ayuda a simular conversaciones reales.

Los chatbots como ChatGPT también aprenden a partir de muchas conversaciones que enseñan a las máquinas a interactuar con los seres humanos. OpenAI, la desarrolladora de ChatGPT, afirma en su página web que sus modelos se entrenan a partir de información procedente de diversas fuentes, incluidos sus propios usuarios y material del que tiene licencia.

Así funcionan estos chatbots:

Los generadores de texto por inteligencia artificial como ChatGPT se basan en grandes modelos lingüísticos (LLM, por sus siglas en inglés), que son programas entrenados en volúmenes de texto obtenidos de textos publicados e información online: generalmente contenido producido por humanos.

Según los expertos, los sistemas se entrenan con series de palabras y aprenden la importancia de las palabras que conforman esas series. De ese modo, todo ese conocimiento adquirido no solo sirve para entrenar grandes modelos lingüísticos sobre información objetiva, sino que les ayuda a adivinar patrones de habla y cómo se suelen usar y agrupar las palabras.

Los chatbots también reciben formación adicional de los humanos sobre cómo ofrecer respuestas adecuadas y limitar los mensajes dañinos.

"Se puede decir: 'Esto es tóxico, esto es demasiado político, esto es opinión', y acotarlo para que no genere esas cosas", explica Kristian Hammond, profesor de informática de la Universidad Northwestern. Hammond también es director del Centro para el Avance de la Seguridad de la Inteligencia Artificial de su universidad.

Cuando una persona le pide a un bot que responda a una pregunta de forma objetiva, el proceso puede ser sencillo: despliega un conjunto de algoritmos para elegir la frase más probable con la que responder. Entonces escoge las mejores respuestas posibles en cuestión de milisegundos y, de entre ellas, presenta una al azar.

Es por eso que la misma pregunta varias veces puede generar respuestas ligeramente distintas. La máquina también puede dividir las preguntas en varias partes, responder a cada una de ellas por separado y utilizar las distintas respuestas para terminar de responder.

Digamos que le pides al bot que mencione a un presidente de Estados Unidos que comparta nombre con el protagonista de la película Camelot. La IA primero podría responder que el actor en cuestión es Richard Harris y luego usar esa respuesta para ofrecerte Richard Nixon como respuesta a tu pregunta original, detalla Hammond.

"Sus propias respuestas pasan a formar parte de la pregunta", añade.

Pero cuidado con lo que los chatbots no saben

¿Qué pasa cuando le haces una pregunta a la inteligencia artificial y no sabe la respuesta? Ahí es donde los chatbots generan más problemas debido a una característica inherente: no saben lo que no saben. Así que extrapolan lo que saben, es decir, realizan conjeturas.

El problema es que no te dicen que están haciendo suposiciones, sino que presentan esa información como si fuese veraz. En este campo, cuando un programa ChatGPT le ofrece a un usuario una conjetura como si fuese un hecho, se denomina "alucinación".

"Esto es lo que llamamos conocimiento del conocimiento o metacognición", explica William Wang, profesor de Informática en la Universidad de California en Santa Bárbara. Wang también es codirector del grupo de procesamiento del lenguaje natural de su centro.

"El modelo en realidad no entiende muy bien las cosas desconocidas que se conocen", concluye este experto.

Otros artículos interesantes:

Conoce cómo trabajamos en Business Insider.