Adrián Rodríguez investiga en el MIT por qué la visión artificial a veces se confunde: "El hecho de que este problema exista impide usar la IA en algunos casos"

Cortesía de Adrián Rodríguez

- Antes de que ChatGPT generase interés por los generadores de texto por inteligencia artificial, herramientas como Midjourney o Stable Diffusion hacían lo propio con los generadores de imágenes.

- Más allá de estos chatbots, el uso de IA en el procesamiento de imágenes ha demostrado ser una auténtica revolución, pero investigadores del MIT como Adrián Rodríguez deben hacer frente a los retos que plantea su implementación.

El éxito que ha experimentado ChatGPT, convirtiéndose —hasta hace poco— en la plataforma que más rápido ha alcanzado los 100 millones de usuarios, ha provocado que su nombre quede ligado de forma casi indisoluble al de la inteligencia artificial. Sin embargo, la IA lleva tiempo demostrando que puede ir mucho más allá.

Herramientas como Midjourney o DALL-E, que también ha sido desarrollada por la empresa de ChatGPT, OpenAI, ya copaban titulares hace casi un año; y algunos programas mucho menos avanzados que estos chatbots de IA, como Craiyon, ya atraían la atención de los usuarios en redes sociales en julio del 2022.

En algunas ocasiones, cuando estas herramientas llegan a los usuarios, las compañías tecnológicas y los centros de investigación llevan meses e incluso años trabajando con ellas. Además, al tratarse de cuestiones tan disruptivas como puede ser el caso de la inteligencia artificial, algunos usuarios solo llegan a imaginar algunos de los miles de usos que estas tecnologías pueden ofrecer.

En el caso de la IA generativa, los usuarios se han volcado a generar textos con los que poder mejorar significativamente su productividad y se han dedicado a generar imágenes con las que han llegado a ganar concursos de arte. En cambio, los expertos en la materia han demostrado que los usos de esta tecnología van mucho más allá.

Leticia Izquierdo, por ejemplo, es una investigadora española que estudia un posgrado en el Instituto Tecnológico de Massachusetts —MIT, por sus siglas en inglés— en el que utiliza la inteligencia artificial para diseñar ciudades que sean más atractivas para sus ciudadanos.

Por su parte, la estudiante española Paula Cordero cursa un máster en el Imperial College London —Universidad Imperial de Londres— en el que está utilizando la IA para desarrollar un método con el que poder predecir la magnitud de los terremotos y así fabricar edificios de formas más eficientes.

La startup Happyrobot, que ha sido seleccionada por la aceleradora más exclusiva de Silicon Valley (Y Combinator), es otro ejemplo de la diversidad de aplicaciones que ofrece la inteligencia artificial. En su caso, utilizan computer vision o visión artificial para poder detectar objetos en imágenes satelitales de una forma mucho más rápida que como se hacía anteriormente.

En el campo de la visión artificial también trabaja Adrián Rodríguez, un estudiante español que cursa un doctorado en el MIT y que investiga acerca de uno de los problemas que limitan el desarrollo de esta tecnología, los denominados como "ejemplos adversarios".

"Son ejemplos que están construidos deliberadamente para confundir al modelo de IA"

Rodríguez ha podido acceder al doctorado en el MIT gracias a una beca de la Fundación "la Caixa" para cursar estudios de posgrado en el extranjero y cuenta a Business Insider España que algunos de sus compañeros fueron quienes le dijeron que existía esta posibilidad.

"Hay un grupo de estudiantes que aplica cada año y ahí me comentaron que es una beca como muy buena, que, aparte del esfuerzo económico, te permite hacer investigación y también hay un componente de networking, de conocer gente, que es muy importante", explica.

El estudiante barcelonés obtuvo la beca y pudo acceder al proceso de formación en el Instituto Tecnológico de Massachusetts. "En el MIT llevo desde el septiembre pasado, llevo ya un año investigando y también dando clases", cuenta Rodríguez, que elogia la estructura del centro de investigación estadounidense porque ofrece a sus doctorandos la posibilidad de sacarse un máster.

"Está muy bien porque aparte también ahí hay una docencia muy buena, entonces si hay algo que quieres investigar y que quizá no has hecho del todo en la carrera, ahí puedes aprender cosas nuevas que luego te pueden ayudar", asegura.

Rodríguez trabaja bajo la supervisión del profesor Antonio Torralba, un investigador del MIT que también coordinó su Trabajo Final de Grado: "Yo desde el día uno sabía que quería trabajar con Antonio".

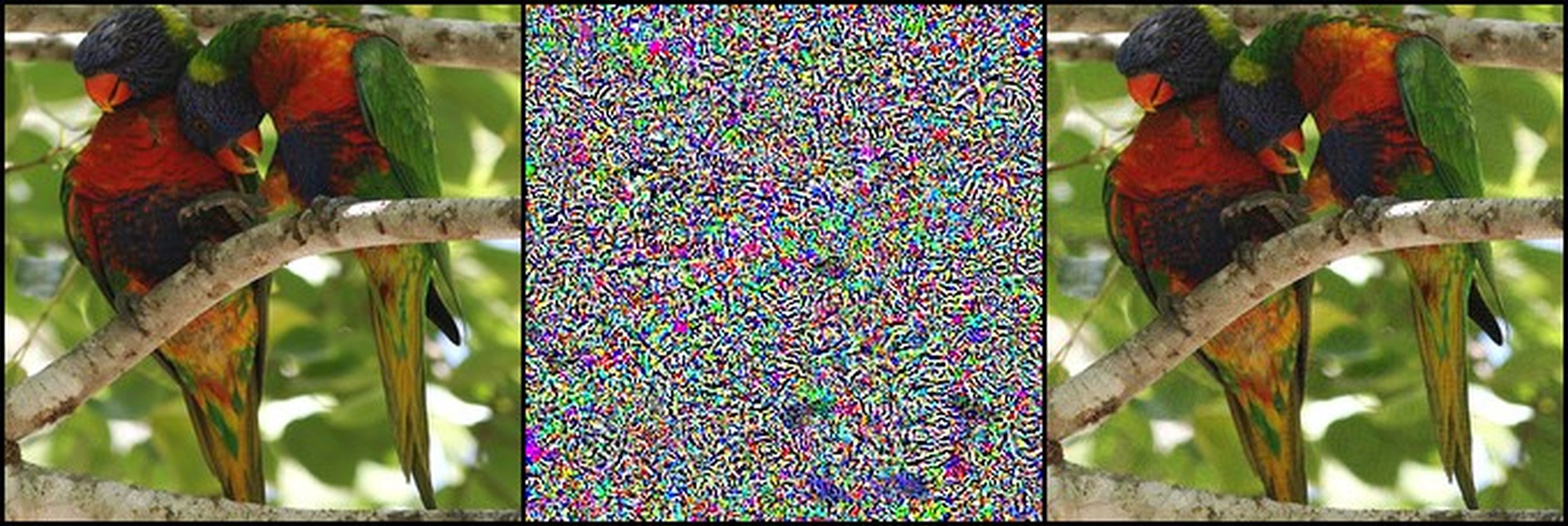

Al preguntarle por el objeto de su investigación, el doctorando apunta que se trata de un tema difícil de traducir: "En inglés se les llama adversarial examples. Son ejemplos que están construidos deliberadamente para confundir al modelo de inteligencia artificial".

"Como yo lo explicaría es: que por todas las cosas impresionantes que pueden hacer los modelos de IA de hoy en día", apunta Rodríguez, "aún tiene unos problemas fundamentales bastante graves".

El estudiante trata de explicarlo con un ejemplo práctico: "Tú coges una imagen y te dice si hay un coche o una persona, y eso te lo puede decir con una tasa de acierto del 98%, una cosa absurda, que de hecho creo que hasta lo hace mejor que las personas".

"Tú puedes coger esta imagen, que la máquina tiene clarísimo qué es y le puedes añadir unos cambios minúsculos, que una persona ni se enteraría de que están ahí o si se entera ve que hay una cosa rara, pero no cambiaría su opinión sobre lo que es la imagen, y en el modelo pasa de decir lo que es con un 99% de acierto a estar un 99% seguro de algo que no es", argumenta.

El investigador sostiene que esto "es un problema serio que tiene la inteligencia artificial", porque "cambia de opinión radicalmente cuando la imagen en realidad no ha cambiado nada".

"Necesitas tener unas garantías muy fuertes de que no la va a liar"

Al trasladar este problema a los usos prácticos en los que se utilizan sistemas de IA, en cuestiones tan fundamentales como la conducción autónoma de vehículos o el diagnóstico de enfermedades como el cáncer, la gravedad del mismo se incrementa exponencialmente.

"El hecho de que estos problemas existan no te permite usar la inteligencia artificial en algunas aplicaciones", expresa Rodríguez. "Supón que tienes una IA que está conduciendo un coche... Si hay niebla o si una señal está un poco tocada, por desgaste o por cualquier tontería, no tener ninguna confianza de que lo va a hacer bien no permite usar IA en algo tan crítico".

Cortesía de Adrián Rodríguez

El doctorando del MIT asevera que "necesitas tener unas garantías muy fuertes de que no la va a liar, si existen esos ejemplos adversarios no lo puedes usar de buena fe". Rodríguez se muestra tajante, ya que, según él, no se trata de algo que tiene un margen de error del 1%, sino que el sistema pasa directamente a "hacerlo completamente mal".

"En ChatGPT tú le puedes pedir consejos: 'Cómo escribo esta frase' o 'haz que esto rime'", ejemplifica el estudiante, refiriéndose a que, cuando hay una persona en medio, el riesgo se minimiza. "Si se equivoca, no pasa nada, porque tú estás ahí para verificarlo, pero en un sistema donde no hay una persona de por medio y las consecuencias de un error son graves, no puedes usar una IA ahora mismo".

En ese sentido, la propuesta de Rodríguez y el equipo de investigación al que pertenece en el MIT consiste intentar aprovechar el inmenso potencial que han demostrado tener los modelos de inteligencia artificial con lo que trabajan para solventar el problema de los ejemplos adversarios sin tener que crear un nuevo modelo.

"Es como un malgasto volver a hacerlo cada vez", explica. "Un componente importante de la investigación ahora es: 'Vale, tenemos estos modelos ya entrenados, ¿cómo trabajamos por encima de ellos para no reinventar la rueda y no tener que rehacer todo ese trabajo?'".

El estudiante defiende el papel que juega la regulación de la tecnología como medida para que no se agraven problemas como el de los ejemplos adversarios.

"Cualquier herramienta que tiene un potencial para hacer el bien, tiene un potencial para hacer el mal si se hace un uso indebido", asegura. "La IA es algo que puede tener efectos positivos y que puede ayudar mucho a las personas, pero que se debe controlar. Simplemente se regula para asegurarse de que esos usos negativos no existan y al final todos salimos ganando".

Rodríguez concluye que para que la IA llegue a todos los ámbitos de manera ética, "este problema de los ejemplos adversarios es algo que se debe solucionar". "Ahora mismo hay técnicas para limitar el impacto que tienen, pero no está solucionado del todo. Hasta que no se eliminen por completo, que aún estamos lejos de ello, hay muchos ámbitos donde no puedes usar IA".

Otros artículos interesantes:

Descubre más sobre Ramón Armero, autor/a de este artículo.

Conoce cómo trabajamos en Business Insider.